分类目录:《深入理解深度学习》总目录

相关文章:

· BERT(Bidirectional Encoder Representations from Transformers):基础知识

· BERT(Bidirectional Encoder Representations from Transformers):BERT的结构

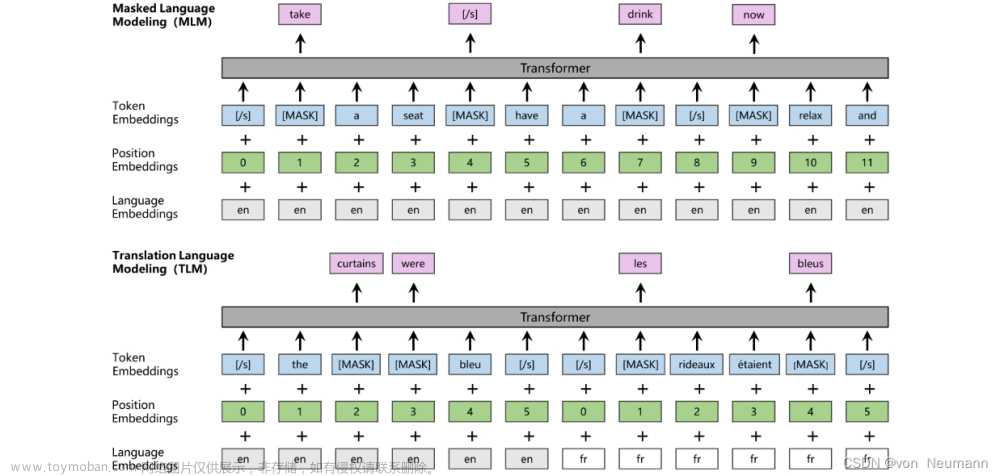

· BERT(Bidirectional Encoder Representations from Transformers):MLM(Masked Language Model)

· BERT(Bidirectional Encoder Representations from Transformers):NSP(Next Sentence Prediction)任务

· BERT(Bidirectional Encoder Representations from Transformers):输入表示

· BERT(Bidirectional Encoder Representations from Transformers):微调训练-[句对分类]

· BERT(Bidirectional Encoder Representations from Transformers):微调训练-[单句分类]

· BERT(Bidirectional Encoder Representations from Transformers):微调训练-[文本问答]

· BERT(Bidirectional Encoder Representations from Transformers):微调训练-[单句标注]

· BERT(Bidirectional Encoder Representations from Transformers):模型总结与注意事项

BERT全称为Bidirectional Encoder Representations from Transformers,即来自Transformers的双向编码器表示,是谷歌发表的论文Pre-training of Deep Bidirectional Transformers for Language Understanding中提出的一个面向自然语言处理任务的无监督预训练语言模型,是近年来自然语言处理领域公认的里程碑模型。其意义在于:从大量无标记数据集中训练得到的深度模型,可以显著提高各项自然语言处理任务的准确率。事实上,BERT刷新了在自然语言推断、问答及命名实体识别任务等11项自然语言处理任务上的表现,甚至在SQuAD问答测试中超过了人类的表现。

BERT被认为是近年来优秀预训练语言模型的集大成者,其参考了ELMo模型的双向编码思想,借鉴了GPT用Transformer作为特征提取器的思路,并采用了word2vec所使用的CBOW训练方法。BERT问世后,更多优秀的预训练语言模型如春笋般不断涌现,在不同的领域和场景中均体现了更好的性能,但是它们的模型结构和底层思想依然没有完全脱离BERT,可见BERT影响之深远。

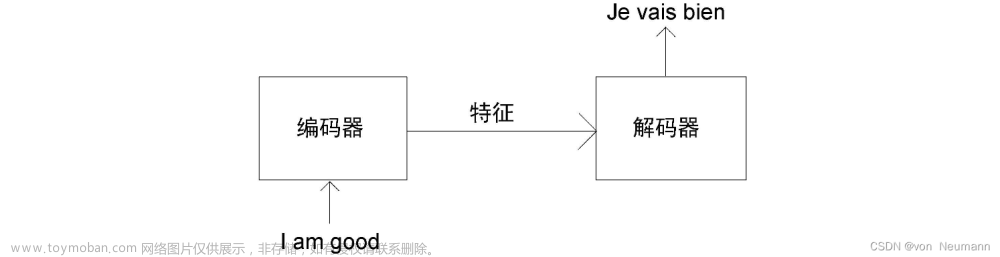

从名字上看,BERT强调的是Bidirectional Encoder,即双向编码器,这使它有别于同一时期使用单向编码引起广泛关注的预训练语言模型——GPT。GPT是标准的语言模型,用Transformer Decoder(包含Masked Multi-Head Attention)作为特征提取器,具有良好的文本生成能力。当然,其缺陷也比较明显,即当前词的语义只由其前序词决定,在语义理解上略有不足。而BERT的创新在于用Transformer Encoder(包含Multi-Head Attention)作为特征提取器,并使用与之配套的掩码训练方法。虽然使用双向编码使得BERT不再具有文本生成能力,但研究结果表明,BERT在对输入文本的编码过程中,利用了每个词的所有上下文信息,与只能使用前序信息提取语义的单向编码器相比,BERT的语义信息提取能力更强。

下面举例说明单向编码与双向编码在语义理解上的差异:

今天天气很差,我们不得不取消户外运动。

将句中的某个字或词挖走,句子就变成:今天天气很( ),我们不得不取消户外运动。分别从单向编码(如GPT)和双向编码(如BERT)的角度来考虑“( )”中应该填什么词。单向编码只会使用“今天天气很”这五个字的信息来推断“( )”内的字或词,以人类的经验与智慧,使用概率最大的词应该是:“好”“不错”“差”“糟糕”,而这些词可以被划分为截然不同的两类。双向编码可以利用下文信息“我们不得不取消户外运动”来帮助模型判断,以人类的经验与智慧,概率最大的词应该是:“差”“糟糕”。通过这个例子我们可以直观地感受到,不考虑模型的复杂度和训练数据量,双向编码与单向编码相比,可以利用更多的上下文信息来辅助当前词的语义判断。在语义理解能力上,采用双向编码的方式是最科学的,而BERT的成功很大程度上由此决定。文章来源:https://www.toymoban.com/news/detail-501452.html

参考文献:

[1] Lecun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015

[2] Aston Zhang, Zack C. Lipton, Mu Li, Alex J. Smola. Dive Into Deep Learning[J]. arXiv preprint arXiv:2106.11342, 2021.

[3] 车万翔, 崔一鸣, 郭江. 自然语言处理:基于预训练模型的方法[M]. 电子工业出版社, 2021.

[4] 邵浩, 刘一烽. 预训练语言模型[M]. 电子工业出版社, 2021.

[5] 何晗. 自然语言处理入门[M]. 人民邮电出版社, 2019

[6] Sudharsan Ravichandiran. BERT基础教程:Transformer大模型实战[M]. 人民邮电出版社, 2023

[7] 吴茂贵, 王红星. 深入浅出Embedding:原理解析与应用实战[M]. 机械工业出版社, 2021.文章来源地址https://www.toymoban.com/news/detail-501452.html

到了这里,关于深入理解深度学习——BERT(Bidirectional Encoder Representations from Transformers):基础知识的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!