西安交通大学开源了人工智能SadTalker模型,通过从音频中学习生成3D运动系数,使用全新的3D面部渲染器来生成头部运动,可以实现图片+音频就能生成高质量的视频。内含多个踩坑的解决办法,值得玩一玩。

1、sadtalker安装

1.1 windows运行环境构建

Install Python 3.10.6

Install git manually

Install ffmpeg

Download our SadTalker repository, git clone https://github.com/Winfredy/SadTalker.git.

Download the checkpoint and gfpgan below,放当前目录checkpoint下;

Run start.bat from Windows Explorer as normal, non-administrator, user, a gradio WebUI demo will be started.

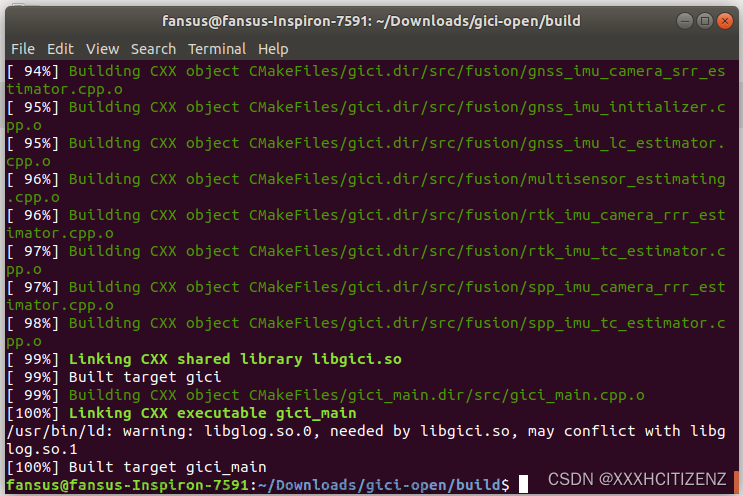

1.2、Linux安装,推荐,我就是用的这个环境

Installing anaconda, python and git.

去下载:https://www.anaconda.com/download#downloads

# 进入当保存文件的目录,执行此指令, 后期由于版本更新,可能会与此文件命名有所不同

bash Anaconda3-2023.03-1-Linux-x86_64.sh -p /home/program/anaconda3

source ~/.bashrc

安装文章来源:https://www.toymoban.com/news/detail-501581.html

git文章来源地址https://www.toymoban.com/news/detail-501581.html

到了这里,关于八、让照片说话之SadTalk的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!