代码:https://github.com/haotian-liu/LLaVA

总览

在这篇论文中,作者首次尝试使用纯语言 GPT-4 生成多模态语言图像指令遵循数据(insruction-following data)。 通过对此类生成数据进行指令调整,推出了大型语言和视觉助手(Large Language and Vision Assistant,LLaVA)。一种端到端训练的大型多模态模型,连接视觉编码器和 LLM 以实现通用视觉和语言理解。

背景等相关方法:大型语言模型(LLM)表明语言可以发挥更广泛的作用:通用助手的通用接口,各种任务指令可以用语言明确表示并指导端到端 训练有素的神经助手切换到感兴趣的任务来解决它。例如,最近 ChatGPT 和 GPT-4 的成功证明了对齐 LLM 在遵循人类指令方面的力量,并激发了人们对开发开源 LLM 的极大兴趣。 其中,LLaMA [44] 是一个与 GPT-3 性能相匹配的开源 LLM。 Alpaca [43]、Vicuna [45]、GPT-4-LLM [34]利用各种机器生成的高质量指令跟随样本来提高 LLM 的对齐能力,与专有 LLM 相比,报告了令人印象深刻的性能。 重要的是,这行工作是纯文本的。

不同于上面文本的指令微调,作者提出了视觉指令微调,第一个尝试将指令微调拓展到多模态领域调整。贡献如下:

- 数据方面:使用ChatGPT/GPT-4来将数据转化为多模态指令遵循数据(multimodel instrustion-following data);

- 模型方面:使用CLIP+LLaMA进行指令微调,构建了多模态大模型LLaVA,得到了较好的结果;

- 开源,开源,还是开源!这年头大模型开源都算主要contribution了。

GPT-协助的数据生成

这部分我写的比较细,因为现在大模型论文在模型上区别并不大,主要还是数据的区别。

基于已有的大量图片对数据,利用ChatGPT/GPT-4进行多模态指令遵循数据的收集。主要问题集中在如何用 Language-only/Text-only的ChatGPT/GPT-4模型来为图片内容生成对应的指令。

最基本的方式:图片Xv和其对应的说明文字Xc,构建一个问题集合Xq来提示大模型助手对图片内容进行描述。通过提示GPT-4可以构建这样一个问题序列,如下图:

然后可以将图文对扩展成指令遵循版本的数据格式:Human: Xq Xv <STOP> \n Assistant: Xc <STOP> \n。

但这样构造的数据都缺乏多样性和深入推理性,为了弥补这一问题,作者将视觉内容编码送进ChatGPT来提高指令的质量,用了两类的符合表示:文字说明(通常从不同的角度描述视觉场景)和编辑框BBox(通常对场景中的物体进行定位,每个边界框对物体的概念及其空间位置进行编码),如下图:

通过这两类符合表示,将视觉内容传达给了大模型,然后手工设计了3种对话方式,利用GPT-4进行生成和扩充,分别是对话、细节描述和复杂推理。

这里的每种类型使用的问题(Question)也是通过GPT进行in-context-learning来模仿生成的。其中,图片/描述/边界框等信息使用COCO数据集的数据。

以对话为例,作者采用了下图的方式生成更多的对话标签。

最终累积158K的语言-图片指令遵循样本,58K对话、23K细节描述和77K复杂推理。同时在使用ChatGPT和GPT-4时,作者发现GPT-4生成的指令遵循数据质量更高,比如空间推理能力。

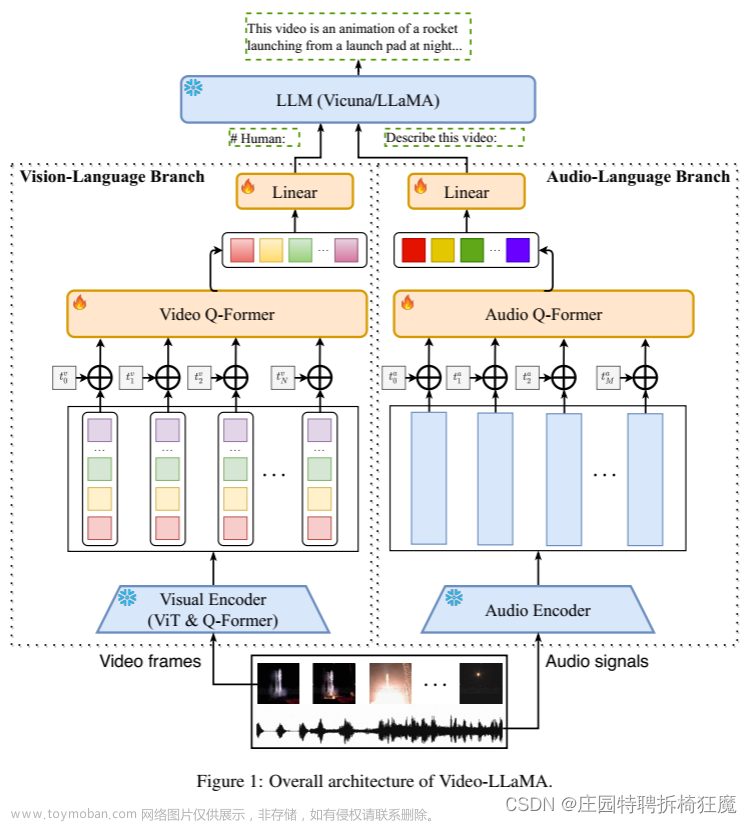

网络结构

与GPT-4-LLM[34], Alpaca[43], Vicuna[45]类似,作者使用LLaMA来做 指令微调任务,网络结构如下。整体比较简单,再语言模型前(LLaMA)添加了一个视觉编码器(CLIP)将图片转化为Patch features,然后这些图片特征经过一个映射层W转化为视觉Token,Vison Token与Language Token指令在同一个特征空间,一起拼接(concantate)一起送进大模型。

这里的映射层W可以替换为更复杂的网络来提升性能。

模型训练

使用如下图的方式组织输入输出,其中绿色部分为参与损失计算的部分,损失使用自回归模型的损失,即next token prediction。

作者使用了两阶段的训练方式:

- 预训练特征对齐模块(映射层W);

- 端对端的微调语言模型+映射层。

实验效果

其他可以学习的文章

miniGPT-4的同期工作: 微软LLaVa模型论文笔记:https://zhuanlan.zhihu.com/p/625723805

Visual Instruction Tuning:https://zhuanlan.zhihu.com/p/624071363

参考文献

[34] Baolin Peng, Chunyuan Li, Pengcheng He, Michel Galley, and Jianfeng Gao. Instruction tuning with GPT-4.

[43] Rohan Taori, Ishaan Gulrajani, Tianyi Zhang, Yann Dubois, Xuechen Li, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto. Stanford alpaca: An instruction-following llama model. https://github.com/tatsu-lab/stanford_alpaca, 2023

[44] Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timo- thée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971, 2023.文章来源:https://www.toymoban.com/news/detail-501987.html

[45] Vicuna. Vicuna: An open-source chatbot impressing gpt-4 with 90%* chatgpt quality. https: //vicuna.lmsys.org/, 2023.文章来源地址https://www.toymoban.com/news/detail-501987.html

到了这里,关于多模态大语言模型 LlaVA 论文解读:Visual Instruction Tuning的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!