Python爬虫入门系列之Selenium实现动态页面爬取

在前一篇博客中,我们学习了如何使用多线程优化爬虫程序。但是,如果要爬取的网页是动态生成的或者包含大量JavaScript代码,单纯的静态页面爬取就不足够了。为了解决这个问题,我们可以使用Selenium库来模拟真实的浏览器行为,从而实现动态页面的爬取。

Selenium简介

Selenium是一个用于自动化测试的工具,也可以用于爬虫开发。它提供了多种浏览器(如Chrome、Firefox、Edge等)的驱动程序,可以通过控制浏览器的方式实现模拟用户操作,包括页面加载、表单填写、点击按钮等。

安装Selenium

首先,我们需要安装Selenium库和相应的浏览器驱动程序。以Chrome浏览器为例,以下是安装步骤:

-

安装Selenium库:

pip install selenium -

下载并解压对应版本的Chrome浏览器驱动程序:ChromeDriver下载地址

-

将解压后的驱动程序放在系统PATH路径下,或者将驱动程序所在目录添加到系统PATH环境变量中。

使用Selenium爬取动态页面

以下是使用Selenium实现动态页面爬取的基本代码示例:

from selenium import webdriver

# 创建浏览器驱动程序

driver = webdriver.Chrome()

# 发起请求

driver.get('https://www.example.com')

# 获取页面内容

content = driver.page_source

# 关闭浏览器

driver.quit()

通过上述代码,我们可以启动Chrome浏览器,并访问指定的URL。然后,我们可以通过driver.page_source获取页面的源代码,包括动态生成的内容。最后,使用driver.quit()关闭浏览器。

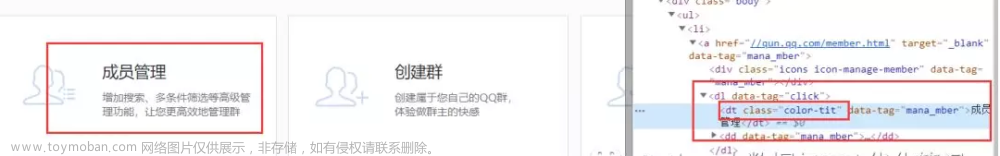

当然,Selenium还提供了丰富的API和功能,例如查找元素、模拟用户操作等。您可以根据具体的需求来使用这些功能,实现更复杂的动态页面爬取。

注意事项

使用Selenium进行动态页面爬取时,有一些注意事项需要留意:

-

选择合适的浏览器驱动程序:根据您使用的浏览器类型和版本,选择对应的驱动程序进行安装和配置。

-

设置合适的等待时间:由于动态页面加载需要时间,您可能需要使用

time.sleep()或者driver.implicitly_wait()等方式设置适当的等待时间,确保页面加载完成后再进行数据提取。 -

避免频繁访问:模拟浏览器行为可能会带来更多的网络请求和资源消耗,需要注意不要给目标网站带来过大的负担,遵守相关的爬虫规范和道德准则。文章来源:https://www.toymoban.com/news/detail-504215.html

希望这篇博客能为您提供关于使用Selenium实现动态页面爬取的基本指导。如果您有任何问题或者需要进一步的帮助,请随时告诉我。文章来源地址https://www.toymoban.com/news/detail-504215.html

到了这里,关于Python爬虫入门系列之Selenium实现动态页面爬取的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!