更多、更及时内容欢迎留意微信公众号: 小窗幽记机器学习

背景

之前下载huggingface上模型的时候,要么是用类似如下脚本的方式下载:

from transformers import AutoTokenizer, AutoModelForMaskedLM

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

model = AutoModelForMaskedLM.from_pretrained("bert-base-uncased")

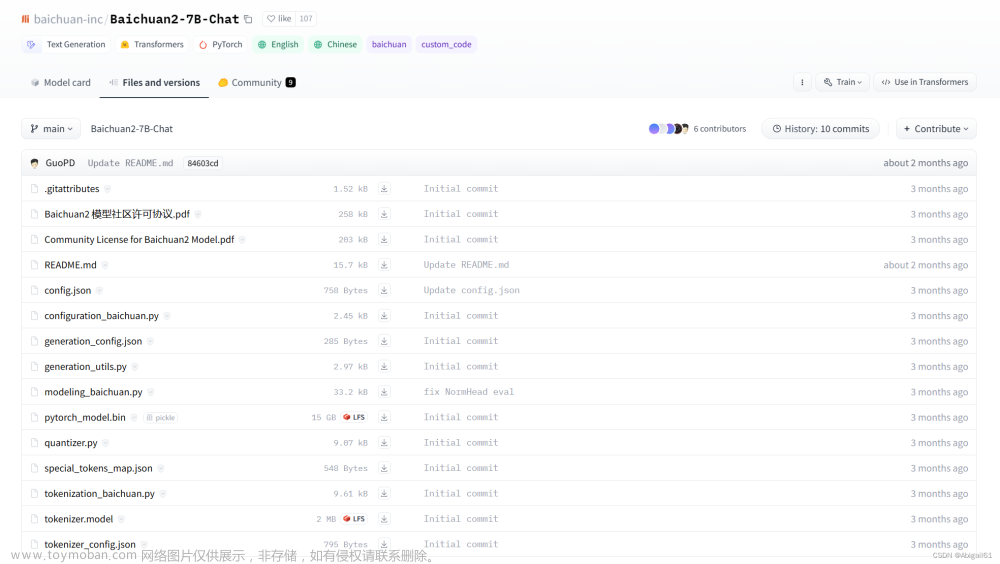

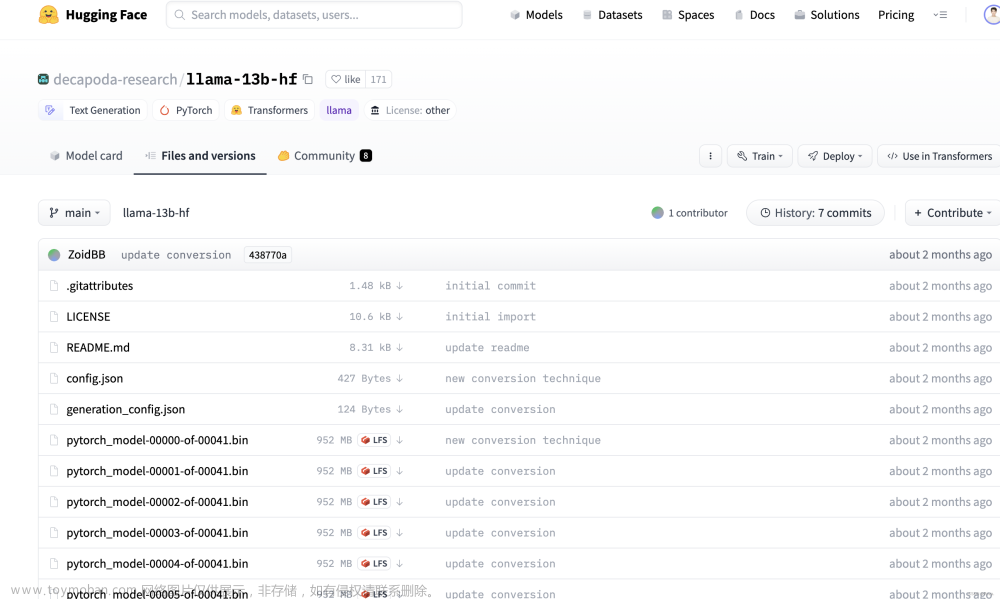

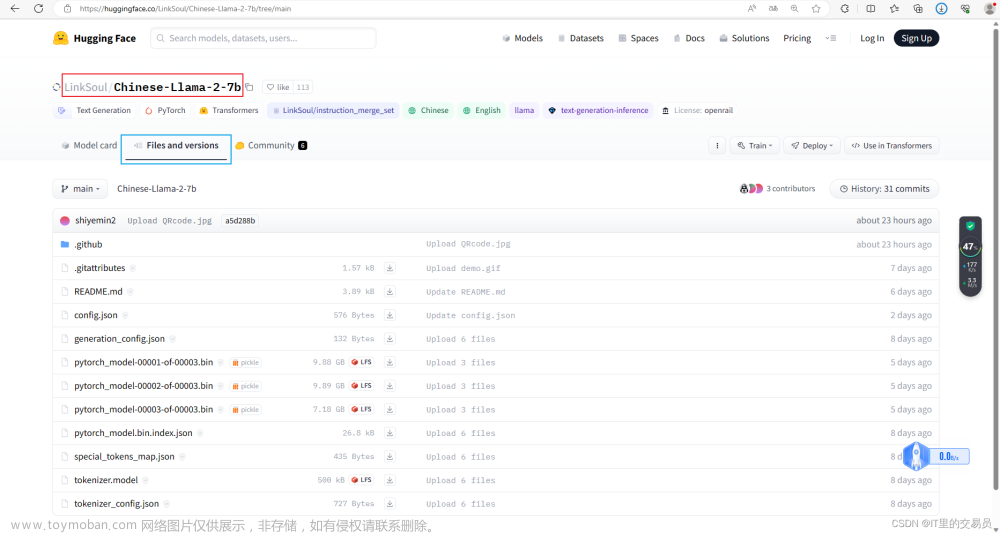

要么是在Files and versions 中点击目标文件逐一下载:

那么是否有更方便的方式,一行命令直接下载整个模型文件?有的,使用git lfs 即可。

环境安装

LFS是Large File Storage的缩写,用于帮助git管理大文件。不同于git每次保存diff,对于git来说,如果是模型或者一些设计大文件,改变一点,对于仓库来说会增加很大的体积,不一会就能几个G。对于git lfs来说,在使用git lfs track命令后,git push的时候,git lfs会截取要管理的大文件,并将其传至git lfs的服务器中,从而减小仓库的体积。

工具安装:

yum install git-lfs

# Make sure you have git-lfs installed

# (https://git-lfs.github.com/)

git lfs install

模型下载

至此,可以使用git clone https://huggingface.co/username/your-model-name下载目标模型。比如想要下载bert-base-uncased模型:

git clone https://huggingface.co/bert-base-uncased

下载结果可以和网页结果比对:

并进行hash校验,可以看出结果相同,即表明正常下载了模型文件。文章来源:https://www.toymoban.com/news/detail-504938.html

文章来源地址https://www.toymoban.com/news/detail-504938.html

文章来源地址https://www.toymoban.com/news/detail-504938.html

到了这里,关于下载huggingface上模型的正确姿势的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[NLP]Huggingface模型/数据文件下载方法](https://imgs.yssmx.com/Uploads/2024/02/603970-1.png)