我在搭建PySpark执行环境入口时出现RuntimeError: Java gateway process exited before sending its port number,在CSDN上搜索后确定是未安装Java程序,下载安装并配置Java环境即可解决问题,大家可以先在控制面板上查看是否安装Java,如可在Java Downloads | Oracle官网上下载,选择Java17 LTS版本,安装配置好Java后重启程序,问题可解决。

报错页面如下

搭建PySpark执行环境入口对象代码如下:

# 导包

from pyspark import SparkConf, SparkContext

# 创建SparkConf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

# 基于SparkConf类对象创建SparkContext对象

sc = SparkContext(conf=conf)

# 查看PySpark的运行版本

print(sc.version)

# 停止SparkContext对象的运行(停止PySpark程序)

sc.stop()安装的Java版本为Java17, 网址:Java Downloads | Oracle

安装配置好Java后重启Pycharm软件并执行程序,问题可解决。

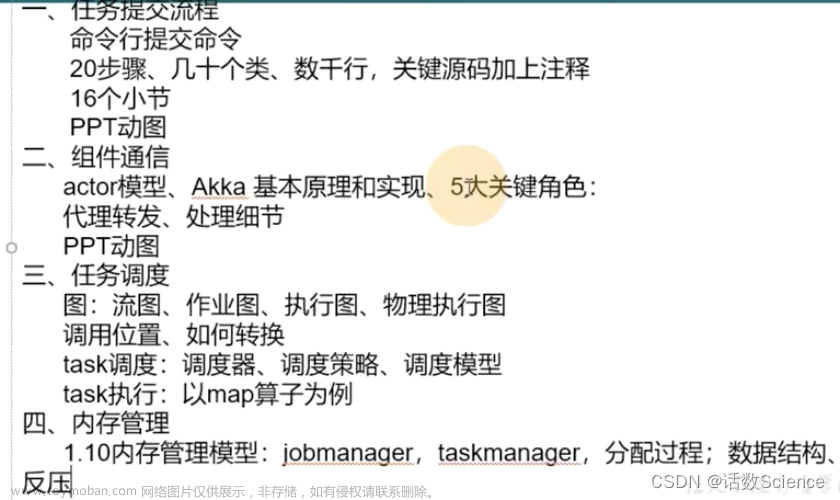

其它问题可查看下面几篇文章

(3条消息) pyspark Exception: Java gateway process exited before sending its port number(2021年10月29日版)_明天,今天,此时的博客-CSDN博客

(3条消息) 测试pyspark时,解决Java gateway process exited的问题_コキリ的博客-CSDN博客文章来源:https://www.toymoban.com/news/detail-505167.html

python - Pyspark: Exception: Java gateway process exited before sending the driver its port number - Stack Overflow文章来源地址https://www.toymoban.com/news/detail-505167.html

到了这里,关于Python搭建PySpark执行环境入口时出现RuntimeError: Java gateway process exited before sending its port number解决办法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!