利用 controlnet 的 SoftEdge 算法和 Open Pose,再加 ebsynth 插件将一段真人的跳舞视频动漫化,具体步骤:

- 1、使用 ebsynth 设置好输出目录(不能有中文,否则会报错,已经试过了),选择原视频,运行抽取序列帧并生成蒙版图,蒙版图生成之后要看一下是不是你想要的东西,如果不是可以调整一下参数重新生成

- 2、设置关键帧间隔,生成关键帧(推荐设置 5,数值越小后面生成视频越连贯,反之卡顿,但同时接下来计算量也变大)

- 3、利用 isnet_pro 插件将上一步所有的关键帧去除背景,得到只有白底 + 人物的关键帧

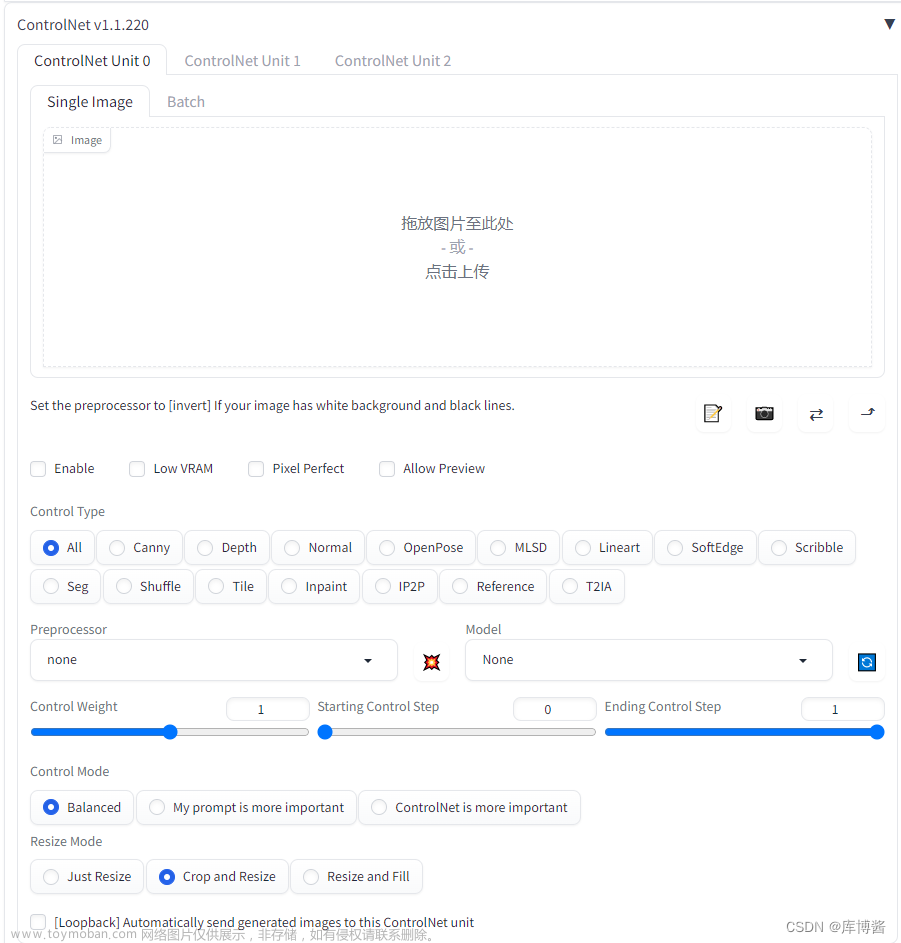

- 4、从上一步抽取出来的关键帧导入一张放到“WD 1.4标签器”反推 prompt,删除明显不符合的prompt,然后发送到图生图,再从上一步抽取出来的关键帧导入一张到图生图,选择好大模型和lora,然后设置controlnet,这里需要两个controlnet,一个使用softedge(也可以是canny,hed或者其他算法,测试一下看哪个效果好),一个使用openpose,保持分辨率和关键帧一致,设置好批次一次多出几张,点击生成,观察出来的图有哪些变化的地方通过添加prompt固定住,反复调整参数直到出来一张满意的,固定种子值,接着在脚本里面选择 ebsynth,设置好目录点运行,这样就把所有关键帧按照此风格生成出来了(生成出来的图可能会有一些杂质,原因是AI绘画本来就有很多不确定性,应该可以考虑添加更加详细的prompt来改善或自己训练人物 lora 解决),如果看到某一张特别不符合的可以使用PS修改,或者使用图生图重新生成,利用 Segment Anything 制作蒙版,PS修改等等都可以

- 5、改变上一步图生图出来的图片的颜色或风格(这一个可选,可跳过,默认和原视频一致)

- 6、调整生成出来的图片大小(这一步也是可选,可跳过,有需要的话可以使用SD的“后期处理->批量处理”功能),影响最终合成的视频的分辨率和大小(如果第1步抽取序列帧时没有设置大小就默认和原视频一致)

- 7、使用 ebsynth 将关键帧打包处理成 ebsynth 软件可以处理的形式

- 8、使用 ebsynth 软件根据上一步生成的文件,通过计算生成所有动画帧并合成视频

- 9、最后还可以上传一张图片修改背景(这个修改背景应该是根据第一步的蒙版图来的)

文章来源地址https://www.toymoban.com/news/detail-506279.html

文章来源:https://www.toymoban.com/news/detail-506279.html

到了这里,关于使用 stable diffusion 将视频动漫化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![这二维码也太美了吧!利用AI绘画[Stable Diffusion的 ControlNet]生成爆火的艺术风格二维码](https://imgs.yssmx.com/Uploads/2024/02/695127-1.png)