IK分词器

什么是IK分词器?

分词:把一段中文或者别的划分成一个一个的关键字,我们在搜索的时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如"我爱魏一鹤"会被分成"我",“爱”,“魏”,“一”,“鹤”,这显然是不符合要求的,索引我们需要安装中文分词器IK来解决这个问题

如果要使用中文,建议使用ik分词器

IK提供了两个分词算法,ik_smart和ik_max_world,其中ik_smart为最少切分,ik_max_wold为最细颗粒度划分,一会都会分别来测试

下载IK分词器

注意 ik版本要和es,kibana版本保持统一(7.6.1)

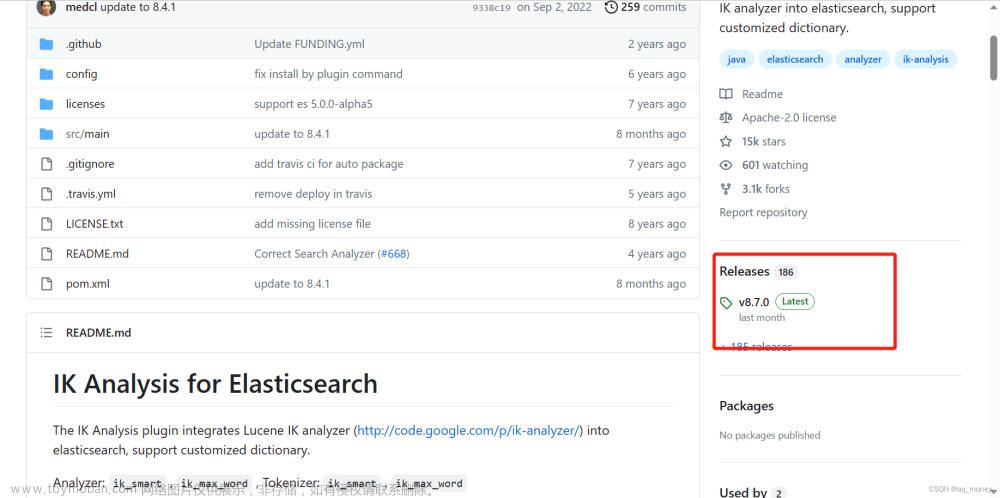

下载网址:https://github.com/medcl/elasticsearch-analysis-ik

找到7.6.1版本

下载到本地,放入es插件中即可,这里我在es的plugins目录下创建一个IK目录

解压缩,目录如下

然后重启观察ES

注意:没有使用ik分词器插件的时候黑窗口会提示no plugins loaded(没有插件加载)

现在使用了ik分词器黑窗口也会提示ik分词器插件已经被加载

我们也可以使用命令(elasticsearch-plugin list)查看es下的全部加载的插件

elasticsearch-plugin list文章来源:https://www.toymoban.com/news/detail-507026.html

文章来源地址https://www.toymoban.com/news/detail-507026.html

文章来源地址https://www.toymoban.com/news/detail-507026.html

到了这里,关于ElasticSearch-IK分词器介绍和下载的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!