一、说明

“万物都有一种模式,它是我们宇宙的一部分。它具有对称、优雅和优雅——这些品质你总能在真正的艺术家捕捉到的作品中找到。” ~ 沙丘 (1965)

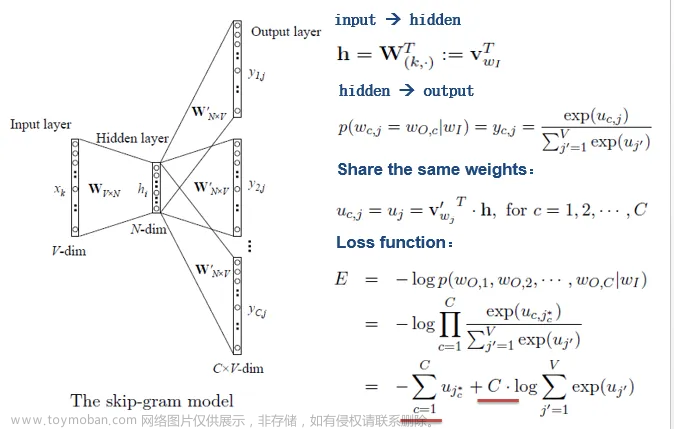

对于word2vec,它不是一个或一种算法,而是一系列思想和算法的综合。本文通过有限篇幅,试图穿越思想跨度和时间跨度,展现word2vec的经历和成长过程,不论这个过程有益的或无利益的尝试都不可忽略,可作为方法论,一起归于思想建设之宝库。

我发现嵌入的概念是机器学习中最迷人的想法之一。如果您曾经使用过 Siri、Google Assistant、Alexa、Google Translate,甚至具有下一个单词预测功能的智能手机键盘,那么您很可能会从这个已成为自然语言处理模型核心的想法中受益。过去几十年来,在神经模型中使用嵌入已经取得了相当大的发展(最近的发展包括上下文化词嵌入,从而催生了 BERT 和 GPT2 等尖端模型)。

Word2vec 是一种有效创建词嵌入的方法,自 2013 年以来一直存在。但除了作为词嵌入方法的实用性之外,它的一些概念已被证明在创建推荐引擎和理解顺序数据方面非常有效在商业、非语言任务中。 Airbnb、阿里巴巴、Spotify 和 Anghami 等公司都从 NLP 领域打造出这一出色的机器并在生产中使用它来支持新一代推荐引擎而受益。文章来源:https://www.toymoban.com/news/detail-508475.html

二、属性度量和属性向量

在这篇文章中,我们将回顾嵌入的概念,以及使用 word2vec 生成嵌入的机制。但让我们从一个例子开始,熟悉使用向量来表示事物。您是否知道五个数字(一个向量)的列表可以代表您的个性?文章来源地址https://www.toymoban.com/news/detail-508475.html

到了这里,关于【NLP】Word2vec概念和演进史的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!