OpenAI发布的ChatGPT Plugin刚刚杀死了一个创业公司LangChain(刚获得1000万美金种子轮融资)

大模型存在的问题

由于语言模型的输出是通过自回归+采样[可选]完成的,在高精度场景下,即使是超大语言模型,发生错误概率也是指数级的。同时,采样也很容易引入错误。比如地址中的数字门牌号,模型在面对0-9这样token的概率会比较接近。

大模型在推理阶段,参数是固定的,无法获取最新的数据与信息,如果问题需要实时数据的场景,没有额外输入的情况下,会无法生成有效的输出。

解决方案:通过拆解任务(Chain of Thought)实现多轮回话的方式,与真实世界的数据API与运行环境(代码解释器)进行数据交互,输出真实的结果。

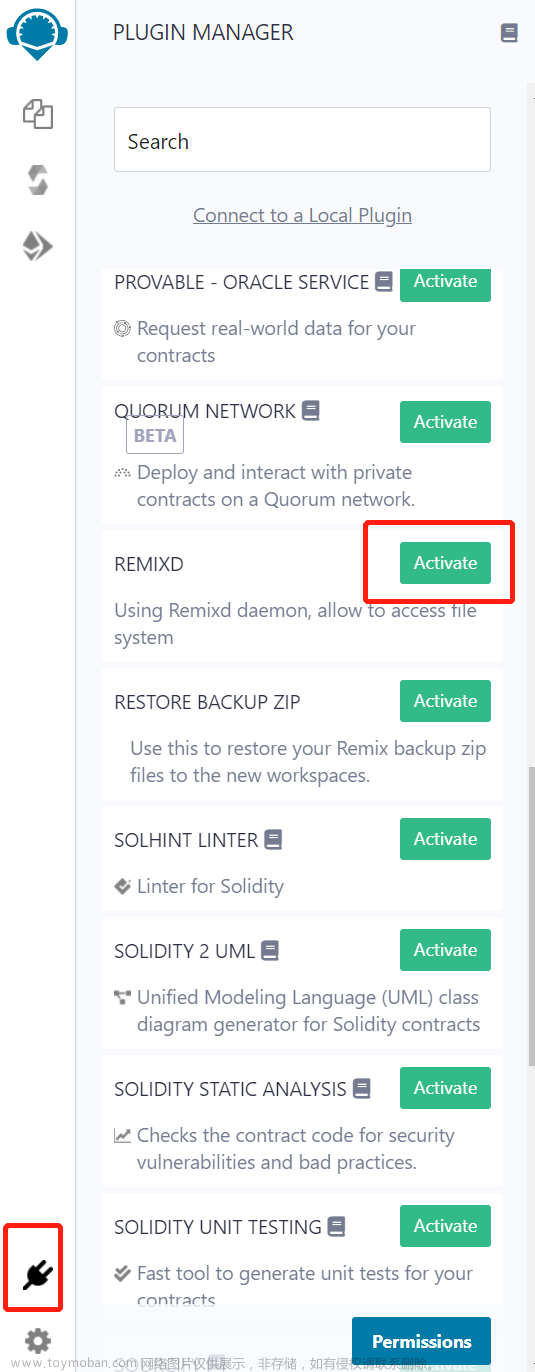

开发框架:1) OpenAI 的 ChatGPT Plugin, 2) langchain(初期,并不完善)

Quick Start

语言模型:开源的ChatGLM-6B,链接:git@github.com:THUDM/ChatGLM-6B.git。

语言模型直接采用清华的开源版本,通过huggingface 的transformer 库调用,开箱即用(需要显卡)。文章来源:https://www.toymoban.com/news/detail-508913.html

插件/Chain 开发框架:langchain,链接:文章来源地址https://www.toymoban.com/news/detail-508913.html

到了这里,关于本地化GPT:LangChain + ChatGLM == 知识本地库的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!