解决方法:

1.首先停止集群

stop-dfs.sh

stop-yarn.sh

2.切换到各节点hadoop解压包目录下的tmp目录,删除目录下所有文件

rm -rf *

3.格式化文件

在主节点hadoop01主节点上进行格式化操作,命令如下:

hdfs namenode -format

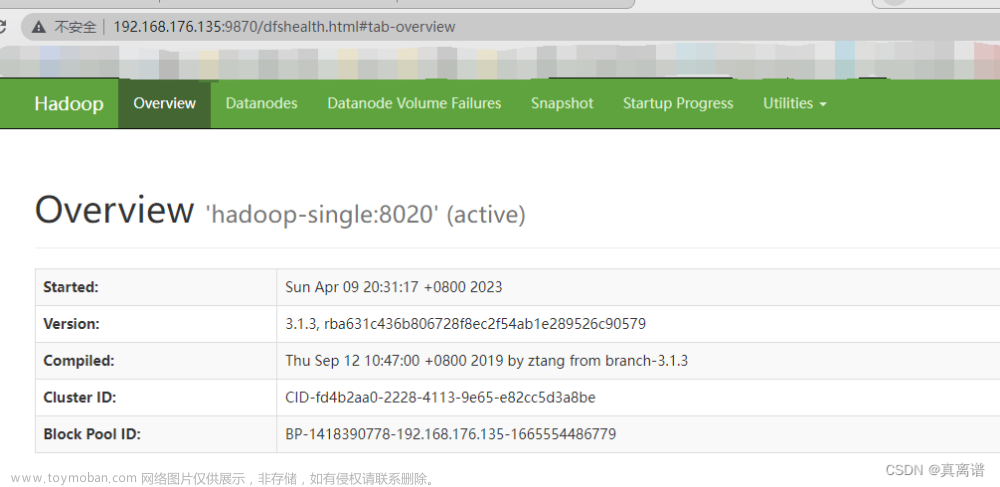

4.测试集群datanode是否启动文章来源:https://www.toymoban.com/news/detail-509326.html

文章来源地址https://www.toymoban.com/news/detail-509326.html

到了这里,关于HADOOP 启动后没有datanode解决办法(适用于所有节点datanode)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!