如果在运行Hive时使用Spark引擎,但是却报了以下错误:

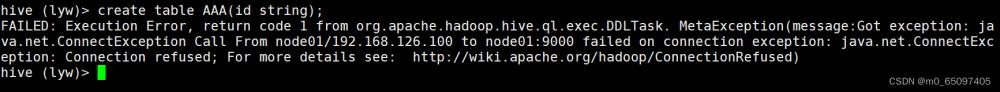

Failed to execute spark task, with exception 'org.apache.hadoop.hive.ql.metadata.HiveException(Failed to create Spark client for Spark session xxx)'

FAILED: Execution Error, return code 30041 from org.apache.hadoop.hive.ql.exec.spark.SparkTask. Failed to create Spark client for Spark session xxx

翻译:未能执行spark任务,无法为Spark会话创建Spark客户端

大概率是因为:没有配置SPARK_DIST_CLASSPATH

具体操作如下:

打开 spark目录 vim conf/spark-env.sh

并输入如下内容:

export SPARK_DIST_CLASSPATH=$(hadoop classpath)

注意hadoop环境变量要提前配置好;

这行语句解释为:Spark就可以把数据存储到Hadoop分布式文件系统HDFS中,也可以从HDFS中读取数据。如果没有配置上面信息,Spark就只能读写本地数据,无法读写HDFS数据,从而引起报错。文章来源:https://www.toymoban.com/news/detail-510105.html

如果对您有帮助,不妨点个赞,收藏一下哦!文章来源地址https://www.toymoban.com/news/detail-510105.html

到了这里,关于HiveOnSpark报错Failed toexecutespark taskwithexceptionorg.apache.hadoop.hive.ql.metadata.HiveException的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!