https://www.bilibili.com/video/BV1Z84y1T7Zh/?spm_id_from=333.788&vd_source=3fd64243313f29b58861eb492f248b34

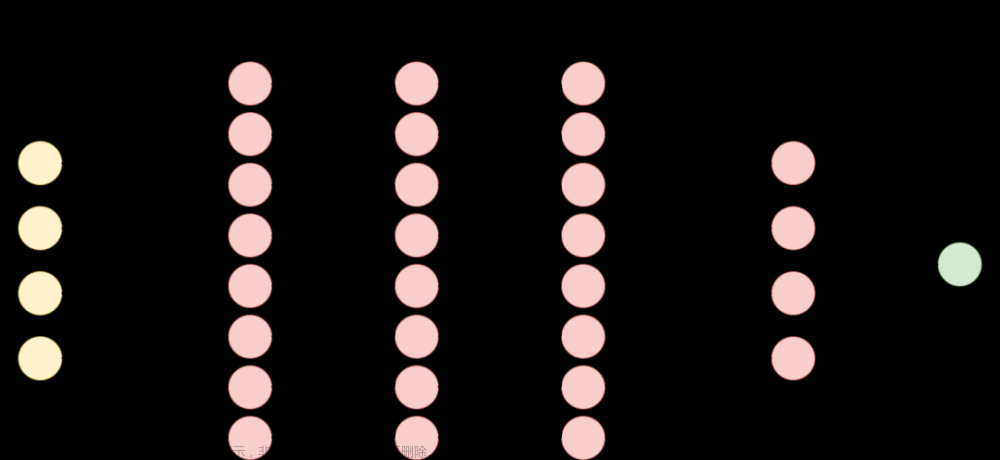

主要方法

- torchvision 微调

- timm 微调

- 半精度训练

背景(问题来源)

文章来源:https://www.toymoban.com/news/detail-510266.html

文章来源:https://www.toymoban.com/news/detail-510266.html

解决方案

大模型无法避免过拟合,文章来源地址https://www.toymoban.com/news/detail-510266.html

到了这里,关于Pytorch--模型微调finetune--迁移学习 (待继续学习)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[迁移学习]预训练和微调](https://imgs.yssmx.com/Uploads/2024/02/482763-1.png)