1. chatgpt 效果评估:Evaluating ChatGPT’s Information Extraction Capabilities: An Assessment of Performance, Explainability, Calibration, and Faithfulness

文章简介

论文是从开放域和限定域两个角度对chatGPT的**performance、可解释性、校准性(calibration)和可信性(faithfulness)**进行了评估(assessment)。(performance、explainability、calibration、faithfulness四个维度进行测评的)

以上评估是杂7个细粒度知识抽取任务中进行的。

四个维度:

- performance(表现):chatgpt在不同任务下的性能表现。

- explainability(可解释性):chatgpt在self-check和human-check下的可解释性。

ChatGPT和领域专家高度认可ChatGPT给出的理由,大多数数据集在Standard-IE和OpenIE设置中获得了超过90%的合理分数

与人的评价相比,ChatGPT在为其预测提供的理由方面显示出很高的信心。ChatGPT displays a high level of confidence in the reasons provided for its predictions when compared with human evaluation

当ChatGPT为一个预测提供了合理的解释时,ChatGPT和人类的评价之间有很高的一致性。

- calibration(校准性):校准性是用来判断chatgpt性能的不确定性的评价手段。一个好的calibratedclassifier是应该能够预测模型给出的判断的准确性(A properly calibrated classifier should have predictive scores that accurately reflect the probability of correctness)

虽然ChatGPT在标准-IE设置中的表现比基于BERT的同类产品差,但它在正确和错误的预测中都表现出过度自信。

ChatGPT倾向于产生不容易代表真实概率的置信度。ChatGPT tends to produce confidences that do not represent true probabilities easily.

- faithfulness(可信性):ChatGPT的解释的忠实性对于确保其可信度非常重要 (The faithfulness of ChatGPT’s explanation is important to ensure its trustworthine)。

ChatGPT’s decision-making process primarily relies on the input of the original text. ChatGPT的决策过程主要依赖于原文的输入.

7个知识抽取任务

实体类型判断 命名实体识别 关系分类 关系抽取 事件检测 事件论元抽取 事件抽取

文章结论

- 在standard IE情况下,ChatGPT的性能在大多数情况下无法与基线模型和SOTA方法相比。

- ChatGPT在相对简单的IE任务中(实体类型判断)表现良好,但在更复杂和具有挑战性的任务中(关系抽取、事件抽取)却很吃力。

- chatgpt在standard IE知识抽取任务中,表现略差于在openIE任务中的表现。

- chatgpt可以用来辅助标注工作。(我们的研究结果表明,ChatGPT是一个合格的答案候选生成器,适用于标准-IE设置下的特定任务。Our findings suggest that ChatGPT is a competent answer candidate generator for a given task under the Standard-IE setting.)

2. 事件抽取: OneEE: A One-Stage Framework for Fast Overlapping and Nested Event Extraction

论文核心

论文将event extraction转化为了word-word relation recognition任务。(参考了relation extraction任务的方法)

论文面向任务是EE: EE任务的核心是需要抽取出trigger和event的arguments。

在解决EE任务时,将可能的关系定义为了以下几类:

S-T 表示head和tail boundary words of a trigger.

S-A 表示head和tail boundary words of a argument

R-S, R-O, R-T, and R-P 表示 trigger Word和argument Word之间的关系。(S表示subject、O表示object、T表示target、P表示proportion)——也就是事件论元和事件trigger之间的关系。

论文方法

方法上还是以tagging scheme 为主,是以table filling方式实现的event extraction。

注意公式中的字的写法

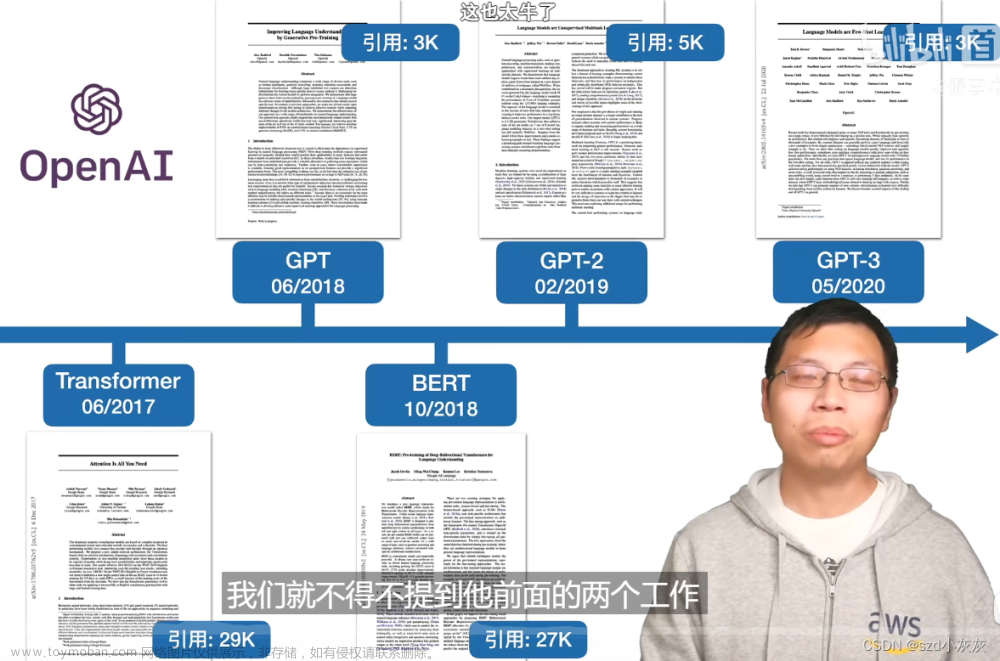

第一步是使用bert 得到sentence 的embedding

第二步使用attention module和 gate module 得到每种event type的contextual representation. (一个由注意模块和两个门融合模块组成的自适应事件融合层被用来为每个事件类型获得偶发的环境表征。)文章来源:https://www.toymoban.com/news/detail-510289.html

- 先使用attention mechanism 得到了每个Word的 event type下的embedding。E表示event type的embedding。

- 融合target event type的embedding和last gate module的output。

第三步,使用table filling实现relation的classification。是将argument和trigger作为的span,然后做了一次span 分类。然后,对argument做了span的分类,判断argument的role。 在计算Word-Word pair之间的关系得分时,使用的是** dot product**.

文章来源地址https://www.toymoban.com/news/detail-510289.html

到了这里,关于论文笔记——chatgpt评估+的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文笔记] chatgpt——PPO算法(Proximal Policy Optimization)](https://imgs.yssmx.com/Uploads/2024/02/428566-1.png)

![[论文笔记] chatgpt系列 1.1 PPO算法(Proximal Policy Optimization)](https://imgs.yssmx.com/Uploads/2024/02/438457-1.png)