简介(来自官方)

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答,更多信息请参考我们的博客。

为了方便下游开发者针对自己的应用场景定制模型,我们同时实现了基于 P-Tuning v2 的高效参数微调方法 (使用指南) ,INT4 量化级别下最低只需 7GB 显存即可启动微调。

不过,由于 ChatGLM-6B 的规模较小,目前已知其具有相当多的局限性,如事实性/数学逻辑错误,可能生成有害/有偏见内容,较弱的上下文能力,自我认知混乱,以及对英文指示生成与中文指示完全矛盾的内容。请大家在使用前了解这些问题,以免产生误解。更大的基于 1300 亿参数 GLM-130B 的 ChatGLM 正在内测开发中。

准备工作

硬件要求(腾讯云V100显卡,一个月大几千,肉疼)

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

代码clone(怎么安装Git工具不赘述)

git clone https://github.com/THUDM/ChatGLM-6B.git环境安装

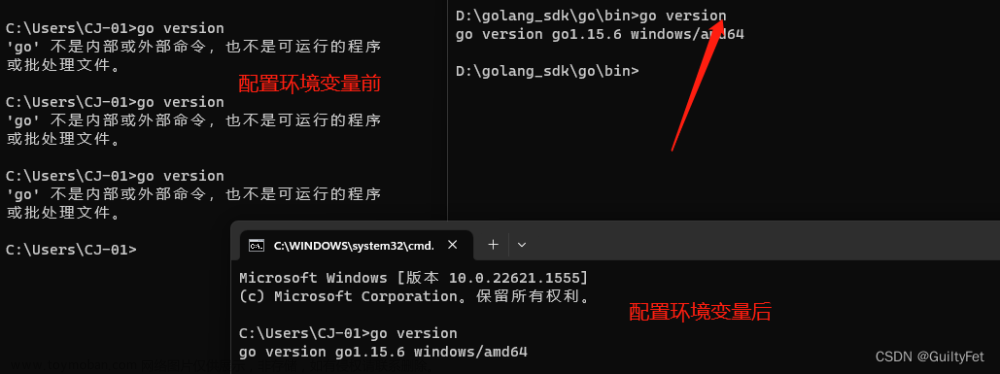

使用 pip 安装依赖:pip install -r requirements.txt,其中 transformers 库版本为 4.27.1(就用这个就行)。

注意:Python要3.8以上!!!!否则能坑死你!

模型以及配置文件准备

1、官方下载:清华大学云盘

2、huggingface开源社区下载:THUDM/chatglm-6b at main

把对应的模型以及配置文件记得下载全,结果是这样的:

踩坑:记得教研一下模型的SHA256是否跟官方一致,否则模型肯定加载失败!

3、准备启动:

三种方式均可:

python3.8 web_demo.py

python3.8 web_demo2.py

streamlit run web_demo2.py

4、注意:web方式记得把云服务器的端口开放了,否则用不了!

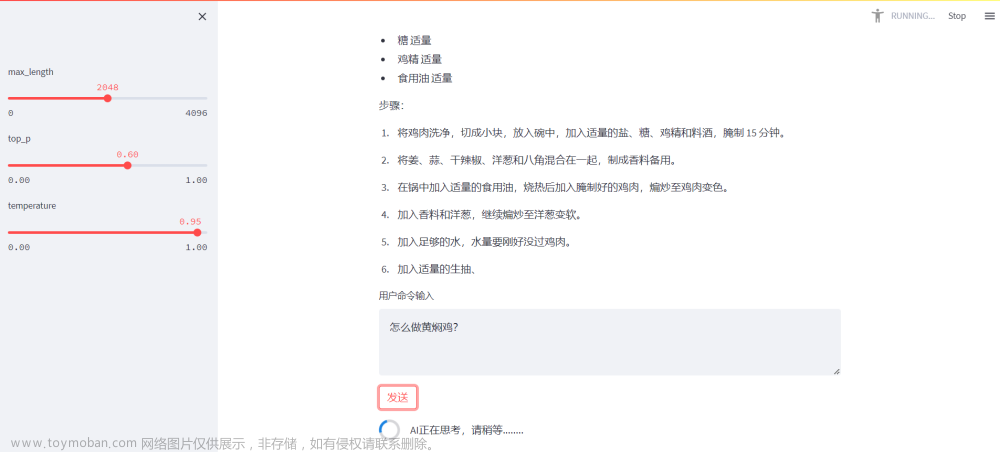

效果展示:

文章来源:https://www.toymoban.com/news/detail-513002.html

文章来源:https://www.toymoban.com/news/detail-513002.html

大家又遇到坑的地方,欢迎留言! 文章来源地址https://www.toymoban.com/news/detail-513002.html

到了这里,关于腾讯云部署清华大学ChatGLM-6B实战的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!