背景:训练DialogueGPT(一个基于GPT2的生成模型)

DialoGPT/data_loader.py at 457835e7d8acd08acf7f6f0e980f36fd327ea37c · microsoft/DialoGPT · GitHub

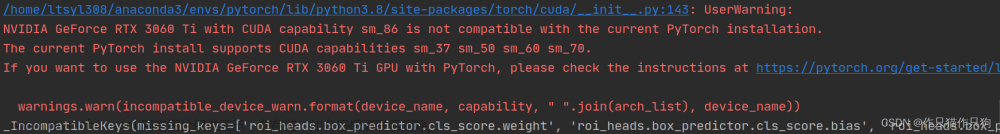

遇到的问题:

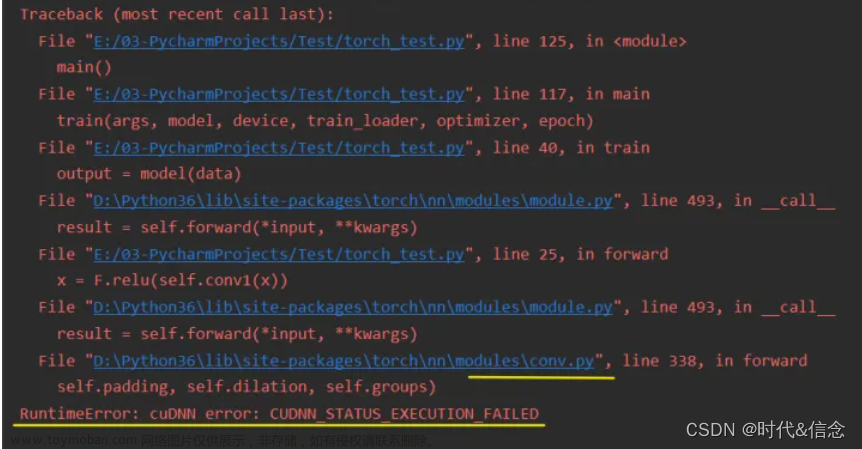

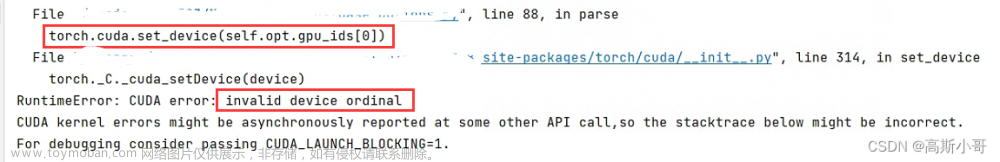

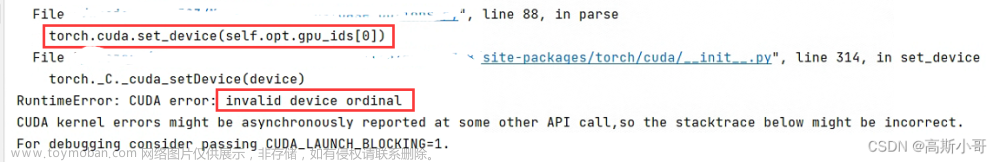

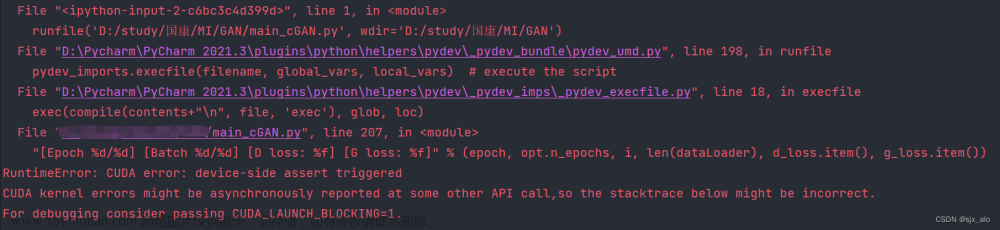

报错:RuntimeError: CUDA error: CUBLAS_STATUS_NOT_INITIALIZED when calling `cublasCreate(handle)`

解决思路:

我把输入用同样形状的随机张量进行了测试,发现用随机的整数张量可以,但是用我的输入就不行,于是想看看两者的区别到底是什么

后来发现,DialogueGPT以及GPT2模型中并没有pad_token,而我手动使用add_special_tokens添加了pad_token,这也就使得词表的长度加1,由原来的0~50256变为0~50257,这也就意味着50257代表的token没有对应的embedding,所以会报错文章来源:https://www.toymoban.com/news/detail-514724.html

解决方案:

查看了原代码,发现微软采取的方式是对于上下文则用0填充,对于label就用-1填充(但不知道为什么我用-1填充也会报同样的错误),于是我就都用0填充,问题得到了解决文章来源地址https://www.toymoban.com/news/detail-514724.html

到了这里,关于RuntimeError: CUDA error: CUBLAS_STATUS_NOT_INITIALIZED when calling `cublasCreate(handle)`的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!