6月30日,由 IT168主办的第十六届中国系统架构师大会(SACC2023)在北京开幕。本届大会以“数字转型 架构演进”为主题,议题涵盖AIGC大数据、多云多活、云成本等多个热门领域。

在会上,酷克数据首席科学家杨胜文发表了题为《当LLM遇到数据仓库》的主旨演讲,分享了对大模型热潮的观察和思考,并介绍了借助酷克数据研发的下一代高级分析和数据科学工具HashML,简化从数据处理、模型微调到知识增强的智能应用构建流程,助力LLM在企业实现规模化落地应用。

杨胜文表示,目前百亿级参数LLM已经具备优秀的语言理解和生成能力。在LLM技术还在快速演进的过程中,相对于千亿级参数模型,百亿级参数模型具有非常明显的成本优势,成为现阶段推动LLM在企业低成本、规模化落地的一个重要选项。

“一方面,通过模型的低成本私有化部署,可以解决很多企业对数据安全担忧的问题。另一方面,企业可以更加方便地利用数据仓库中已有的数据对模型进行微调,并结合HashData对向量数据的存储和高效检索的支持,快速构建知识增强的智能应用。”杨胜文介绍,在具体实施过程中,企业可以通过简单易用、算法丰富、性能卓越的AI开发工具HashML,让数据科学家、数据工程师、应用开发者无门槛地使用LLM。

酷克数据首席科学家杨胜文

LLM热潮下的冷思考

自去年11月底ChatGPT发布以来,国内外很多厂商都加大了对大语言模型的研发投入,各种模型与应用如雨后春笋,层出不穷。据中国科学技术信息研究所统计,截止今年5月,国内已发布10亿参数规模以上的大模型79个,俨然进入一场新的军备竞赛。

对于这波大语言模型引发的AI热潮,学术界尚存诸多不同的看法。有些科学家认为,应该暂停大型AI实验,以免给人类社会带来潜在的风险和危害。有些科学家认为,自回归语言模型并不能让机器实现人类水平的智能,无需过度担心,实现通用人工智能(AGI),需要有别的技术路线。

尽管学术界仍有争议,但这并未影响LLM应用遍地开花。围绕ChatGPT,开发者和企业不仅可以通过API访问OpenAI提供的服务来构建自己的AI应用,也可以在ChatGPT中使用各种插件,从而让ChatGPT变得更加强大。OpenAI也在近期推出了ChatGPT App,支持语音输入,并对更多国家和地区开放了服务。谷歌、微软等跨国公司也相继宣布在全线产品接入大语言模型能力。在国内,不少企业通过与AI服务提供商合作,尝试在产品研发或IT系统中引入大语言模型能力。

杨胜文表示,尽管大模型的应用前景非常广阔,但并非所有企业和创业者都可以在这个领域取得成功,喧嚣过后最终仍将回归到场景价值,回到企业对于成本与收益的考虑上来。站在客户的角度,需要考虑选择合适的场景,以较低的成本进行应用试点,来验证可以获得的收益,而不是一开始就要求客户投入大量的启动资金。

“对个人消费者而言,一般通过聊天服务和基于大语言模型的各种效率工具,基本能够满足大多数需求。”杨胜文表示,“但对于企业客户而言,往往需要将大模型的能力与自研产品或IT系统做集成甚至深度融合,这里面会面临一些问题。”

他指出,目前企业应用千亿级参数大语言模型通常有两种方式,访问公有云服务或私有化部署,这两种模式各有其优缺点。公有云服务的优点在于可以快速接入,可灵活选择服务提供商,但面临着监管合规、数据泄漏风险、专属模型成本高昂等问题;私有化部署可以解决企业对数据安全担忧的问题,企业也可以利用自有数据更加方便地对基础模型进行微调定制,但同样也面临使用成本高的问题,千亿级参数大模型对计算资源和技术人员水平都会有较高的要求。

杨胜文表示,在LLM技术还在快速演进的今天,应该充分发挥当前大语言模型的优势能力,也就是卓越的语言理解和生成能力。百亿级参数模型不论是推理还是微调,都有明显的成本优势,是推动LLM在企业低成本、规模化落地的一个重要选项。同时,日益繁荣的开源生态也为百亿级参数模型在企业应用落地创造了条件。当前已经出现了一些由研究机构和初创公司发布的开源模型,效果表现良好且遵循对商业使用非常友好的开源协议。

HashML大幅降低LLM应用门槛

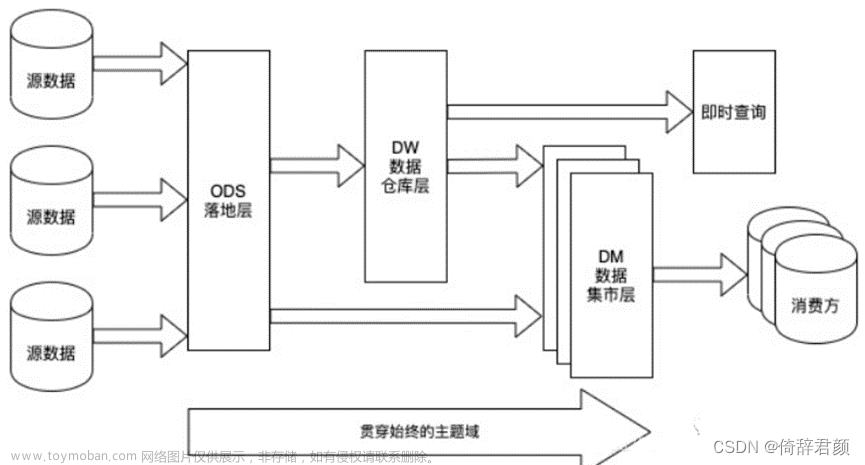

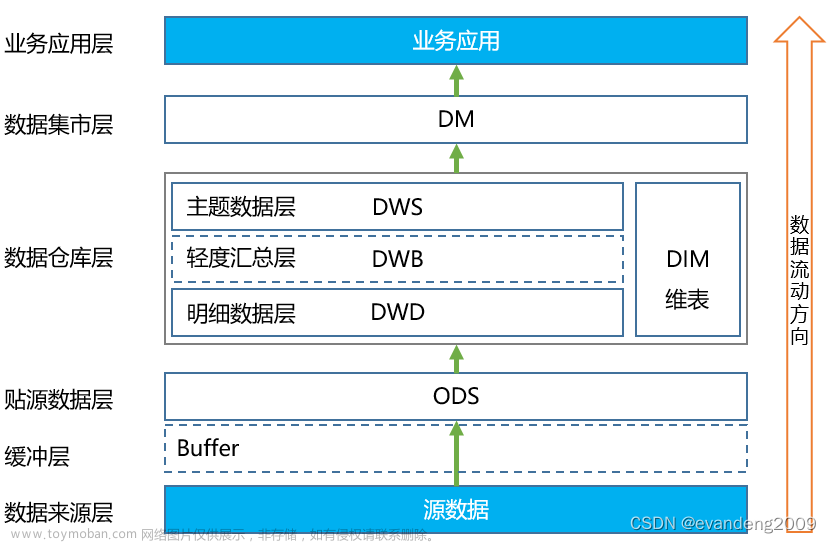

数据作为企业非常重要的资产,如何通过数据分析、挖掘、建模,释放数据价值,是当前企业数字化建设的一个关键话题。数据仓库是企业实现数据存储、分析、处理和计算的核心场所。

长期以来,数据仓库主要用来满足企业的描述性分析需求,而业务价值更高、同时技术复杂度更高的预测性分析和决策性分析,目前仍未获得广泛应用。过去,行业内曾经尝试在数据仓库中实现诸如机器学习这样一些高级分析能力,但传统的In-Database机器学习解决方案支持的算法种类有限,且偏传统的算法居多,对深度学习的支持非常弱,运行效率也整体欠佳。

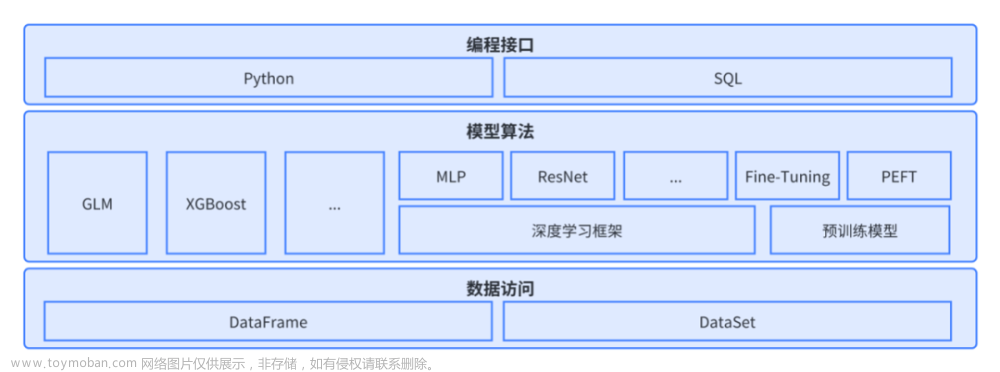

相比传统架构的数据仓库,HashData采用存算分离的架构,不仅能够通过SQL计算引擎对传统的数仓业务提供很好的支持,还能够借助ML/DL计算引擎实现对机器学习和深度学习的高效支持,其中包括对大语言模型微调和推理的支持。HashML就是酷克数据利用HashData强大的计算引擎打造的下一代In-Database高级分析和数据科学工具。

图1 HashML主要功能概览

HashML通过以下特性为企业提供了简单易用、效果优异的AI开发体验:

1、HashML提供了广泛的算法支持,特别是通过对深度学习框架的支持,能够支持各种深度神经网络算法,也对大语言模型的微调、推理以及基于大语言模型的智能应用搭建提供了良好的支持;

2、新算法的开发和引入变得非常容易,客户仅需关注神经网络结构的定义和实现,就能开发一种全新的深度神经网络算法;

3、HashML支持分布式并行训练和推理,能够根据数据规模和模型复杂度灵活调整并行度,大幅提高了模型训练和推理的效率;

4、HashML支持GPU加速,通过多机多卡分布式计算能够进一步提升运算效率;

5、HashML提供标准、统一、简洁的API接口,大幅降低了应用门槛;

6、HashML支持Python和SQL两种编程语言接口,开发者可以根据个人偏好自主选择;

7、HashML通过Python接口能够与繁荣的数据科学生态相融合,为数据科学家和机器学习工程师提供便捷的开发工具。

HashML作为HashData云数仓的一个扩展实现,与数仓共享统一的存储和计算资源,随数仓的部署提供开箱即用的AI能力,大幅降低了系统部署的成本和复杂度,为开发者提供了统一的数据查询、分析、建模环境。

“HashML首要设计目标就是简单易用,希望客户能够无门槛使用各种经典和最前沿的AI算法和模型能力来解决实际业务问题。”杨胜文表示,LLM与HashData为代表的业界领先的企业数据仓库相结合,使得从数据处理、模型微调到知识增强的智能应用构建的全流程变得更简单,推动LLM走向规模化应用。

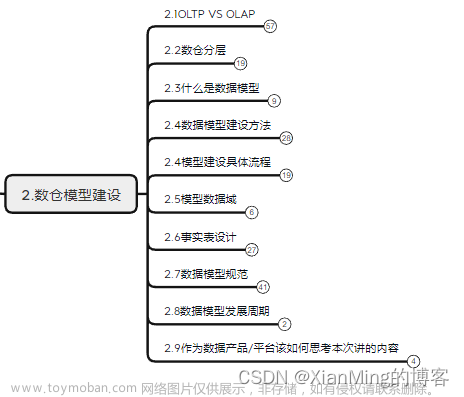

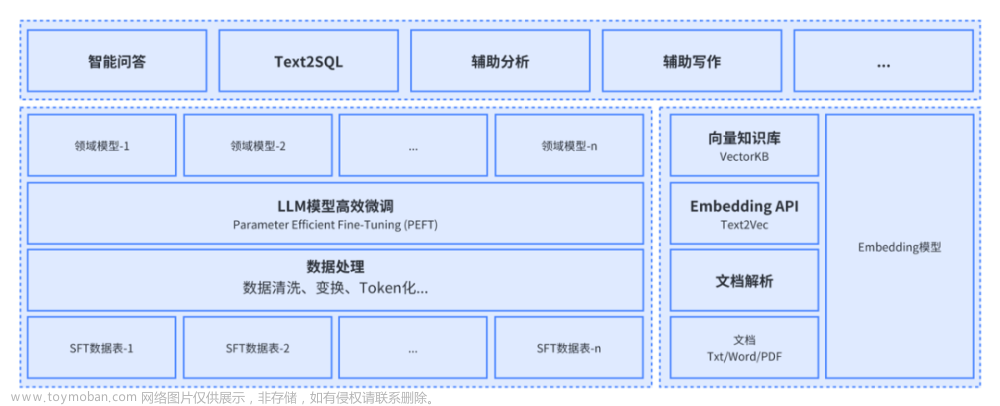

图2 基于HashData的LLM低成本落地方案

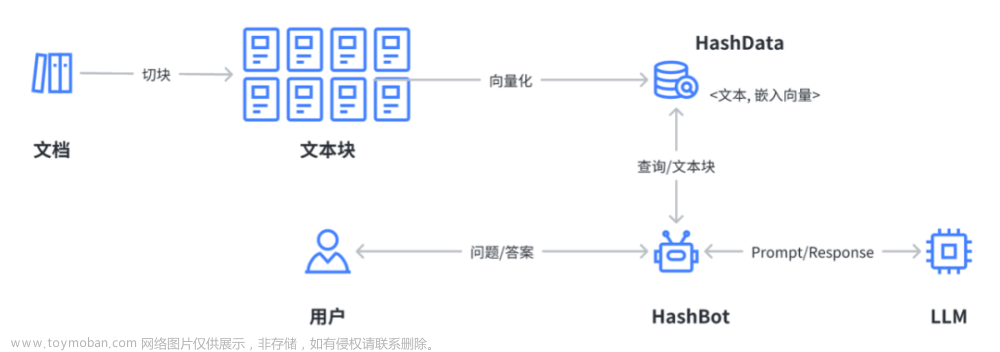

在会上,杨胜文介绍了HashData与LLM相结合的两个应用案例:知识增强的智能问答(见图3)和Text2SQL(从自然语言生成SQL,见图4)。在知识增强的智能问答应用案例中,用户可以通过收集整理文档,并对文档进行解析、分块、编码,构造向量知识库。当用户输入一个问题时,对话机器人首先基于问题去知识库查询相关信息,然后构造合适的Prompt去请求大语言模型并获得生成的结果。当知识库存在与问题高度相关的信息时,语言模型就可以基于对这些信息的理解和摘要,生成高质量的回答。

图3 基于向量知识库的智能问答

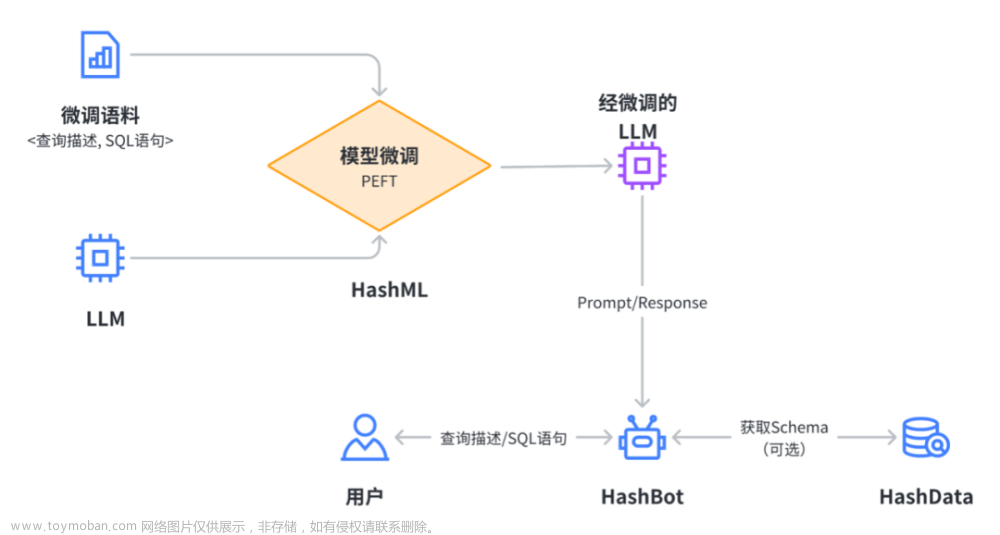

在Text2SQL应用案例中,由于基础模型在自然语言转SQL方面的能力相对较弱,需要对基础模型进行微调。为此,团队准备了大概十几万条训练语料,利用HashML封装的LoRA方法进行了微调,在一张V100的卡上进行训练。为了实现更好的效果,在和机器人交互的时候,除了提供用户输入的查询请求,还需要提供实现该查询所需的数据表的Schema信息。Schema信息可以由用户提供,也可以在实际生产场景中,由机器人连接数据库自动获取。

图4 Text2SQL:从自然语言生成SQL文章来源:https://www.toymoban.com/news/detail-515440.html

展望未来,杨胜文认为,未来大语言模型发展方向必定是多元化、普惠化,每个企业都可以利用大语言模型来提升智能化水平,实现降本增效。数据与大语言模型的紧密结合,将会为企业和社会创造巨大的价值。以HashData为代表的企业数据仓库,为这种结合提供了一个天然的平台。企业可以在自有数据上通过模型微调和应用创新,释放大语言模型的应用潜力,进而充分释放数据价值,实现新的增长点。基于数据仓库和大语言模型构建面向场景的智能应用,将成为企业智能应用开发的新范式。文章来源地址https://www.toymoban.com/news/detail-515440.html

到了这里,关于当大模型遇到数据仓库 HashData助力LLM规模化应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!