前言

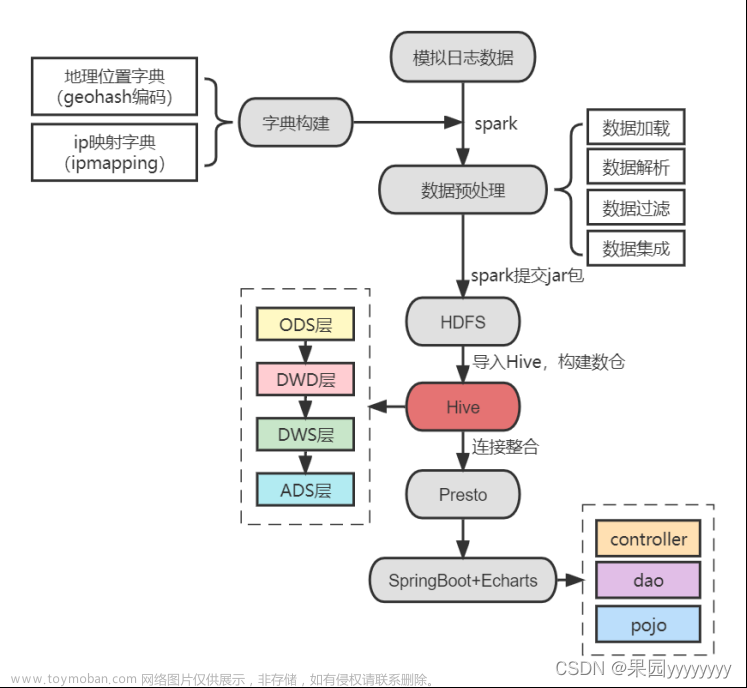

在当今的数据驱动时代,构建一个强大的大数据环境对于企业和组织来说至关重要。本文将介绍如何安装和配置Hadoop、MySQL、Hive、Scala和Spark,以搭建一个完整的大数据环境。

简介

- 安装Hadoop 首先,从Apache Hadoop的官方网站下载所需的Hadoop发行版。选择适合你系统的二进制发行版,下载完成后解压缩到安装目录。然后配置环境变量,并修改Hadoop的配置文件,根据需要进行修改。

- 安装MySQL 安装MySQL服务器是搭建大数据环境的重要一步。更新包管理器后,执行命令安装MySQL服务器,并配置MySQL允许通过网络连接。编辑MySQL的配置文件,并重启MySQL服务,最后验证安装是否成功。

- 安装Hive仓库 Hive是一个用于处理和分析大规模数据集的数据仓库工具。下载所需的Hive发行版,解压文件后配置环境变量,并修改Hive的配置文件。如果选择使用外部数据库作为元数据存储,还需要安装和配置数据库。最后验证安装是否成功。

- 安装Scala Scala是一种运行在Java虚拟机上的多范式编程语言,常用于大数据处理。从Scala官方网站下载对应版本的二进制发行版,解压文件后配置环境变量。验证安装是否成功。

- 部署Spark集群 Spark是一个快速、通用的大数据处理引擎,支持实时数据处理和批处理。下载Spark压缩包,解压文件后修改配置文件,并配置Spark的环境变量。最后,通过命令验证Spark的安装和配置是否成功。

安装Hadoop

下载Hadoop发行版,前往Apache Hadoop的官方网站 https://hadoop.apache.org 下载所需的Hadoop发行版。你在网站的下载页面上找到最新版本的Hadoop。选择适合系统的二进制发行版,通常有两种选择:tarball(.tar.gz)和ZIP压缩文件。下载完成后,将文件解压缩到安装目录

配置环境变量:在安装Hadoop之前,需要配置一些环境变量,以便系统能够正确找到Hadoop的执行文件。打开终端并编辑你的shell配置文件(例如.bashrc或.bash_profile),然后添加以下行:

export HADOOP_HOME=/path/to/hadoop

export PATH= P A T H : PATH: PATH:HADOOP_HOME/bin

将/path/to/hadoop替换为实际的Hadoop安装路径。保存文件后,运行以下命令使配置生效:

source ~/.bashrc

配置Hadoop环境:在Hadoop安装目录中,找到etc/hadoop目录。该目录包含Hadoop的配置文件。最重要的文件是core-site.xml、hdfs-site.xml和mapred-site.xml。这些文件定义了Hadoop的各种属性和设置。根据需要进行修改,但在初始阶段,使用默认配置通常是可以的。

core-site.xml:这个文件包含Hadoop的核心设置,如文件系统的默认URI和I/O缓冲区大小等。可以通过编辑这个文件来设置Hadoop的全局属性。

hdfs-site.xml:这个文件包含HDFS的配置设置,如命名节点(NameNode)和数据节点(DataNode)的地址、副本数量等。在这里,可以指定HDFS的相关配置。

mapred-site.xml:这个文件包含MapReduce的配置设置,如作业跟踪器(JobTracker)和任务跟踪器(TaskTracker)的地址等。

配置主机文件:在etc/hadoop目录中,找到名为slaves的文件。这个文件用于列出作为数据节点的主机。在每行上添加数据节点的主机名或IP地址。

验证安装:完成以上步骤后,你可以通过运行以下命令来验证Hadoop的安装是否成功:

hadoop version

如下图所示:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-RzbjvI4W-1687089630963)(https://p3-juejin.byteimg.com/tos-cn-i-k3u1fbpfcp/f0c1651b92954a7796368575e0255bdc~tplv-k3u1fbpfcp-watermark.image?)]

安装MySQL

第一步,更新包管理器:打开终端并执行以下命令,更新系统的包管理器:

sudo apt update

第二步,安装MySQL服务器:执行以下命令安装MySQL服务器:

sudo apt install mysql-server

在安装过程中,系统会提示设置MySQL的root密码。输入一个安全且易于记忆的密码,并记住它。

第三步,启动MySQL服务:安装完成后,MySQL服务器会自动启动。可以通过以下命令检查MySQL服务状态:

sudo systemctl status mysql

如果服务处于运行状态,说明安装成功。

第四步,配置MySQL:默认情况下,MySQL只允许本地连接。如果想通过网络连接到MySQL服务器,需要进行一些配置。

第五步,编辑MySQL配置文件:打开终端,并使用以下命令编辑MySQL的配置文件:

sudo nano /etc/mysql/mysql.conf.d/mysqld.cnf

在文件中找到bind-address一行,注释掉该行(在行前面添加#)或将其设置为MySQL服务器所在机器的IP地址,以允许来自任何主机的连接。

保存并关闭文件。

第六步,重启MySQL服务:在配置更改后,重启MySQL服务使其生效:

sudo systemctl restart mysql

第七步,验证安装:执行以下命令登录到MySQL服务器:

mysql -u root -p

系统会要求输入之前设置的root密码。如果成功登录,说明MySQL安装完成。安装成功的演示图如下所示:

安装Hive仓库

第一步,下载Hive:前往Apache Hive的官方网站(https://hive.apache.org)下载所需的Hive发行版。选择需要的版本,并下载对应的tarball(.tar.gz)文件。hive-x39l209bfv2bih3bqrl7u4d1swaev0a.xn–,tarball(-jx4sq23m1fbf1wwoax75d8nm8lgq0aw10pkmuia086u0q0kxcd.tar.xn--gz)-n18ip45m./)

第二步,解压Hive文件:在Linux终端中,进入想要安装Hive的目录,并使用以下命令解压下载的Hive文件:

tar -xzf hive-x.x.x.tar.gz

第三步,配置环境变量:为了让系统正确找到Hive的执行文件,需要配置一些环境变量。编辑shell配置文件(例如.bashrc或.bash_profile),添加以下行:

export HIVE_HOME=/path/to/hive

export PATH= P A T H : PATH: PATH:HIVE_HOME/bin

将/path/to/hive替换为实际的Hive安装路径。保存文件后,运行以下命令使配置生效:

source ~/.bashrc

第四步,配置Hive:进入Hive安装目录,找到conf目录。在该目录中,有一些配置文件需要修改。

hive-env.sh:编辑这个文件,设置Hive的环境变量。至少需要配置HADOOP_HOME,指定Hadoop的安装路径。例如,可以将其设置为/path/to/hadoop。

hive-site.xml:这个文件是Hive的主要配置文件。可以根据需要修改其中的属性,例如设置Hive的元数据存储位置、数据库连接等。

第五步,配置元数据存储:Hive需要一个元数据存储来管理表和其他元数据。你可以选择使用内置的Derby数据库,或者使用外部数据库(如MySQL)作为元数据存储。如果选择使用外部数据库,需要安装并配置数据库。

第六步,验证安装:完成以上步骤后,你可以通过运行以下命令来验证Hive的安装是否成功:

hive --version

如果一切设置正确,将显示Hive的版本信息,如下图所示:

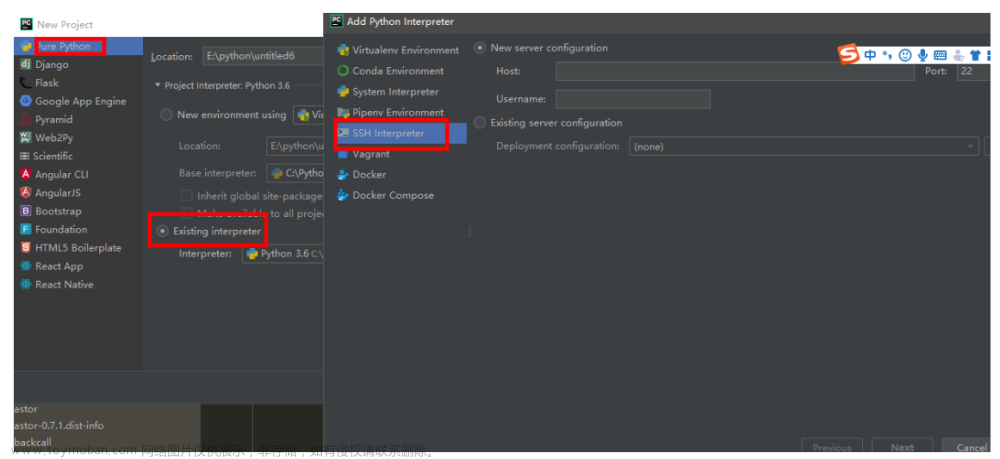

安装Scala

第一步,下载Scala:前往Scala的官方网站(https://www.scala-lang.org)下载所需的Scala发行版。选择相应版本的二进制发行版,并根据操作系统选择适当的下载链接。scala-3b6nh22cy04bst5bonmb58dmbyack2a.xn–,-no6azp10ata864bhnd575a5ybcwpha70nuul3kc5du7govap5mxr4dea478tjae1380bz4jhx5dwu0bxec06alfwa8271b./)

第二步,解压Scala文件:在Linux终端中,进入想要安装Scala的目录,并使用以下命令解压下载的Scala文件:

tar -xzf scala-x.x.x.tgz

第三步,配置环境变量:为了让系统正确找到Scala的执行文件,需要配置一些环境变量。编辑shell配置文件(例如.bashrc或.bash_profile),添加以下行:

export SCALA_HOME=/path/to/scala

export PATH= P A T H : PATH: PATH:SCALA_HOME/bin

将/path/to/scala替换为实际的Scala安装路径。保存文件后,运行以下命令使配置生效

source ~/.bashrc

第四步,验证安装:完成以上步骤后,可以通过运行以下命令来验证Scala的安装是否成功:

scala -version

如果一切设置正确,将显示Scala的版本信息。如下图所示:

部署spark集群

第一步,下载、上传、安装Spark .通过 xshell的 Xftp 上spark-3.2.1-bin-hadoop2.7.tgz 压缩包到/opt /apps目录,之后执行命令解压缩 spark-3.2.1-bin-hadoop2.7.tgz 文件。

tar -zxvf /opt/apps/spark-3.2.1-bin-hadoop2.7.tgz

第二步,修改Spark配置文件.Spark的配置文件位于Spark安装目录下的conf目录。修改 spark-env.sh.添加以下内容

export JAVA_HOME=/opt/apps/jdk

export HADOOP_CONF_DIR=/opt/apps/hadoop/etc/hadoop

第三步,配置Spark环境变量

export SPARK_HOME=/opt/apps/spark-3.2.1-bin-hadoop2.7

export PATH= P A T H : PATH: PATH:SPARK_HOME/bin

修改后执行source /etc/profifile命令使其生效。

第四步,Spark环境验证.执行下面的命令进入Spark Shell交互界面。

spark-shell --master yarn --deploy-mode client

进入后如下图所示:

通过博客中提供的步骤和演示图,你可以轻松地按照指导完成安装和配置过程。文章来源:https://www.toymoban.com/news/detail-516278.html

通过完成以上步骤,你将成功搭建一个大数据环境,包括Hadoop作为分布式文件系统和计算框架,MySQL作为关系数据库,Hive作为数据仓库,Scala作为编程语言,以及Spark作为大数据处理引擎。这个环境将为你的数据分析和处理提供强大的支持。文章来源地址https://www.toymoban.com/news/detail-516278.html

到了这里,关于构建大数据环境:Hadoop、MySQL、Hive、Scala和Spark的安装与配置的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!