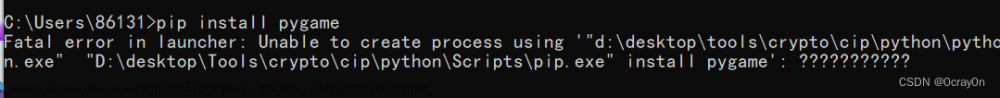

【问题描述】

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster('local').setAppName('My App')

sc = SparkContext(conf=conf)

rdd = sc.parallelize([1, 2, 3, 4, 5])

print(rdd.reduce(lambda a, b: a + b))

出现错误

【报错原因】

没有配置Python的环境变量,我们需要把环境变量写进去

【解决方法】

在原代码中加入以下代码

import os

os.environ['PYSPARK_PYTHON'] = r'C:\Users\WANG-PC\AppData\Local\Programs\Python\Python39\python.exe' #写你自己的路径

conf = SparkConf().setMaster('local').setAppName('My App')

sc = SparkContext(conf=conf)

rdd = sc.parallelize([1, 2, 3, 4, 5])

print(rdd.reduce(lambda a, b: a + b))

注:文件路径要替换成你自己Python解释器的路径。

如何看自己使用的Python解释器路径?

【成功解决】文章来源:https://www.toymoban.com/news/detail-517441.html

文章来源地址https://www.toymoban.com/news/detail-517441.html

文章来源地址https://www.toymoban.com/news/detail-517441.html

到了这里,关于解决pyspark报错 ERROR TaskSetManager: Task 0 in stage 1.0 failed 1 times; aborting job的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![【leetcode报错】 leetcode格式问题解决:error: stray ‘\302’ in program [solution.c]](https://imgs.yssmx.com/Uploads/2024/02/729904-1.png)