一、导读

SAM (Segment Anything )作为一个视觉的分割基础模型,在短短的3个月时间吸引了很多研究者的关注和跟进。如果你想系统地了解SAM背后的技术,并跟上内卷的步伐,并能做出属于自己的SAM模型,那么接下这篇Transformer-Based的Segmentation Survey是不容错过!

近期,南洋理工大学和上海人工智能实验室几位研究人员写了一篇关于Transformer-Based的Segmentation的综述,系统地回顾了近些年来基于Transformer的分割与检测模型,调研的最新模型截止至今年6月!

同时,综述还包括了相关领域的最新论文以及大量的实验分析与对比,并披露了多个具有广阔前景的未来研究方向!

论文地址:

https://arxiv.org/abs/2304.09854

发表单位:南洋理工大学,上海人工智能实验室

项目地址:

https://github.com/lxtGH/Awesome-Segmentation-With-Transformer

二、摘要

视觉分割旨在将图像、视频帧或点云分割为多个片段或组。这种技术具有许多现实世界的应用,如自动驾驶、图像编辑、机器人感知和医学分析。

在过去的十年里,基于深度学习的方法在这个领域取得了显著的进展。

最近,Transformer成为一种基于自注意力机制的神经网络,最初设计用于自然语言处理,在各种视觉处理任务中明显超越了以往的卷积或循环方法。

具体而言,视觉Transformer为各种分割任务提供了强大、统一甚至更简单的解决方案。

本综述全面概述了基于Transformer的视觉分割,总结了最近的进展。

首先,本文回顾了背景,包括问题定义、数据集和以往的卷积方法。接下来,本文总结了一个元架构,将所有最近的基于Transformer的方法统一起来。基于这个元架构,本文研究了各种方法设计,包括对这个元架构的修改和相关应用。此外,本文还介绍了几个相关的设置,包括3D点云分割、基础模型调优、域适应分割、高效分割和医学分割。此外,本文在几个广泛认可的数据集上编译和重新评估了这些方法。最后,本文确定了这个领域的开放挑战,并提出了未来研究的方向。

本文仍会持续和跟踪最新的基于Transformer的分割与检测方法。

三、内容解读

3.1 研究动机

- ViT和DETR的出现使得分割与检测领域有了十足的进展,目前几乎各个数据集基准上,排名靠前的方法都是基于Transformer的。为此有必要系统地总结与对比下这个方向的方法与技术特点。

- 近期的大模型架构均基于Transformer结构,包括多模态模型以及分割的基础模型(SAM),视觉各个任务向着统一的模型建模靠拢。

- 分割与检测衍生出来了很多相关下游任务,这些任务很多方法也是采用Transformer结构来解决。

3.2 这篇综述的特色,以及与以往的Transformer综述有什么区别?

- 系统性和可读性。本文系统地回顾了分割的各个任务定义,以及相关任务定义,评估指标。并且本文从卷积的方法出发,基于ViT和DETR,总结出了一种元架构。基于该元架构,本综述把相关的方法进行归纳与总结,系统地回顾了近期的方法。具体的技术回顾路线如图所示。

Survey的内容路线图:

- 技术的角度进行细致分类。相比于前人的Transformer 综述,本文对方法的分类会更加的细致。本文把类似思路的论文汇聚到一起,对比了他们的相同点以及不同点。例如,本文会对同时修改元架构的解码器端的方法进行分类,分为基于图像的Cross Attention,以及基于视频的时空Cross Attention的建模。

- 研究问题的全面性。本文会系统地回顾分割各个方向,包括图像,视频,点云分割任务。同时,本文也会同时回顾相关的方向比如开集分割于检测模型,无监督分割和弱监督分割。

常用的数据集以及分割任务总结:

3.3 Transformer-Based 分割和检测方法总结与对比

通用的元架构框架(Meta-Architecture):

本文首先基于DETR和MaskFormer的框架总结出了一个元架构。这个模型包括了如下几个不同的模块:

- Backbone:特征提取器,用来提取图像特征。

- Neck:构建多尺度特征,用来处理多尺度的物体。

- Object Query:查询对象,用于代表场景中的每个实体,包括前景物体以及背景物体。

- Decoder:解码器,用于去逐步优化Object Query以及对应的特征。

- End-to-End Training:基于Object Query的设计可以做到端到端的优化。

基于这个元架构,现有的方法可以分为如下五个不同的方向来进行优化以及根据任务进行调整,如图所示,每个方向有包含几个不同的子方向。

Transformer-Based Segmentation方法总结与对比:

- 更好的特征表达学习,Representation Learning。强大的视觉特征表示始终会带来更好的分割结果。本文将相关工作分为三个方面:更好的视觉Transformer设计、混合CNN/Transformer/MLP以及自监督学习。

- 解码器端的方法设计,Interaction Design in Decoder。本章节回顾了新的Transformer解码器设计。本文将解码器设计分为两组:一组用于改进图像分割中的交叉注意力设计,另一组用于视频分割中的时空交叉注意力设计。前者侧重于设计一个更好的解码器,以改进原始DETR中的解码器。后者将基于查询对象的目标检测器和分割器扩展到视频领域,用于视频目标检测(VOD)、视频实例分割(VIS)和视频像素分割(VPS),重点在建模时间一致性和关联性。

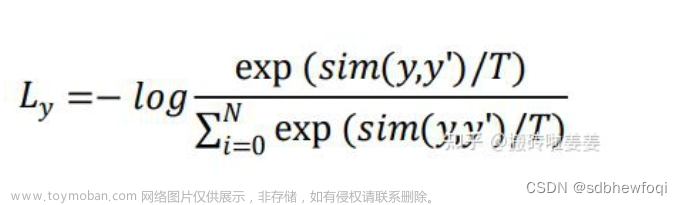

- 尝试从查询对象优化的角度,Optimizing Object Query。与Faster-RCNN相比,DETR要更长的收敛时间表。由于查询对象的关键作用,现有的一些方法已经展开了研究,以加快训练速度和提高性能。根据对象查询的方法,本文将下面的文献分为两个方面:添加位置信息和采用额外监督。位置信息提供了对查询特征进行快速训练采样的线索。额外监督着重设计了除DETR默认损失函数之外的特定损失函数。

- 使用查询对象来做特征和实例的关联,Using Query For Association。受益于查询对象的简单性,最近的多个研究将其作为关联工具来解决下游任务。主要有两种用法:一种是实例级别的关联,另一种是任务级别的关联。前者采用实例判别的思想,用于解决视频中的实例级匹配问题,例如视频的分割和跟踪。后者使用查询对象来桥接不同子任务实现高效的多任务学习。

- 多模态的条件查询对象生成,Conditional Query Generation。这一章节主要关注多模态分割任务。条件查询查询对象主要来处理跨模态和跨图像的特征匹配任务。根据任务输入条件而确定的,解码器头部使用不同的查询来获取相应的分割掩码。根据不同输入的来源,本文将这些工作分为两个方面:语言特征和图像特征。这些方法基于不同模型特征融合查询对象的策略,在多个多模态的分割任务以及few-shot分割上取得了不错的结果。

下图中给出这5个不同方向的一些代表性的工作对比。更具体的方法细节以及对比可以参考论文的内容。

Transformer-based的分割与检测代表性的方法总结与对比:

3.4 相关研究领域的方法总结与对比

本文还探索了几个相关的领域:1,基于Transformer的点云分割方法。2, 视觉与多模态大模型调优。3,域相关的分割模型研究,包括域迁移学习,域泛化学习。4,高效语义分割:无监督与弱监督分割模型。5,类无关的分割与跟踪。6,医学图像分割。

相关研究领域的基于Transformer方法总结与对比:

3.5 不同方法的实验结果对比

语义分割数据集的基准实验:

全景分割数据集的基准实验:

本文还统一地使用相同的实验设计条件来对比了几个代表性的工作在全景分割以及语义分割上多个数据集的结果。结果发现,在使用相同的训练策略以及编码器的时候,方法性能之间的差距会缩小。

此外,本文还同时对比了近期的Transformer-based的分割方法在多个不同数据集和任务上结果。(语义分割,实例分割,全景分割,以及对应的视频分割任务)文章来源:https://www.toymoban.com/news/detail-521418.html

3.6 未来可以进行的方向

此外本文也给出了一些未来的可能一些研究方向分析。这里给出三个不同的方向作为例子。文章来源地址https://www.toymoban.com/news/detail-521418.html

- 更加通用与统一的分割模型。使用Transformer结构来统一不同的分割任务是一个趋势。最近的研究使用基于查询对象的Transformer在一个体系结构下执行不同的分割任务。一个可能的研究方向是通过一个模型在各种分割数据集上统一图像和视频分割任务。这些通用模型可以在各种场景中实现通用和稳健的分割,例如,在各种场景中检测和分割罕见类别有助于机器人做出更好的决策。

- 结合视觉推理的分割模型。视觉推理要求机器人理解场景中物体之间的联系,这种理解在运动规划中起着关键作用。先前的研究已经探索了将分割结果作为视觉推理模型的输入,用于各种应用,如目标跟踪和场景理解。联合分割和视觉推理可以是一个有前景的方向,对分割和关系分类都具有互惠的潜力。通过将视觉推理纳入分割过程中,研究人员可以利用推理的能力提高分割的准确性,同时分割结果也可以为视觉推理提供更好的输入。

- 持续学习的分割模型研究。现有的分割方法通常在封闭世界的数据集上进行基准测试,这些数据集具有一组预定义的类别,即假设训练和测试样本具有预先知道的相同类别和特征空间。然而,真实场景通常是开放世界和非稳定的,新类别的数据可能不断出现。例如,在自动驾驶车辆和医学诊断中,可能会突然出现未预料到的情况。现有方法在现实和封闭世界场景中的性能和能力之间存在明显差距。因此,希望能够逐渐而持续地将新概念纳入分割模型的现有知识库中,使得模型能够进行终身学习。

到了这里,关于【计算机视觉】最新综述:南洋理工和上海AI Lab提出基于Transformer的视觉分割综述的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!