一、pom.xml配置

logstash依赖

<!--logback集成logstash-->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>4.11</version>

</dependency>二、logback.xml配置

给logback配置logstash的那台机器的ip和服务的端口

<appender name="logstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<!-- 这里设置logstash的ip地址和监听端口,防火墙放行该端口 -->

<destination>192.168.10.2:20001</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder"></encoder>

</appender>

<root level="debug">

<!-- 在原有的root中加上ref,调用logstash -->

<appender-ref ref="logstash"/>

</root>

三、logstash.conf

在logstash那台机器上配置

input {

tcp {

port => 20001

codec => json_lines

}

}

output {

stdout{

codec => json_lines

}

}在安装了logstash的服务器里,找到logstash文件目录,执行./logstash -f logstash.conf即可启动logstash

以上配置即可实现 logback 到 logstash。

下面是升级配置

四、其他配置

<encoder class="net.logstash.logback.encoder.LogstashEncoder">

<providers>

<timestamp/>

<version/>

<message/>

<loggerName/>

<threadName/>

<logLevel/>

<callerData/>

</providers>

</encoder>

input {

tcp {

mode => "server"

#这个需要配置成本机ip,不然logstash无法启动

host => "127.0.0.1"

#端口号

port => 4567

codec => json_lines

}

}

filter {

json {

source => "message"

remove_field => ["message"]

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

action=>"index"

#ES索引名称(自定义)

#index => "%{[appname]}-%{+YYYY.MM.dd}"

index => "logs1"

}

stdout{

codec => json_lines

}

}

===========================分割线===========================

以下是紫薯布丁

<!--logback集成logstash-->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>4.11</version>

</dependency>

<appender name="logstash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<!-- 这里设置logstash的ip地址和监听端口,防火墙放行该端口 -->

<destination>192.168.10.2:20001</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder"></encoder>

</appender>

<root level="debug">

<!-- 在原有的root中加上ref,调用logstash -->

<appender-ref ref="logstash"/>

</root>

input {

tcp {

port => 20001

codec => json_lines

}

}

output {

stdout{

codec => json_lines

}

}

<encoder class="net.logstash.logback.encoder.LogstashEncoder">

<providers>

<timestamp/>

<version/>

<message/>

<loggerName/>

<threadName/>

<logLevel/>

<callerData/>

</providers>

</encoder>

input {

tcp {

mode => "server"

#这个需要配置成本机ip,不然logstash无法启动

host => "127.0.0.1"

#端口号

port => 4567

codec => json_lines

}

}

filter {

json {

source => "message"

remove_field => ["message"]

}

} 文章来源:https://www.toymoban.com/news/detail-521799.html

output {

elasticsearch {

hosts => ["localhost:9200"]

action=>"index"

#ES索引名称(自己定义的)

#index => "%{[appname]}-%{+YYYY.MM.dd}"

index => "logs1"

}

stdout{

codec => json_lines

}

}

文章来源地址https://www.toymoban.com/news/detail-521799.html

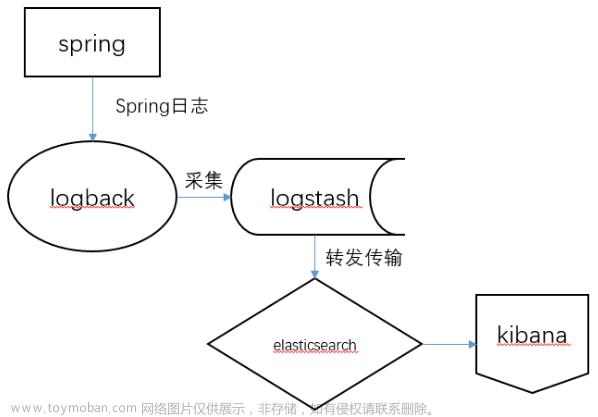

到了这里,关于日志采集 logback集成logstash ELK springboot的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!