物体可以在整个视频中自由移动,甚至经历严重的遮挡。英伟达的方法在目标上与物体级 SLAM 的先前工作类似,但放松了许多常见的假设,从而能够处理遮挡、反射、缺乏视觉纹理和几何线索以及突然的物体运动。

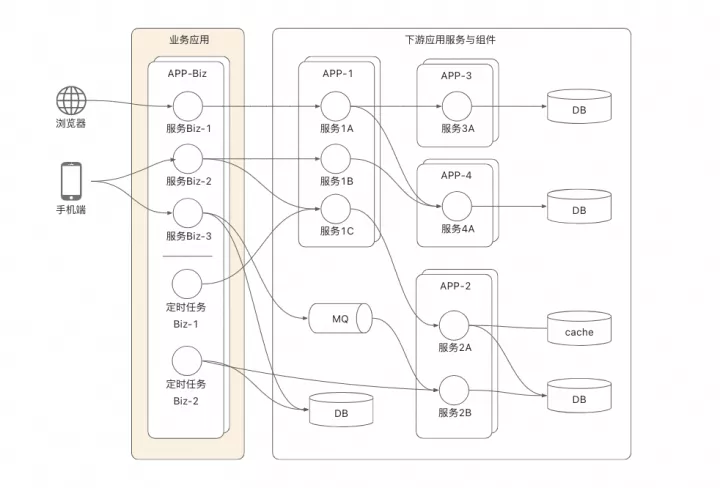

英伟达方法的关键在于在线姿态图优化过程,同时进行神经重建过程和一个内存池以促进两个过程之间的通信。

一种用于新颖未知动态物体的因果 6 自由度姿态跟踪和 3D 重建的新方法。该方法利用了并发跟踪和神经重建过程的新颖共同设计,能够在几乎实时的在线环境中运行,同时大大减少了跟踪漂移。

引入了混合 SDF 表示来处理动态物体为中心的环境中由于噪声分割和交互引起的不确定自由空间的挑战。

在三个公共基准测试中进行的实验显示了本文方法与主流方法的最先进性能。

此前的 6D 物体姿态估计旨在推断出目标物体在相机帧中的三维平移和三维旋转。最先进的方法通常需要实例或类别级别的物体 CAD 模型进行离线训练或在线模板匹配,这限制了它们在新颖未知物体上的应用。尽管最近有几项研究工作放宽了假设并旨在快速推广到新颖未见的物体,但它们仍然需要预先捕获测试物体的姿态参考视图,而英伟达的设定中并不假设这一点。

除了单帧姿态估计之外,6D 物体姿态跟踪利用时间信息在整个视频中估计每帧物体姿态。与单帧姿态估计方法类似,这些方法在不同的假设条件上进行,例如训练和测试使用相同的物体,或者在相同类别的物体上进行预训练。

然而,与所有以往工作不同的是,英伟达的追踪和重建协同设计采用了一种新颖的神经表示,不仅在实验证实中实现了更强大的跟踪能力,还能够输出额外的形状信息。

此外,虽然 SLAM(同时定位与地图构建)方法解决的是与本研究类似的问题,但其专注于跟踪相机相对于大型静态环境的姿态。动态 SLAM 方法通常通过帧 - 模型迭代最近点(ICP)与颜色相结合、概率数据关联或三维水平集似然最大化来跟踪动态物体。模型通过将观察到的 RGBD 数据与新跟踪的姿态聚合实时重建。

相比之下,英伟达的方法利用一种新颖的神经对象场表示,允许自动融合,同时动态矫正历史跟踪的姿态以保持多视角一致性。英伟达专注于物体为中心的场景,包括动态情景,其中常常缺乏纹理或几何线索,并且交互主体经常引入严重遮挡,这些是在传统 SLAM 中很少发生的困难。与物体级 SLAM 研究中研究的静态场景相比,动态交互还允许观察物体的不同面以进行更完整的三维重建。

整个框架的流程可以概括为:首先在连续的分割图像之间匹配特征,以获得粗略的姿态估计。其中一些具有姿态的帧被存储在内存池中,以便稍后使用和优化。从内存池的子集动态创建姿态图;在线优化与当前姿态一起优化图中的所有姿态。

然后,这些更新的姿态被存储回内存池中。最后,内存池中的所有具有姿态的帧用于学习基于 SDF 表示的神经物体场(在单独并行的线程中),该对象场建模物体的几何和视觉纹理,同时调整它们先前估计的姿态,以鲁棒化 6D 物体姿态跟踪。文章来源:https://www.toymoban.com/news/detail-527181.html

在这项工作中,一个独特的挑战在于交互者引入的严重遮挡,导致了多视几何不再一致。并且完美的物体分割掩码通常无法得到。为此,英伟达进行了独特的建模以增加鲁棒性。文章来源地址https://www.toymoban.com/news/detail-527181.html

到了这里,关于英伟达新SOTA可对未知物体进行6D追踪和3D重建的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!