声明:此翻译仅为个人学习记录

文章信息

- 标题:RangeDet: In Defense of Range View for LiDAR-based 3D Object Detection (ICCV 2021)

- 作者:Lue Fan*, Xuan Xiong*, Feng Wang, Naiyan Wang, Zhaoxiang Zhang (*The first two authors contribute equally to this work and are listed in the alphabetical order.)

- 文章链接:https://openaccess.thecvf.com/content/ICCV2021/papers/Fan_RangeDet_In_Defense_of_Range_View_for_LiDAR-Based_3D_Object_ICCV_2021_paper.pdf

- 文章代码:https://github.com/TuSimple/RangeDet

摘要

在本文中,我们提出了一种基于无锚单级激光雷达的3D目标检测器——RangeDet。与以前的工作最显著的区别是,我们的方法完全基于距离视图表示。与常用的体素化或鸟瞰图(BEV)表示相比,距离视图表示更紧凑,没有量化误差。尽管有工作将其用于语义分割,但其在目标检测中的性能在很大程度上落后于体素化或BEV对应物。我们首先分析了现有的基于距离视图的方法,并发现了先前工作中忽略的两个问题:1)附近和远处目标之间的尺度变化;2) 特征提取中使用的2D距离图像坐标与输出中使用的3D笛卡尔坐标之间的不一致。然后我们在RangeDet中故意设计了三个组件来解决这些问题。我们在大规模Waymo开放数据集(WOD)中测试了RangeDet。我们的最佳模型在车辆/行人/骑车人上实现了72.9/75.9/65.8 3D AP。这些结果在很大程度上优于其他基于距离视图的方法,总体上与最先进的基于多视图的方法相当。代码将发布于https://github.com/TuSimple/RangeDet。

1. 引言

基于激光雷达的三维目标检测是自动驾驶场景中不可或缺的技术。尽管有一些相似之处,但3D稀疏点云中的目标检测与2D中的目标检测有着本质上的不同。关键是有效地表示稀疏和无序的点云,以便后续处理。几种常见的表示包括鸟瞰图(BEV)[9、38、37]、点视图(PV)[25]、距离视图(RV)[11、18]以及它们的融合[24、44、33],如图1所示。其中,BEV最受欢迎。然而,当将空间划分为体素或柱体时,它会引入量化误差,这对于可能只有几个点的远处目标来说是不友好的。为了克服这一缺点,通常采用点视图表示法。点视图算子[22,23,34,31,35,30,17]可以从无序的点云中提取有效的特征,但它们很难有效地扩展到大规模的点云数据。

图1. 基于LiDAR的3D目标检测中的不同视图。

距离视图在语义分割任务中被广泛采用[19,36,42,43],但很少单独用于目标检测。然而,在本文中,我们认为距离视图本身是表示LiDAR点云的最紧凑和信息最丰富的方式,因为它是从单个视点生成的。它基本上形成了2.5D[7]场景,而不是完整的3D点云。因此,在距离视图中组织点云不会遗漏任何信息。紧凑性还支持基于距离图像坐标的快速邻域查询,而点视图方法通常需要耗时的球查询算法[23]来获取邻域。此外,基于距离视图的检测器的有效检测距离可以尽可能远地接近传感器的可用性,而我们必须为基于BEV的3D检测器的检测距离设置阈值。尽管有其优点,但一个有趣的问题是,为什么基于距离视图的激光雷达检测结果不如其他表示形式?

事实上,一些作品试图利用距离视图,从开创性作品VeloFCN[11]到LaserNet[18],再到最近提出的RCD[1]。然而,基于纯距离视图的方法和基于BEV的方法之间仍然存在巨大的差距。例如,在Waymo开放数据集(WOD)[29]上,它们仍然大大低于最先进的方法。

为了解放距离视图表示的能力,我们检查了当前基于距离视图的检测器的设计,并发现了几个被忽略的事实。这些观点看似简单明了,但我们发现魔鬼在细节上。正确处理这些挑战是高性能基于距离视图的检测的关键。

首先,在BEV中检测具有稀疏点的目标的挑战被转换为距离图像中的尺度变化的挑战,这在基于距离视图的3D检测器中从未被认真考虑过。

第二,2D距离视图自然紧凑,这使得可以采用高分辨率输出而无需巨大的计算负担。然而,当前基于距离图像的设计忽略了如何利用这些特性来提高检测器的性能。

第三,也是最重要的,与2D图像不同,尽管距离图像上的卷积是在2D像素坐标上进行的,而输出是在3D空间中。这一点表明,当前基于距离视图的检测器的设计较差:标准卷积的核权重和聚合策略都忽略了这种不一致性,即使从网络的一开始,这也会导致严重的几何信息丢失。

在本文中,我们提出了一种基于纯距离视图的框架——RangeDet,它是一种单级无锚检测器,旨在解决上述挑战。我们分析了现有基于距离视图的3D检测器的缺陷,并指出了需要解决的上述三个关键挑战。对于第一个挑战,我们提出了一个简单但有效的距离条件金字塔来缓解它。对于第二个挑战,使用加权非最大抑制来解决这个问题。对于第三种,我们提出元核来从2D距离视图表示中捕获3D几何信息。除了这些技术,我们还探讨了如何将常见的数据增强技术从3D空间转移到距离视图。结合所有技术,我们的最佳模型在多个视图中获得了与最先进的作品相当的结果。在车辆检测中,我们超过了以前的基于纯距离视图的检测器20个3D AP。有趣的是,与普遍的看法相反,RangeDet对于更远或更小的目标比BEV表示更有利。

2. 相关工作

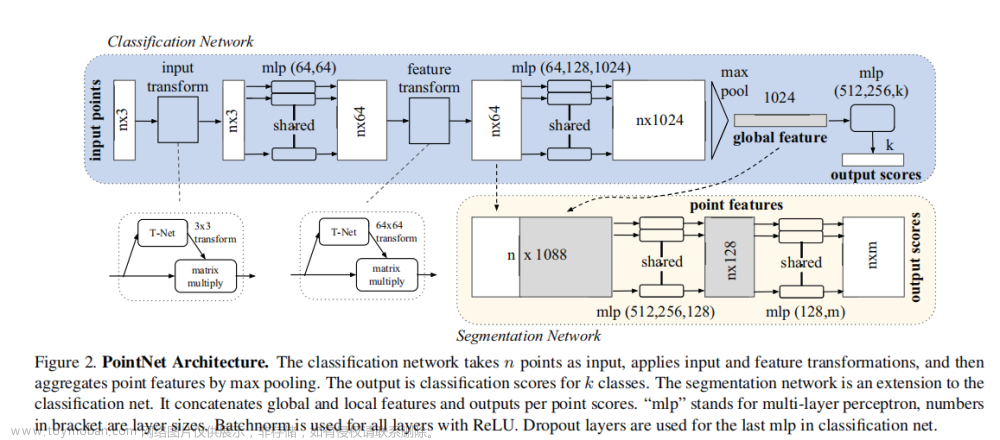

基于BEV的3D检测器。基于LiDAR的3D检测的几种方法将整个3D空间离散化。3DFCN[10]和PIXOR[38]将手工特征编码为体素,而VoxelNet[45]是第一个使用端到端学习体素特征的。SECOND[37]通过稀疏卷积加速VoxelNet。PointPillars[9]在特征缩减方面非常激进,它应用PointNet首先折叠高度维度,然后将其视为伪图像。

基于点视图的3D检测器。F-PointNet[21]首先生成与2D感兴趣区域(ROI)相对应的平截头体,然后使用PointNet[22]分割前景点并回归3D边界框。PointRCNN[25]直接从整个点云生成3D建议,而不是通过在建议生成和细化中使用PointNet++[23]使用点云进行3D检测的2D图像。IPOD[39]和STD[40]都是两个阶段的方法,它们使用前景点云作为种子来生成建议,并在第二阶段对其进行细化。最近,LiDAR RCNN[13]提出了一种通用的提案细化结构,解决了提案的大小模糊问题。

基于距离视图的3D检测器。VeloFCN[11]是距离图像检测领域的一项开创性工作,它将点云投影到2D,并应用2D卷积来密集预测每个前景点的3D框。LaserNet[18]使用完全卷积网络来预测每个点的多模态分布,以生成最终预测。最近,RCD[1]通过学习尺度变化的动态扩展和伪LiDAR[32]中指出的“边界模糊”问题的软距离门控,解决了基于距离视图的检测中的挑战。

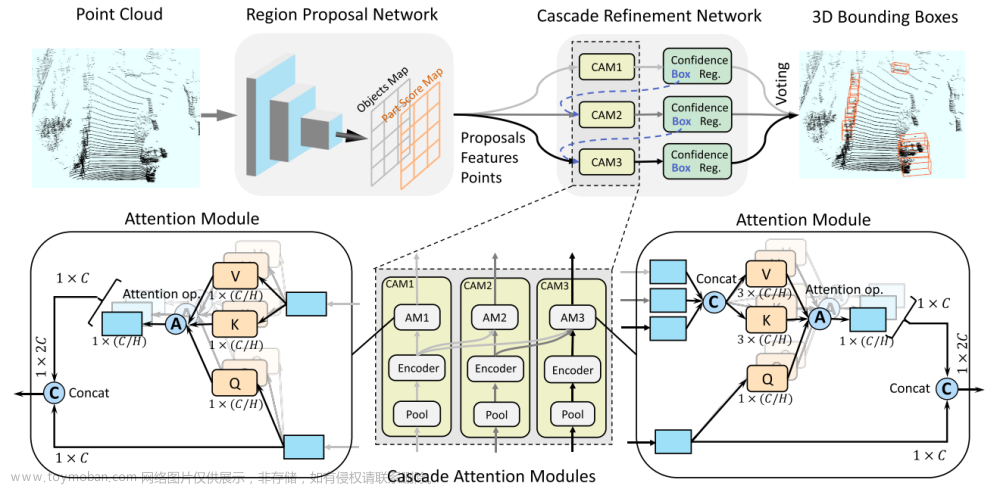

基于多视图的3D检测器。MV3D[2]是第一个融合前视图、BEV和相机视图中的特征用于3D目标检测的工作。PV-RCNN[24]联合编码点和体素信息,以生成高质量的3D建议。MVF[44]从不同角度为每个点提供了丰富的上下文信息,以改进小目标的检测。

2D检测器。尺度变化是二维目标检测中的一个长期问题。SNIP[27]和SNIPER[28]基于图像金字塔的思想将提案重新缩放到标准化大小。FPN[14]及其变体[16,20]构建了特征金字塔,这已成为现代检测器不可或缺的组件。TridentNet[12]构建权重共享分支,但使用不同的扩展来构建比例感知特征图。

3. 距离视图表示的回顾

在本节中,我们将快速回顾激光雷达数据的距离视图表示。

图2. 此处距离图像的图示。

对于在一个扫描周期内具有m个光束和n次测量的LiDAR,一次扫描的返回值形成一个m×n矩阵,称为距离图像(图1)。距离图像的每一列共享一个方位角,距离图像的各行共享一个倾角。它们表示返回点相对于激光雷达原点的相对垂直和水平角度。距离图像中的像素值包含对应点的距离(深度)、返回的激光脉冲的幅度(称为强度)和其他辅助信息。距离图像中的一个像素至少包含三个几何值:距离r、方位角θ和倾角φ。然后,这三个值定义了球面坐标系。图2说明了距离图像的形成和这些几何值。通常使用的具有笛卡尔坐标的点云数据实际上是从球面坐标系解码的:

其中x,y,z表示点的笛卡尔坐标。请注意,距离视图仅对从一个视点进行的扫描有效。它不适用于一般点云,因为它们可能在距离图像中重叠一个像素。

与其他激光雷达数据集不同,WOD直接提供原生距离图像。除了距离和强度值,WOD还提供了另一种信息,称为伸长率[29]。伸长测量激光脉冲的宽度被拉长的程度,这有助于区分假目标。

4. 方法

在本节中,我们首先详细介绍RangeDet的三个组件。然后给出了完整的体系结构。

4.1 距离条件金字塔

在2D检测中,通常采用基于特征金字塔的方法,如特征金字塔网络(FPN)[14]来解决尺度变化问题。我们首先构建FPN中的特征金字塔,如图4所示。尽管特征金字塔的构造与二维目标检测中的FPN相似,但不同之处在于如何将每个目标分配到不同的层进行训练。在原始FPN中,根据其在2D图像中的面积指定真值边界框。然而,简单地采用这种分配方法忽略了2D目标图像和3D笛卡尔空间之间的差异。附近的客车可能与远处的卡车有相似的区域,但它们的扫描模式有很大不同。因此,我们指定具有相似距离的目标由同一层处理,而不是纯粹使用FPN中的区域。因此,我们将我们的结构命名为距离条件金字塔(RCP)。

4.2 元核卷积

与RGB图像相比,深度信息赋予距离图像以笛卡尔坐标系,然而标准卷积被设计用于规则像素坐标上的2D图像。对于卷积核内的每个像素,权重仅取决于相对像素坐标,这不能充分利用来自笛卡尔坐标的几何信息。在本文中,我们设计了一种新的算子,它从相对笛卡尔坐标或更多元数据中学习动态权重,使卷积更适合于距离图像。

为了更好地理解,我们首先将标准卷积分解为四个部分:采样、权重获取、乘法和聚合。

1)取样。标准卷积中的采样位置是规则网格G,其具有kh×kw相对像素坐标。例如,具有扩张1的常见3×3采样网格为:

对于输入特征映射F上的每个位置p0,我们通常使用im2col运算对其邻居F(p0+pn),pn∈G的特征向量进行采样。

2)权重获取。每个采样位置(p0+pn)的权重矩阵W(pn)∈RCout×Cin取决于pn,并且对于给定的特征图是固定的。这也被称为卷积的“权重共享”机制。

3)乘法。我们将标准卷积的矩阵乘法分解为两个步骤。第一步是逐像素矩阵乘法。对于每个采样点(p0+pn),其输出定义为

4)聚合。乘法之后,第二步是对G中的所有op0(pn)求和,这被称为按通道道求和。

总之,标准卷积可以表示为:

在我们的距离视图卷积中,我们期望卷积运算能够感知局部3D结构。因此,我们通过元学习方法使权重自适应于局部3D结构。

对于权重获取,我们首先收集每个采样位置的元信息,并将该关系向量表示为h(p0,pn)。h(p0,pn)通常包含相对笛卡尔坐标、距离值等。然后我们基于h(p0,pn)生成卷积权重Wp0(pn)。具体而言,我们应用具有两个完全连接层的多层感知器(MLP):

对于乘法,而不是矩阵乘法,我们简单地使用逐元素乘积来获得op0(pn),如下所示:

我们不使用矩阵乘法,因为我们的算法在大型点云上运行,并且节省形状为H×W×Cout×kh×kw×Cin的权重张量需要太多GPU内存。受深度卷积的启发,元素乘积从权重张量中消除了Cout维数,这大大减少了内存消耗。然而,在逐元素积中没有跨通道融合。我们把它留给聚合步骤。

对于聚合,而不是按通道求和,我们连接所有op0(pn),∀pn∈G,并将其传递到完全连接的层,以聚合来自不同通道和不同采样位置的信息。

综上所述,元内核可以公式化为:

其中A是包含级联和完全连接层的聚合操作。图3提供了元内核的清晰图示。

图3. 元内核的图示(最好用彩色查看)。以3x3采样网格为例,我们可以获得中心九个邻居的相对笛卡尔坐标。共享MLP将这些相对坐标作为输入,生成九个权重向量:w1、w2、··、w9。然后我们采样九个输入特征向量:f1、f2、··、f9。oi是wi和fi的元素乘积。通过将来自9个邻居的oi级联到1×1卷积,我们聚合来自不同通道和不同采样位置的信息,并获得输出特征向量。

与基于点的运算符进行比较。尽管与基于点的卷积类算子有一些相似之处,但元内核与它们有三个显著的区别。(1) 定义空间。元内核是在2D距离视图中定义的,而其他内核是在3D空间中定义的。因此,元核具有规则的n×n邻域,而基于点的算子具有不规则的邻域。(2) 聚合。三维空间中的点是无序的,因此基于点的算子中的聚合步骤通常是置换不变的。最大池和求和被广泛采用。RV中的n×n个邻居是置换变量,这是元核采用级联和全连接层作为聚合步骤的自然优势。(3) 效率。基于点的运算符涉及耗时的关键点采样和邻居查询。例如,在单个2080Ti GPU中,使用最远点采样(FPS)[23]将160K点下采样到16K需要6.5秒,这也在RandLA Net中进行了分析[8]。一些基于点的算子,如PointConv[35]、KPConv[30]和Continuous Conv[31]的原生版本,为每个点生成权重矩阵或特征矩阵,因此它们在处理大规模点云时面临严重的内存问题。这些缺点使基于点的算子无法应用于自动驾驶场景中的大规模点云(超过105点)。

4.3 加权非最大抑制

如前所述,如何利用距离视图表示的紧凑性来提高基于距离图像的检测器的性能是一个重要课题。在常见的目标检测器中,提案不可避免地与提案分布的平均值存在随机偏差。要得到一个偏差较小的提案,最直接的方法就是选择一个置信度最高的提案。而消除偏差的更好、更有力的方法是使用所有可用提案的多数票。现成的技术正好符合我们的需求——加权NMS[5]。我们的方法有一个优点:紧凑性的性质使得RangeDet可以在全分辨率特征图中生成提案,而无需巨大的计算成本,但是对于大多数基于BEV或基于点视图的方法来说,这是不可行的。有了更多的提案,偏差将得到更好的消除。

我们首先过滤出得分低于预定义阈值0.5的提案,然后按照标准NMS中的预测得分对提案进行排序。对于当前排名靠前的提案b0,我们找出具有b0的IoU高于0.5的提案。b0的输出边界框是这些提案的加权平均值,可以描述为:

其中bk和sk表示其他提案和相应的分数。t是IoU阈值,为0.5。I(·)是指示函数。

4.4 距离视图中的数据增强

随机全局旋转、随机全局翻转和复制粘贴是基于激光雷达的三维目标检测器的三种典型数据增强。尽管它们在3D空间中很简单,但在保留RV结构的同时,将它们转移到RV是非常重要的。

点云的旋转可以视为距离图像沿方位角方向的平移。3D空间中的翻转对应于相对于一个或两个垂直轴的距离图像的翻转(我们在补充材料中提供了清晰的说明)。从最左边的列到最右边,方位角的跨度为(−π,π)。因此,与2D RGB图像的增强不同,我们计算每个点的新坐标以使其与方位角保持一致。对于复制粘贴[37],目标将使用其原始垂直像素坐标粘贴到新距离图像上。我们只能保持RV(非均匀垂直角分辨率)的结构,并通过这种处理避免目标大量偏离地面。此外,远处的汽车不应贴在附近墙壁的前面,因此我们进行“距离测试”以避免这种情况。

4.5 体系结构

整体管道。RangeDet的架构如图4所示。八个输入距离图像通道包括距离、强度、延伸率、x、y、z、方位角和倾角,如第3节所述。元内核被放置在第二个基本块[6]中。特征图被向下采样到步幅16,并逐渐向上采样到全分辨率。接下来,我们根据框中心的距离,将每个真值边界框分配给RCP中步幅1、2、4的层。对应点位于真值3D边界框中的所有位置都被视为正样本,否则为负样本。最后,我们采用加权NMS来消除提案的重复并生成高质量的结果。

RCP和元内核。在WOD中,点的距离从0m到80m不等。根据真值边界框中的点分布,我们将[0,80]划分为3个区间:[0,15),[15,30),[30,80]。我们使用具有64个滤波器的两层MLP从相对笛卡尔坐标生成权重。采用ReLU作为激活。

IoU预测头。在分类分支中,我们采用了一项非常新的工作——变焦损失[41]来预测预测边界框和真值边界框之间的IoU。我们的分类损失定义为:

其中M是有效点数,i是点索引。VFLi是每个点的变焦距损失:

其中p是预测得分,q是预测边界框和真值边界框之间的IoU。α和γ在焦损中起着类似的作用[15]。

回归头。回归分支还包含四个3×3 Conv,与分类分支相同。我们首先将包含点i(这里,点实际上是特征地图中的一个位置,并对应于笛卡尔坐标。为了更好地理解,我们仍然称之为一个点。)的真值边界框公式化为

(

x

i

g

,

y

i

g

,

z

i

g

,

l

i

g

,

w

i

g

,

h

i

g

,

θ

i

g

)

(x^g_i,y^g_i,z^g_i,l^g_i,w^g_i,h^g_i,θ^g_i)

(xig,yig,zig,lig,wig,hig,θig),以分别表示边界框中心、维度和方向的坐标。点i的笛卡尔坐标为

(

x

i

,

y

i

,

z

i

)

(x_i,y_i,z_i)

(xi,yi,zi)。我们将点i和包含点i的边界框中心之间的偏移定义为

∆

r

i

=

r

i

g

−

r

i

∆r_i=r^g_i−r_i

∆ri=rig−ri,r∈{x,y,z}。对于点i,我们将其方位角方向视为其局部x轴,这与LaserNet中的相同[18]。我们制定这种转换公式如下(图5提供了一个清晰的说明):

其中,αi表示点i的方位角,以及

[

Ω

x

i

,Ω

y

i

,Ω

z

i

]

[Ωx_i,Ωy_i,Ωz_i]

[Ωxi,Ωyi,Ωzi]是要回归的变换坐标偏移。这样的变换目标适合于基于距离图像的检测,因为目标在距离图像中的外观不会随着固定距离内的方位角而改变。因此,使回归目标的方位不变是合理的。所以对于每个点,我们将方位角方向视为局部x轴。

图4. RangeDet的整体架构。

图5. 两种回归目标的图示。左:对于所有点,以自我为中心的坐标系的x轴被视为局部x轴。右:对于每个点,其方位角方向视为局部x轴。在计算回归损失之前,我们首先将第一类目标转换为后者。

我们将点i的真值目标集Qi表示为

{

Ω

x

i

g

,

Ω

y

i

g

,

Ω

z

i

g

,

l

o

g

l

i

g

,

l

o

g

w

i

g

,

l

o

g

h

i

g

,

c

o

s

φ

i

g

,

s

i

n

φ

i

g

}

\{Ωx^g_i, Ωy^g_i, Ωz^g_i, log\ l^g_i, log\ w^g_i, log\ h^g_i, cos\ φ^g_i, sin\ φ^g_i\}

{Ωxig,Ωyig,Ωzig,log lig,log wig,log hig,cos φig,sin φig}。因此回归损失定义为

其中pi是qi的预测对应物。N是真值边界框的数量,ni是包含点i的边界框中的点数。总损失是Lcls和Lreg的总和。

5. 实验

我们在大规模Waymo开放数据集(WOD)上进行了实验,这是唯一提供原生距离图像的数据集。我们报告了所有实验中的LEVEL_1平均精度,以与其他方法进行比较。有关管道的详细结果和配置,请参阅补充材料。使用整个训练数据集在表1、表3和表9中进行实验。我们为其他实验统一采样了25%的训练数据(约40k帧)。

5.1 元核卷积的研究

在本节中,我们进行了大量实验来消融元内核。这些实验不涉及数据扩充。我们通过用2D 3×3卷积替换元内核来构建基线。

不同的输入特征。表2显示了作为输入的不同元信息的结果。毫不奇怪,与基线相比,使用相对像素坐标(E4)只带来了边际改善,证明了在核权重中使用笛卡尔信息的必要性。

放置元内核的不同位置。我们将元内核置于不同阶段。结果如表4所示,这表明元内核在较低级别上更突出。这一结果是合理的,因为低层与几何结构有着更密切的联系,而元内核在几何结构中起着至关重要的作用。

表4. 当元内核被放置在不同步伐的不同阶段时,车辆类的性能。

在小目标上的性能。对于距离视图中的小目标(例如行人),边界信息比大目标更重要,以避免被背景稀释。元核通过捕获局部几何特征来增强边界信息,因此它在小目标检测中特别强大。表5显示了显著的效果。

表5. 行人的元内核消融。

与基于点的算子进行比较。我们在第4.2节中讨论了元内核和基于点的运算符之间的主要区别。为了公平比较,我们在具有固定3×3邻域的2D距离图像上实现了一些典型的基于点的算子,就像我们的元核一样。实施细节请参考补充材料。由于内存成本巨大,一些运算符(如KPConv[30]、PointConv[35])未实现。如表6所示,这些方法都获得了较差的结果。我们归功于他们在无序点云中用于聚合的策略,这将在接下来详细描述。

表1. 在车辆检测中消融我们的部件。DA代表数据增强。

表2。元内核不同输入的性能比较。在基线实验中,元核被3×3 2D卷积代替。(xi,yi,zi)、(ui,vi)和ri分别表示笛卡尔坐标、像素坐标和距离。

不同的聚合方式。与其他基于点的算子一样,我们尝试以通道方式进行最大池和求和,而不是级联,表7显示了结果。当使用最大池或求和时,性能会显著下降,因为它们对来自不同位置的特征一视同仁。这些结果证明了在距离视图中保持和利用相对顺序的重要性。请注意,由于点云的无序性,其他视图不能采用串联。

表6. 与基于点的算子进行比较。后缀“RV”表示该方法基于RV中固定的3×3邻域,而不是3D空间中的动态邻域。此表中的ContinuousConv是高效版本。

表7. 不同聚合策略的结果。

5.2 距离条件金字塔的研究

我们尝试其他三种策略来指定边界框,而不是限制范围:方位跨度、投影面积和可见面积。边界框的方位跨度与其在距离图像中的宽度成比例。投影面积是投影到距离图像中的长方体的面积。可见区域是可见目标部分的区域。注意,面积是2D检测中的标准分配标准。为了公平比较,我们在这些策略之间保持一定步长内的真值框的数量一致。结果见表8。我们将较差的结果归因于姿势变化和遮挡,这会使同一个目标落入不同的层,具有不同的姿势或遮挡条件。这样的结果表明,仅考虑距离图像中的尺度变化是不够的,因为一些其他物理特征,例如强度、密度,会随着距离而变化。

表8. 不同分配策略的比较。

5.3 加权非最大抑制研究

为了支持我们在第4.3节中的主张,我们基于MMDetection3D(https://github.com/open-mmlab/mmdetection3d)中的强基线,在两种典型的基于体素的方法中应用加权NMS——PointPillars[9]和SECOND[37]。表9显示,加权NMS在RangeDet中的改进比基于体素的方法要好得多。

表3. WOD验证划分评估车辆和行人的结果。骑车人的详细成绩请参考补充材料。BEV:鸟瞰图。RV:距离视图。CV:圆柱形视图[33]。PV:点视图。¶:由MMDetection3D实施。最好的结果和第二个结果分别用红色和蓝色标记。

表9. 不同检测器的加权NMS结果。

5.4 消融实验

我们进一步对我们使用的组件进行消融实验。表1总结了结果。元内核在不同的环境中都是有效和健壮的。RCP和加权NMS都显著提高了整个系统的性能。虽然IoU预测是最近3D检测器的常见实践[24,26],但它对RangeDet有相当大的影响,因此我们在表1中对其进行了描述。

5.5 与现有技术方法的比较

表3显示RangeDet优于其他基于纯距离视图的方法,并且略落后于最先进的基于BEV的两阶段方法。在所有的结果中,我们观察到了一个有趣的现象:与距离视图在远程检测中处于劣势的刻板印象不同,RangeDet在远程度量(即50m-inf)方面优于大多数其他比较方法,尤其是在行人类中。与视野不同,BEV中的行人非常小。这再次验证了距离视图表示的优越性以及我们对距离视图输入和3D笛卡尔输出空间之间的不一致性的补救措施的有效性。

5.6 KITTI结果

基于距离视图的检测器比基于BEV的检测器更需要数据,这在LaserNet[18]中得到了证明。尽管广泛使用的KITTI数据集[4]没有包含足够的训练数据来揭示RangeDet的潜力,但我们从官方测试服务器报告了KITTI的结果,以便与以前基于距离视图的方法进行公平比较。表10显示RangeDet的结果比以前的基于距离的方法要好得多,包括从WOD预训练中微调的RCD模型。

表10. KITTI汽车测试划分上的BEV性能。RCD-FT从WOD预训练中进行微调。

5.7 运行时评估

在Waymo开放数据集上,我们的模型在单个2080Ti GPU上实现了12 FPS,无需刻意优化。注意,我们的方法的运行时速度不受有效检测距离的扩展的影响,而基于BEV的方法的速度将随着最大检测距离的扩大而迅速减慢。

6. 结论

我们提出了RangeDet,这是一个基于距离视图的检测框架,由元内核、距离条件金字塔和加权NMS组成。通过我们的特殊设计,RangeDet利用距离视图的特性来克服一些挑战。RangeDet与最先进的基于多视图的检测器相比,性能相当。

Acknowledgements

This work was supported in part by the Major Project for New Generation of AI (No.2018AAA0100400) the National Natural Science Foundation of China (No. 61836014, No. 61773375, No. 62072457), and in part by the TuSimple Collaborative Research Project.文章来源:https://www.toymoban.com/news/detail-529912.html

References

[1] Alex Bewley, Pei Sun, Thomas Mensink, Dragomir Anguelov, and Cristian Sminchisescu. Range Conditioned Dilated Convolutions for Scale Invariant 3D Object Detection. In Conference on Robot Learning (CoRL), 2020. 2, 8

[2] Xiaozhi Chen, Huimin Ma, Ji Wan, Bo Li, and Tian Xia. Multi-View 3D Object Detection Network for Autonomous Driving. In CVPR, pages 1907–1915, 2017. 2

[3] Jiajun Deng, Shaoshuai Shi, Peiwei Li, Wengang Zhou, Yanyong Zhang, and Houqiang Li. Voxel R-CNN: Towards High Performance Voxel-based 3D Object Detection. 2021.8

[4] Andreas Geiger, Philip Lenz, and Raquel Urtasun. Are we ready for autonomous driving? the kitti vision benchmark suite. In CVPR, pages 3354–3361. IEEE, 2012. 8

[5] Spyros Gidaris and Nikos Komodakis. Object detection via a multi-region semantic segmentation-aware CNN model. In ICCV, pages 1134–1142, 2015. 5

[6] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep Residual Learning for Image Recognition. In CVPR, pages 770–778, 2016. 5

[7] Peiyun Hu, Jason Ziglar, David Held, and Deva Ramanan. What you see is what you get: Exploiting visibility for 3d object detection. In CVPR, pages 11001–11009, 2020. 1

[8] Qingyong Hu, Bo Yang, Linhai Xie, Stefano Rosa, Yulan Guo, Zhihua Wang, Niki Trigoni, and Andrew Markham. RandLA-Net: Efficient semantic segmentation of large-scale point clouds. In CVPR, pages 11108–11117, 2020. 4, 7

[9] Alex H Lang, Sourabh Vora, Holger Caesar, Lubing Zhou, Jiong Yang, and Oscar Beijbom. PointPillars: Fast Encoders for Object Detection from Point Clouds. In CVPR, pages 12697–12705, 2019. 1, 2, 7, 8

[10] Bo Li. 3D Fully Convolutional Network for Vehicle Detection in Point Cloud. In IROS, pages 1513–1518, 2017. 2

[11] Bo Li, Tianlei Zhang, and Tian Xia. Vehicle Detection from 3D Lidar Using Fully Convolutional Network. 2016. 1, 2

[12] Yanghao Li, Yuntao Chen, Naiyan Wang, and Zhaoxiang Zhang. Scale-Aware Trident Networks for Object Detection. In ICCV, pages 6054–6063, 2019. 2

[13] Zhichao Li, Feng Wang, and Naiyan Wang. LiDAR R-CNN: An Efficient and Universal 3D Object Detector. In CVPR, pages 7546–7555, 2021. 2

[14] Tsung-Yi Lin, Piotr Doll´ar, Ross Girshick, Kaiming He, Bharath Hariharan, and Serge Belongie. Feature Pyramid Networks for Object Detection. In CVPR, pages 2117–2125, 2017. 2, 3

[15] Tsung-Yi Lin, Priya Goyal, Ross Girshick, Kaiming He, and Piotr Doll´ar. Focal Loss for Dense Object Detection. In ICCV, pages 2980–2988, 2017. 5

[16] Shu Liu, Lu Qi, Haifang Qin, Jianping Shi, and Jiaya Jia. Path Aggregation Network for Instance Segmentation. In CVPR, pages 8759–8768, 2018. 2

[17] Yongcheng Liu, Bin Fan, Shiming Xiang, and Chunhong Pan. Relation-Shape Convolutional Neural Network for Point Cloud Analysis. In CVPR, pages 8895–8904, 2019. 1, 7

[18] Gregory P Meyer, Ankit Laddha, Eric Kee, Carlos Vallespi Gonzalez, and Carl K Wellington. LaserNet: An Efficient Probabilistic 3D Object Detector for Autonomous Driving. In CVPR, pages 12677–12686, 2019. 1, 2, 5, 8

[19] Andres Milioto, Ignacio Vizzo, Jens Behley, and Cyrill Stachniss. RangeNet++: Fast and Accurate LiDAR Semantic Segmentation. In IROS, pages 4213–4220, 2019. 1

[20] Jiangmiao Pang, Kai Chen, Jianping Shi, Huajun Feng, Wanli Ouyang, and Dahua Lin. Libra R-CNN: Towards Balanced Learning for Object Detection. In CVPR, pages 821–830, 2019. 2

[21] Charles R Qi, Wei Liu, Chenxia Wu, Hao Su, and Leonidas J Guibas. Frustum PointNets for 3D Object Detection from RGB-D Data. In CVPR, pages 918–927, 2018. 2

[22] Charles R Qi, Hao Su, Kaichun Mo, and Leonidas J Guibas. PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation. In CVPR, pages 652–660, 2017. 1, 2, 7

[23] Charles Ruizhongtai Qi, Li Yi, Hao Su, and Leonidas J Guibas. PointNet++: Deep Hierarchical Feature Learning on Point Sets in a Metric Space. In NeurIPS, pages 5099–5108, 2017. 1, 2, 4

[24] Shaoshuai Shi, Chaoxu Guo, Li Jiang, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. PV-RCNN: Point-Voxel Feature Set Abstraction for 3D Object Detection. In CVPR, pages 10529–10538, 2020. 1, 2, 8

[25] Shaoshuai Shi, Xiaogang Wang, and Hongsheng Li. PointRCNN: 3D Object Proposal Generation and Detection from Point Cloud. In CVPR, pages 770–779, 2019. 1, 2

[26] Shaoshuai Shi, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. From Points to Parts: 3D Object Detection from Point Cloud with Part-aware and Part-aggregation Network. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020. 8

[27] Bharat Singh and Larry S Davis. An Analysis of Scale Invariance in Object Detection - SNIP. In CVPR, pages 3578–3587, 2018. 2

[28] Bharat Singh, Mahyar Najibi, and Larry S Davis. SNIPER: Efficient Multi-Scale Training. In NeurIPS, pages 9310–9320, 2018. 2

[29] Pei Sun, Henrik Kretzschmar, Xerxes Dotiwalla, Aurelien Chouard, Vijaysai Patnaik, Paul Tsui, James Guo, Yin Zhou, Yuning Chai, Benjamin Caine, et al. Scalability in Perception for Autonomous Driving: Waymo Open Dataset. In CVPR, pages 2446–2454, 2020. 2, 3

[30] Hugues Thomas, Charles R Qi, Jean-Emmanuel Deschaud, Beatriz Marcotegui, Franc¸ois Goulette, and Leonidas J Guibas. KPConv: Flexible and deformable convolution for point clouds. In ICCV, pages 6411–6420, 2019. 1, 4, 7

[31] Shenlong Wang, Simon Suo, Wei-Chiu Ma, Andrei Pokrovsky, and Raquel Urtasun. Deep parametric continuous convolutional neural networks. In CVPR, pages 2589–2597, 2018. 1, 4, 7

[32] Yan Wang, Wei-Lun Chao, Divyansh Garg, Bharath Hariharan, Mark Campbell, and Kilian Q Weinberger. Pseudo-LiDAR from Visual Depth Estimation: Bridging the Gap in 3D Object Detection for Autonomous Driving. In CVPR, pages 8445–8453, 2019. 2

[33] Yue Wang, Alireza Fathi, Abhijit Kundu, David Ross, Caroline Pantofaru, Tom Funkhouser, and Justin Solomon. Pillarbased Object Detection for Autonomous Driving. In ECCV, 2020. 1, 8

[34] Yue Wang, Yongbin Sun, Ziwei Liu, Sanjay E Sarma, Michael M Bronstein, and Justin M Solomon. Dynamic graph cnn for learning on point clouds. Acm Transactions On Graphics (tog), 38(5):1–12, 2019. 1, 7

[35] Wenxuan Wu, Zhongang Qi, and Li Fuxin. PointConv: Deep convolutional networks on 3d point clouds. In CVPR, pages 9621–9630, 2019. 1, 4, 7

[36] Chenfeng Xu, Bichen Wu, Zining Wang, Wei Zhan, Peter Vajda, Kurt Keutzer, and Masayoshi Tomizuka. SqueezeSegV3: Spatially-Adaptive Convolution for Efficient PointCloud Segmentation. arXiv preprint arXiv:2004.01803, 2020. 1

[37] Yan Yan, Yuxing Mao, and Bo Li. SECOND: Sparsely Embedded Convolutional Detection. Sensors, 18(10):3337, 2018. 1, 2, 5, 8

[38] Bin Yang, Wenjie Luo, and Raquel Urtasun. PIXOR: Realtime 3D Object Detection from Point Clouds. In CVPR, pages 7652–7660, 2018. 1, 2

[39] Zetong Yang, Yanan Sun, Shu Liu, Xiaoyong Shen, and Jiaya Jia. IPOD: Intensive Point-based Object Detector for Point Cloud. arXiv preprint arXiv:1812.05276, 2018. 2

[40] Zetong Yang, Yanan Sun, Shu Liu, Xiaoyong Shen, and Jiaya Jia. STD: Sparse-to-Dense 3D Object Detector for Point Cloud. In ICCV, pages 1951–1960, 2019. 2

[41] Haoyang Zhang, Ying Wang, Feras Dayoub, and Niko S¨underhauf. VarifocalNet: An IoU-aware Dense Object Detector. arXiv preprint arXiv:2008.13367, 2020. 5

[42] Yang Zhang, Zixiang Zhou, Philip David, Xiangyu Yue, Zerong Xi, Boqing Gong, and Hassan Foroosh. PolarNet: An Improved Grid Representation for Online LiDAR Point Clouds Semantic Segmentation. In CVPR, pages 9601–9610, 2020. 1

[43] Hui Zhou, Xinge Zhu, Xiao Song, Yuexin Ma, Zhe Wang, Hongsheng Li, and Dahua Lin. Cylinder3D: An Effective 3D Framework for Driving-scene LiDAR Semantic Segmentation. arXiv preprint arXiv:2008.01550, 2020. 1

[44] Yin Zhou, Pei Sun, Yu Zhang, Dragomir Anguelov, Jiyang Gao, Tom Ouyang, James Guo, Jiquan Ngiam, and Vijay Vasudevan. End-to-End Multi-View Fusion for 3D Object Detection in LiDAR Point Clouds. In CoRL, pages 923–932, 2020. 1, 2, 8

[45] Yin Zhou and Oncel Tuzel. VoxelNet: End-to-End Learning for Point Cloud Based 3D Object Detection. In CVPR, pages 4490–4499, 2018. 2文章来源地址https://www.toymoban.com/news/detail-529912.html

到了这里,关于点云 3D 目标检测 - RangeDet(ICCV 2021)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]PillarNeXt——基于LiDAR点云的3D目标检测网络设计](https://imgs.yssmx.com/Uploads/2024/02/715798-1.png)

![[论文阅读]MVF——基于 LiDAR 点云的 3D 目标检测的端到端多视图融合](https://imgs.yssmx.com/Uploads/2024/01/817020-1.png)