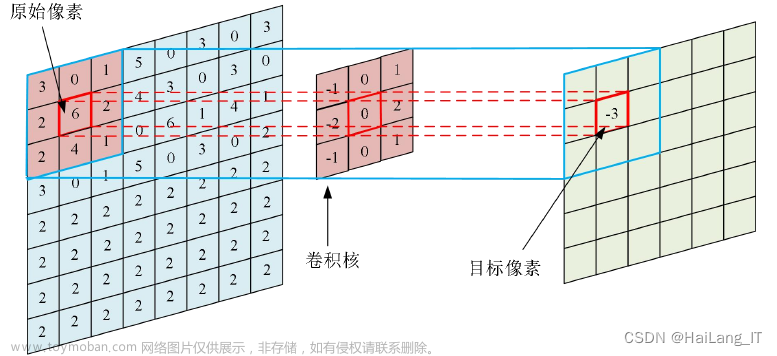

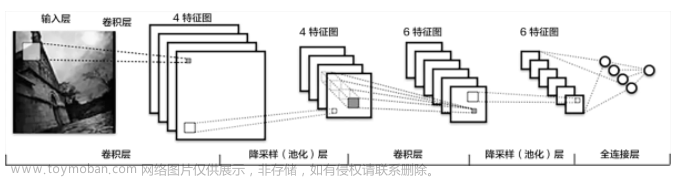

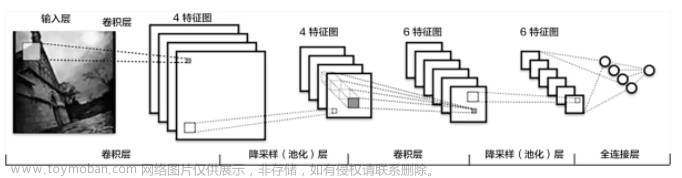

神经网络算法是一种基于人工神经网络的机器学习算法。它的灵感来源于生物神经系统,能够通过学习大量数据来识别模式和关系,并进行分类、回归、聚类等任务。

神经网络算法通常由多个层次组成,每个层次包含多个神经元。这些神经元之间通过不同的权重相互连接,通过输入数据来进行计算,最终输出结果。在训练过程中,神经网络会自动调整权重,使得模型能够更好地拟合数据。

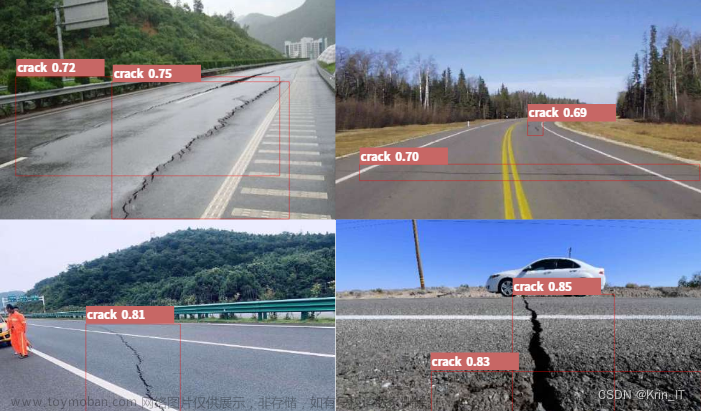

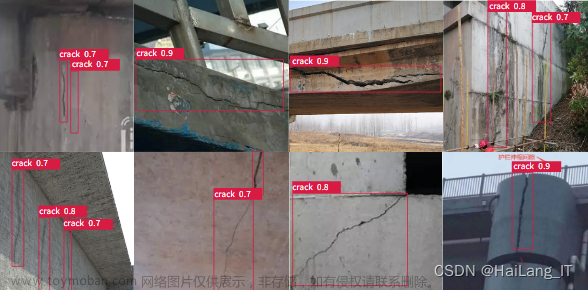

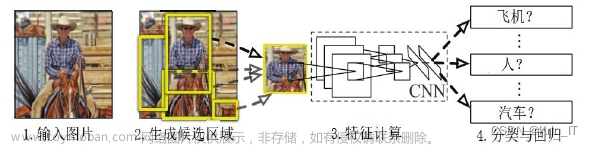

神经网络算法在图像识别、语音识别、自然语言处理等领域有广泛的应用。虽然神经网络算法在某些情况下表现出色,但也存在一些问题,例如需要大量的数据来训练、模型参数较多等。

以下是使用Python和TensorFlow库编写一个简单的神经网络算法的示例代码:

import tensorflow as tf

# 创建输入数据

x = tf.placeholder(tf.float32, [None, 2])

y = tf.placeholder(tf.float32, [None, 1])

# 创建模型

w = tf.Variable(tf.zeros([2, 1]))

b = tf.Variable(tf.zeros([1]))

y_pred = tf.sigmoid(tf.matmul(x, w) + b)

# 定义损失函数和优化器

loss = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(logits=y_pred, labels=y))

optimizer = tf.train.GradientDescentOptimizer(0.5).minimize(loss)

# 训练模型

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

for i in range(1000):

batch_x, batch_y = generate_data()

sess.run(optimizer, feed_dict={x: batch_x, y: batch_y})

# 测试模型

test_x, test_y = generate_data()

y_pred_val = sess.run(y_pred, feed_dict={x: test_x})

print('Accuracy:', accuracy(test_y, y_pred_val))在上面的代码中,我们首先创建了输入数据的占位符x和y,表示输入数据和对应的标签。然后,我们定义了模型的权重w和偏置b,并根据输入数据计算预测值y_pred。接着,我们定义了损失函数和优化器,并在循环中进行训练。最后,我们使用测试数据来评估模型的准确率。

需要注意的是,上述代码中的generate_data()和accuracy()函数并未给出,这是因为这些函数的实现与具体的任务相关,可以根据实际情况进行编写。

generate_data()函数是用来生成训练数据和测试数据的函数。具体实现需要根据任务的具体要求来决定,以下是一个示例:

import numpy as np

def generate_data(n_samples=1000):

# 生成n_samples个样本

x = np.random.uniform(low=-1, high=1, size=(n_samples, 2))

y = (x[:, 0] * x[:, 1] > 0).astype(int).reshape(-1, 1)

return x, y上述代码中,我们生成了n_samples个样本,每个样本包含2个特征。我们根据这两个特征的乘积是否大于0来决定样本的标签。这里我们使用了NumPy库来生成随机数据和对数据进行处理。

accuracy()函数用来评估模型的准确率,具体实现也需要根据任务的要求来决定。以下是一个示例:文章来源:https://www.toymoban.com/news/detail-530044.html

def accuracy(y_true, y_pred):

y_true = np.argmax(y_true, axis=1)

y_pred = np.argmax(y_pred, axis=1)

return np.mean(y_true == y_pred)上述代码中,我们将标签转换为one-hot编码,然后比较预测值和真实值的索引是否相同,最终计算准确率。这里我们同样使用了NumPy库来进行计算。需要注意的是,上述代码适用于多分类任务,如果是二分类任务或者回归任务,需要根据具体情况进行修改。文章来源地址https://www.toymoban.com/news/detail-530044.html

到了这里,关于深度学习神经网络的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!