毫无疑问,Vision Pro在眼球追踪+手势的融合交互体验上,给AR/VR头戴设备带来了新突破,在用户体验上的提升非常明显。

那么,为什么Vision Pro上这一功能会被如此值得关注呢?为了弄清楚,我们先来看看主流VR设备是如何做的。

主流VR和Vision Pro的差异

在此之前,很多主流AR/VR产品已经采用这两种技术方案,只不过并未把两种交互方式融合,这其中有几点原因:

1,手势方面,包括Quest等主流VR设备以手柄交互体验为主,手势追踪仅作为补充式体验,即便从功能层面可以替代大部分手柄上的按键和功能。

而Vision Pro没有手柄,首选方式是通过眼球追踪+手势来完成,当然也提供了辅助功能(含手势射线模式)。

2,主流VR的手势追踪必须将手放在摄像头FOV范围内,使用时双手必须微抬或举在身体前面,时间一长就非常累,导致用户体验差。

而Vision Pro则拥有6颗SLAM+手势摄像头,其中有两颗向下的摄像头专门捕捉手垂放在腿上的视角。另外,还有两颗斜向下的摄像头同时兼顾SLAM和手势。甚至为了弱光环境下手势识别准确性,苹果还加入了两颗红外LED进行辅助。

这种垂直视角的摄像头,专门用于捕捉大部分时间、不抬手的时候的手势,因为很多时候双手应该自然垂放在腿或桌子上,符合人体工学逻辑。苹果Vision Pro是AR/VR中的首家采用这一方案的设备,更是独一份。

Vision Pro 直接手势

因为苹果在开发文档中也提到,如果使用直接手势(双手直接触碰虚拟物体,比如虚拟键盘等),需要将双手抬起至头显透镜FOV的视野之内,尽管它的捕捉摄像头范围够广,必须让双手在FOV可见范围内才行。而多次/频繁的直接手势操作会带来疲劳感,应尽量避免。

3,眼球追踪方面,主流VR设备更注重VR应用内的场景,比如VR游戏凝视交互、Avatar眼球动作等,甚至也可以用于注视点渲染提升帧率等,确实提升了游戏体验。

凝视的高光变化

Vision Pro凝视+手势捏合

而Vision Pro采用的visionOS系统底层逻辑是大量2D窗口交互,包括文字选中、菜单选择都可以通过眼球+手势来完成,这其中眼球+手势融合交互就非常重要。当然,PS VR2部分游戏也提供眼球凝视菜单选项,体验尚可。

4,产品定位和价格方面的因素。VR一体机都是在主流价位去推广,通过SLAM摄像头同时完成头显定位和手柄追踪以及手势追踪,因此SLAM摄像头的安装角度主要照顾了头显的定位,而非手势追踪的体验。

这也就导致了,包括Quest等VR设备上通过斜向下的摄像头同时来捕捉手势,而双手放在腿部或靠下时完全不在捕捉范围。

而Vision Pro高举高打,不在乎售价意在通过高规格硬件提供高规格的体验。

当然,这里面还没有提到Vision Pro专门为摄像头、传感器准备的R1芯片,就是为了低延迟处理这些视觉数据,从而实现更精准交互方案,可以说Vision Pro的交互逻辑从软件、硬件、芯片、算法等多方位于一体,是一个鸿沟式的差异。

二、眼球+手势和纯手势对比

由上文得知,Vision Pro和之前的VR交互方式上存在较大差异。那么,两种交互方式又带来了哪些差异呢?

据青亭网了解,今年4月19日在ACM公布的一份论文“A Fitts' Law Study of Gaze-Hand Alignment for Selection in 3D User Interfaces”中,就明确提到了凝视+捏合的交互类型,并且对手势射线的供5种交互方式进行对比。

该论文第一作者Uta Wagner来自于由丹麦奥胡斯大学计算机科学系,这里我们将其中的2类代表“仅基于手势射线”和“基于凝视射线+手势捏合”的测试差异进行对比。

2-1,选择目标测试

该研究基于菲茨定律研究进行设计,在FOV内不同深度呈现目标来进行“选择目标测试”,如上图,得出的结果是:

- 吞吐量:凝视射线+捏合(2.1bits)>手势射线(1.4bits);

- 错误率:无明显差异;

- 物理消耗:凝视射线+捏合(2)>手势射线(4)。

2-2,AR菜单激活和选择测试

在进行AR菜单激活和选择测试中,得出的结果是:

- 速度:凝视射线+捏合(2.5s)>手势射线(4.6s);

- 错误:手势射线(1%)>凝视射线+捏合(3%);

- 测试人员的喜好:凝视射线+捏合(6/16)>手势射线(0/16)。

论文中所有测试方案

基于本论文的研究,得出的结论还有:

- 1,所有测试方案中,结合凝视的方案在效率更高、速度更快,始终比手势射线表现更优秀;

- 2,论文中提出的凝视射线+手势射线融合方案性能和其它相当,也比较受测试者欢迎,仅次于凝视射线+捏合;

- 3,视察因素对平面图像中交互更为不利。

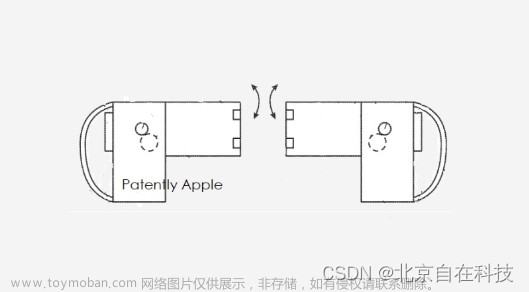

综上所述,基于凝视射线+捏合(苹果Vision Pro的方案,只不过它隐藏了凝视射线,但在UI中结合了高光等进行提示)在速度、效率上更高,也最受欢迎。同时,也表明凝视+手势结合的交互方式在今后AR/VR交互中更具潜力。不过要说的体感反馈,当然还是现在的手柄在体验和成本方面优势明显,今后在无手持设备的凝视+手势交互时代,智能手环或智能戒指也有望成为体感反馈的重要工具。文章来源:https://www.toymoban.com/news/detail-530102.html

参考:Apple、ACM文章来源地址https://www.toymoban.com/news/detail-530102.html

到了这里,关于苹果Vision Pro手势+眼球融合交互的奥秘的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!