ReLU (Rectified Linear Unit) 是一种常用的激活函数,其定义为 f ( x ) = max ( 0 , x ) f(x) = \max(0, x) f(x)=max(0,x)。它的作用是将输入值限制在非负范围内,并且在正半轴上具有线性性质。ReLU 激活函数在深度学习中应用广泛,主要有以下几个作用:文章来源地址https://www.toymoban.com/news/detail-531203.html

- 增强模型非线性能力:ReLU 可以在神经网络中引入非线性,使得模型可以更好地拟合非线性函数。

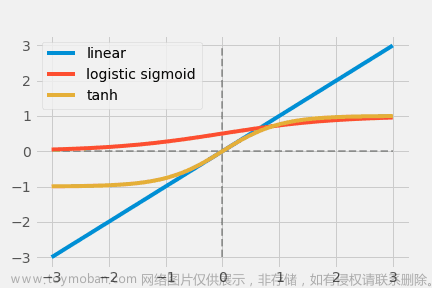

- 加速模型训练:相比于其他激活函数,如 sigmoid 和 tanh,ReLU 的导数在正半轴上恒为 1,不会出现梯度消失的情况,从而加速了模型的训练过程。

- 提高模型稀疏性:由于 ReLU 在负半轴上的输出都为零,因此可以使得神经网络中的一些神经元变得不活跃,从而提高模型的稀疏性。

- 减少模型参数:在使用 ReLU 激活函数时,可以将参数矩阵的负值部分直接设为零,从而减少了模型参数的数量。

总之,ReLU 激活函数是深度学习中一种非常重要的激活函数,它的简单性、计算效率和性能表现在很多场景下都表现出色。

文章来源:https://www.toymoban.com/news/detail-531203.html

到了这里,关于relu函数的作用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!