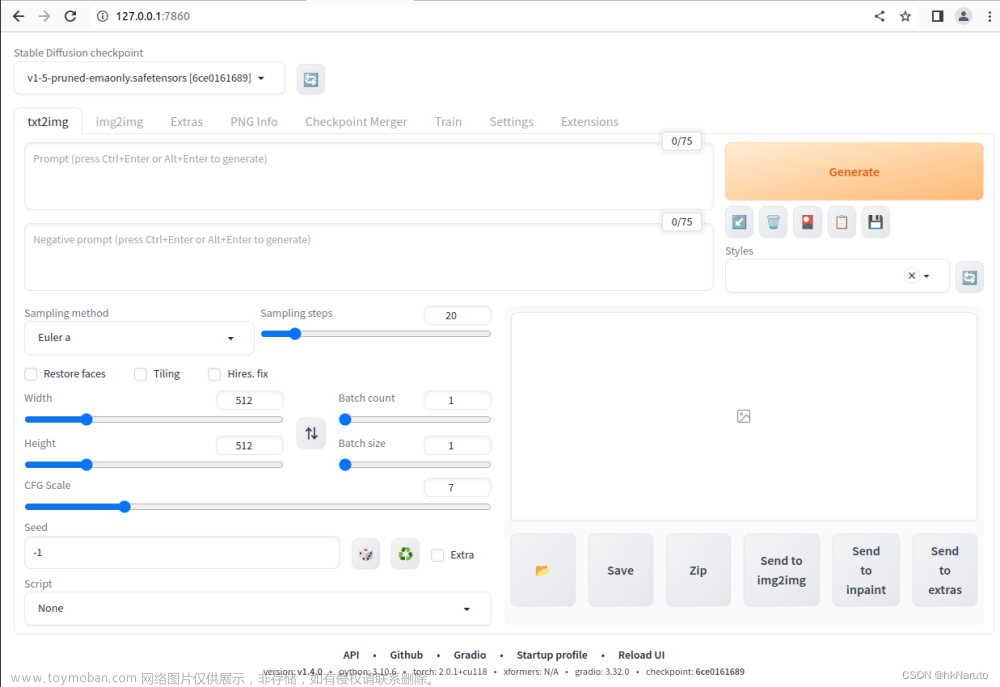

模型

默认选中

chilloutmix_Ni.safetensors,重启webui.sh进程

正向词

best quality, ultra high res, (photorealistic:1.4), 1girl, <lora:koreanDollLikeness_v15:1> ,<lora:yaeMikoRealistic_yaemikoMixed:1>,反向词

paintings, sketches, (worst quality:2),(low quality:2),(normal quality:2), lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, age spot, glans,{{{bad_hands}}},badhand, bad_feet,其他

出图

文章来源:https://www.toymoban.com/news/detail-533726.html

文章来源:https://www.toymoban.com/news/detail-533726.html

显卡还能剩余不到200M。文章来源地址https://www.toymoban.com/news/detail-533726.html

到了这里,关于Stable Diffusion WebUI Ubuntu 22.04 LTS RTX2060 6G 极限显存出图的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!