1、检查pytorch的版本

import torch

print(torch.__version__)2、检查cuda的版本(pytorch所用的cuda版本)

首先确认本机gpu可用

import torch

print(torch.cuda.is_available())

print(torch.cuda.device_count()) # 查看gpu的数目

print(torch.cuda.get_device_name(0) # 基于序号获取gpu的名称,设备默认编号从0开始然后,查看所用cuda版本,有两个版本需要查看:

-

版本1:pytorch运行时真正用的版本,即安装的cuda_toolkit版本。

cuda_toolkit各各版本下载地址:CUDA Toolkit Archive | NVIDIA Developer

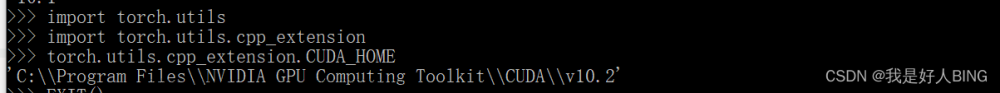

import torch

import torch.utils.cpp_extension

torch.utils.cpp_extension.CUDA_HOME -

版本2:pytorch支持的cuda版本,比如torch+cuda102等,即编译该 Pytorch release 版本时使用的 cuda 版本。

import torch

torch.version.cuda通过两种方式查看得到的cuda版本,正常来讲应该保持一致。

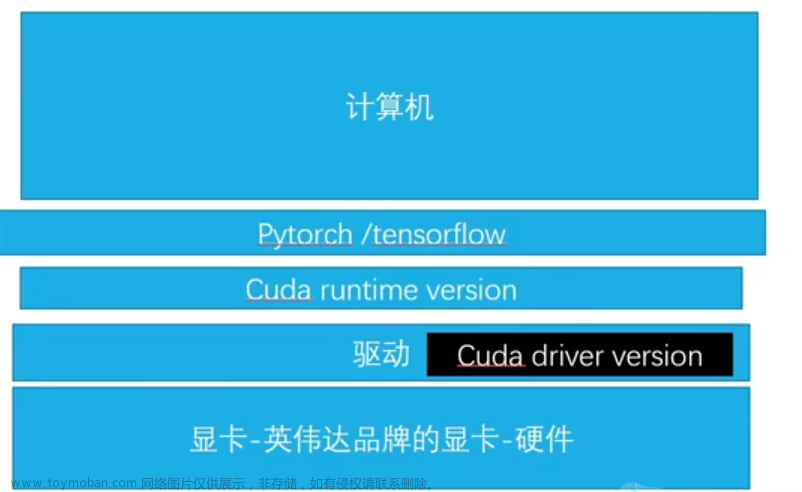

注意:还有一个cuda版本,即gpu驱动程序(gpu dirver)支持的cuda版本(显卡驱动下载地址:官方驱动 | NVIDIA),可以在nvidia显卡管理面板查看,也可以通过nvidia-smi命令查看。此版本为驱动程序支持的最大cuda版本。理论上,无论是安装的cuda_toolkit版本还是pytorch的gpu版本,其cuda版本号都不能大于gpu dirver支持的版本。

3、查看cudnn版本

cudnn版本的查看比较特殊,需要进入cuda_toolkit安装目录下,找到cudnn.h头文件,打开后,在开始的地方,可以看到三个大写的变量及对应的数字,分别是Major_version,minor_version等,把三个数字拼在一起,即cudnn的版本。

4、讨论:cuda-toolkit是否必须安装?

查阅相关资料后,发现很多人在只安装了显卡驱动的情况下,就已经可以在pytorch中使用gpu来训练和推理,根本无需额外安装cuda-toolkit,但是nvcc是肯定不能用的。实际上,cuda-toolkit是用来进行gpu编程的,这不是意味着只是使用pytorch的话,由于torch已经是编译完的(已经可以运行),因此才会出现此种情况。文章来源:https://www.toymoban.com/news/detail-537430.html

至于是不是这样的的,大家可以自行尝试。文章来源地址https://www.toymoban.com/news/detail-537430.html

到了这里,关于如何检查pytorch版本以及cuda的版本的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!