本人三台节点:hadoop01,hadoop02,hadoop03(部署hive,mysql)

默认jdk,zookeeper,hadoop,hbase,kafka,flume,hue,spark已经安装

#一.zookeeper启动 (QuorumPeerMain)

1.启动zookeeper

启动:bin/zkServer.sh start (单台节点启动命令)

关闭:bin/zkServer.sh stop (单台节点关闭命令)

查看:bin/zkServer.sh status (单台节点查看命令)

2.启动zookeeper中shell的操作(启动zookeeper服务)

启动: bin/zkCli.sh

关闭: quit

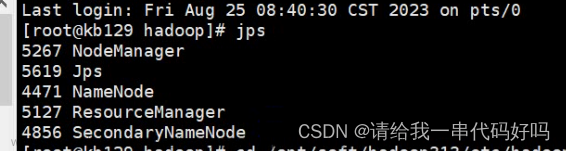

#二.hadoop启动

1.进入hadoop>sbin(这是用管理员的命令,里面存放在都是脚本)

启动脚本命令: ./start-all.sh hdfs和yarn都会启动 (此时会hadoop01会启动8个,但是haddoop02没有启动ResourceManager这不是bug漏洞)

接着启动hadoop02的ResourceManager: 命令 yarn-daemon.sh start resourcemanager (start)

yarn-daemon.sh stop resourcemanager (stop)

启动单个节点的namenode命令:sbin/hadoop-daemon.sh start namenode

2.启动hdfs (JournalNode,NameNode, DataNode, DFSZKFailoverController) (web访问 hadoop01:50070)

启动:sbin/start-dfs.sh

关闭:sbin/stop-dfs.sh

3.启动yarn (ResourceManager,NodeManager) (web访问 Hadoop01:8088)

启动:sbin/start-yarn.sh

关闭:sbin/stop-yarn.sh

#三.hbase启动 (HMaster HRegionServer) (仅依赖hdfs,hdfsHA依赖zookeeper 首先启动zookeeper,然后在启动sbin/start-dfs.sh)

(必须时间同步,不然hbase进程很容易挂掉)

启动:bin/start-hbase.sh (注意时间同步) (web访问 hadoop01:60010)

关闭:bin/stop-hbase.sh

进入: hbase shell

退出: exit#四.kafka启动 (kafka依赖zookeeper可以实现对kafka集群的管理) (每台kafka服务器都要启动)

启动:bin/kafka-server-start.sh config/server.properties & (加上&就是后台启动)

关闭:kill -9 进程号 或 ctrl+c

新api使用

消费者启动:bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test

生产者启动:bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

再打开一个消费者如果从头开始消费:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test (--from-beginning)

查看topic列表

bin/kafka-topics.sh --zookeeper localhost:2181/kafka1.0 --list

#五.flume启动

启动:bin/flume-ng agent -n agent -c conf -f conf/flume-conf2.properties -Dflume.root.logger=INFO,console (hadoop01)

bin/flume-ng agent -n agent -c conf -f conf/flume-conf.properties -Dflume.root.logger=INFO,console (hadoop02)

bin/flume-ng agent -n agent -c conf -f conf/flume-conf.properties -Dflume.root.logger=INFO,console (hadoop03)

关闭:kill -9 进程号 或 ctrl+c#六.hive启动 (启动之前要开启mysql服务,依赖zookeeper,hadoop中HDFS Yarn)

启动mysql服务 (hadoop03中root用户启动mysql服务) 查看:service mysqld status

启动:service mysqld start

关闭:service mysqld stop

问题:linux下mysql中文乱码?

永久解决:1.:首先用命令进入到vim /etc/my.cnf,(可能有的没有这个文件打开是空的,可以直接添加下面的语句

如果root用户/etc/my.cnf有这个文件的话那就修改下面的这些语句:

[client]

default-character-set=utf8

[mysql]

default-character-set=utf8

[mysqld]

init_connect='SET collation_connection = utf8_unicode_ci'

init_connect='SET NAMES utf8'

character-set-server=utf8

collation-server=utf8_unicode_ci

skip-character-set-client-handshake

2.重启mysql服务:service mysql restart

3.:进入mysql 用命令查看一下几个地方是不是变成了utf8,命令是:show variables like "%char%";

hadoop03节点启动mysql

启动:mysql -u hive -h hadoop03 -p (密码是hive)

退出:exit; 或者 ctrl+c

说明:启动hive

启动:bin/hive

关闭 exit; 或者 ctrl+c

Hive Web 界面的启动命令:bin/hive --service hwi (必须先启动hive,进入hive界面)

通过浏览器访问 Hive,默认端口为 9999。 (http://hadoop03:9999/hwi/)

#七.hue启动 (访问地址:hadoop03:8888 )

文章来源:https://www.toymoban.com/news/detail-540973.html

启动命令:/home/hadoop/app/hue-3.9.0-cdh5.10.0/build/env/bin/supervisor

#八,spark启动

文章来源地址https://www.toymoban.com/news/detail-540973.html

启动: 在主节点执行以下命令

sbin/start-all.sh

再选择一个节点作为master启动,执行命令如下

sbin/start-master.sh

sbin/stop-master.sh

查看主节点web界面

http://hadoop01:8888/到了这里,关于hadoop常用的启动命令的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!