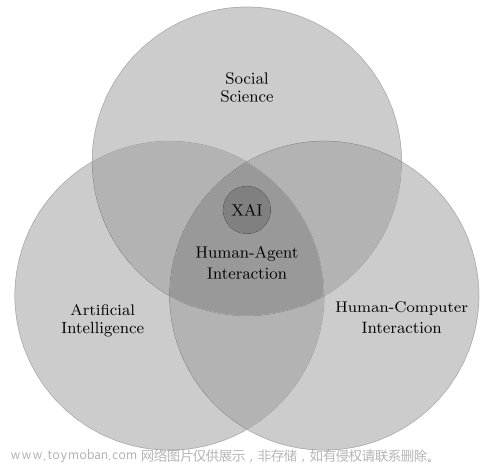

模型解释性是指能够理解和解释机器学习模型如何做出预测或决策的能力。以下是一些机器学习中模型解释性问题的例子:

-

医疗诊断:在医疗诊断领域,模型解释性非常重要。例如,当使用深度学习模型进行肿瘤诊断时,医生需要知道模型是基于哪些特征或区域进行预测,以便理解和验证模型的推理过程。解释性模型或者可视化方法可以帮助医生解释模型的预测结果。

-

金融风险评估:在金融风险评估中,了解模型是如何根据借款人的特征(如收入、信用历史等)进行信用评估和风险预测是非常重要的。模型解释性可以帮助银行或金融机构解释模型预测的原因,向借款人提供透明度,并确保决策的可解释性。

-

自动驾驶:在自动驾驶领域,解释性模型可以帮助人们理解自动驾驶汽车是如何进行决策和预测的。例如,当自动驾驶汽车决定刹车或转弯时,了解模型是如何分析感知数据、识别障碍物并作出决策,对于确保安全性和可靠性至关重要。

-

法律与合规:在涉及法律与合规领域的机器学习应用中,解释性模型可以帮助解释模型的预测和决策,并提供合理化的依据。例如,在审判预测中,解释性模型可以帮助律师和法官理解模型对案件结果的影响因素,从而使决策过程更加透明和可解释。

-

市场预测:在金融和投资领域,模型解释性可以帮助解释模型对市场趋势和股票价格的预测依据。投资者和交易员可以通过了解模型对市场因素的敏感性和权重,做出更明智的投资决策。

这些例子强调了在特定领域中需要模型解释性的重要性。模型解释性可以通过使用可解释性模型(如决策树、逻辑回归)、特征重要性分析、局部解释等技术来实现。

1、使用可解释性模型对应模型解释性问题

以下是一个示例代码,展示如何使用决策树作为可解释性模型来解决模型解释性问题:

# 导入所需的库

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn import tree

# 加载鸢尾花数据集

data = load_iris()

X = data.data

y = data.target

# 创建决策树分类器

model = DecisionTreeClassifier()

model.fit(X, y)

# 可视化决策树

tree.plot_tree(model)

上述代码使用了Scikit-learn库中的DecisionTreeClassifier类来创建决策树分类器,并使用fit方法对模型进行训练。然后,使用tree.plot_tree函数将决策树可视化输出。

该可视化展示了决策树的节点和分支,可以帮助我们理解模型是如何根据特征进行决策和预测的。每个节点表示一个特征和对应的分割点,分支表示模型基于该特征的取值进行的判断。叶节点表示最终的预测结果或类别。

通过分析决策树的结构和路径,可以获得关于模型预测的解释信息。例如,在鸢尾花数据集中,决策树可以告诉我们哪些特征对于区分不同类别的鸢尾花起到了重要作用。

这样的可解释性模型可以帮助我们理解模型的决策过程,并向利益相关者提供可解释的预测结果。根据具体的问题和数据集,我们可以选择不同的可解释性模型,如决策树、逻辑回归等,来满足解释性的需求。

2、通过使用特征重要性分析对应模型解释性问题

以下是一个示例代码,展示如何使用随机森林模型进行特征重要性分析来解决模型解释性问题:

# 导入所需的库

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn import tree

# 加载鸢尾花数据集

data = load_iris()

X = data.data

y = data.target

# 创建决策树分类器

model = DecisionTreeClassifier()

model.fit(X, y)

# 可视化决策树

tree.plot_tree(model)

上述代码使用了Scikit-learn库中的RandomForestClassifier类来创建随机森林分类器,并使用fit方法对模型进行训练。然后,使用feature_importances_属性获取特征重要性。

接下来,通过使用Matplotlib库绘制了一个柱状图,横轴表示特征,纵轴表示特征重要性。柱状图的高度表示特征的重要性程度。通过观察柱状图,可以了解到哪些特征对模型的预测结果具有更大的影响。

在鸢尾花数据集中,特征重要性分析可以帮助我们了解哪些特征对于区分不同类别的鸢尾花起到了重要作用。通过分析特征重要性,可以得出关于模型预测的解释信息,例如哪些特征对于某个类别的判断更为关键。

这样的特征重要性分析可以帮助我们解释模型是如何根据输入特征进行决策和预测的,以及了解不同特征对模型的贡献程度。根据具体的问题和数据集,我们可以使用不同的模型,如随机森林、梯度提升树等,来进行特征重要性分析。

3、通过使用特征重要性分析对应模型解释性问题

局部解释性可以通过使用LIME(Local Interpretable Model-agnostic Explanations)等技术来实现。下面是一个示例代码,展示如何使用LIME来进行局部解释:

# 导入所需的库

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from lime import lime_tabular

# 加载鸢尾花数据集

data = load_iris()

X = data.data

y = data.target

feature_names = data.feature_names

# 创建随机森林分类器

model = RandomForestClassifier()

model.fit(X, y)

# 创建LIME解释器

explainer = lime_tabular.LimeTabularExplainer(X, feature_names=feature_names, class_names=data.target_names)

# 选择一个样本进行解释

sample_index = 0

sample = X[sample_index]

# 解释模型预测

explanation = explainer.explain_instance(sample, model.predict_proba)

# 打印解释结果

explanation.show_in_notebook()

上述代码使用了Scikit-learn库中的RandomForestClassifier类来创建随机森林分类器,并使用fit方法对模型进行训练。然后,使用lime_tabular.LimeTabularExplainer类创建了一个LIME解释器。

接下来,选择一个样本进行解释,这里选择了第一个样本。通过调用explain_instance方法并传入样本和模型的predict_proba函数,可以获取对样本预测的解释。

最后,调用show_in_notebook方法将解释结果可视化。解释结果可以显示特征的权重和对模型预测的影响程度。

使用LIME进行局部解释可以帮助我们理解模型在单个样本上的决策过程。LIME通过生成局部可解释的模型来解释模型的预测结果,并为每个特征提供权重,以显示其对预测的贡献程度。文章来源:https://www.toymoban.com/news/detail-541658.html

注意,上述代码中的lime库是基于Python的LIME实现,需要使用lime库的正确版本,并确保已正确安装该库。文章来源地址https://www.toymoban.com/news/detail-541658.html

到了这里,关于机器学习中模型解释性问题笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!