背景

背景:所有的原始数据均存储在mysql,mysql会通过binlog将数据同步至kafka消息队列,但是有人将mysql中的数据进行删除(大概有2、3年的数据),被删除的数据也通过binlog被同步至消息队列里导致大量消息积压,且该消息队列只有3个分区,最多3个线程消费,消费方即使过滤也远远赶不上生产的数据,导致大量消息积压,导致消费该kafka的服务功能几乎不可用。

解决方案

方案1:删除的数据不向kafka中生产。

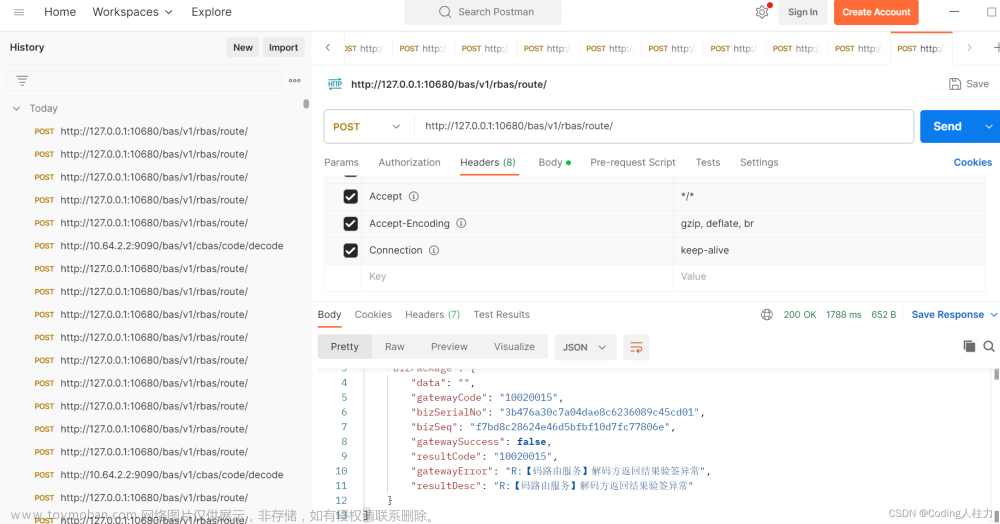

方案2:mysql的删除操作为持续操作一直在进行,被删除的数据一直在向kafka中生产,即使重置offset也无法解决问题。等数据删除完毕后再重置offset。文章来源:https://www.toymoban.com/news/detail-542393.html

重置kafka的offset

但是重置offset需要先关闭消费组消费,最好kill 掉,或者重新换个消费组。这是为啥呢?

比如,当前生产者的offset为1000,消费者的offset为100,此时想要直接消费offset为1000的数据,然后修改消费者端的offset为1000,然后消费者提交了1000,但是消费者还在继续消费啊,下次消费完就又向生产者提交了自己的offset101了,于是就又消费了老的数据。所以解决方法可以直接kill掉这个进程,然后重新设置offset再提交就可以了。文章来源地址https://www.toymoban.com/news/detail-542393.html

到了这里,关于记一次线上kafka造成的事故的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!