Diffusion Models专栏文章汇总:入门与实战

前言:DALL·E 2、imagen、GLIDE是最著名的三个text-to-image的扩散模型,是diffusion models第一个火出圈的任务。这篇博客将会详细解读DALL·E 2《Hierarchical Text-Conditional Image Generation with CLIP Latents》的原理。

目录

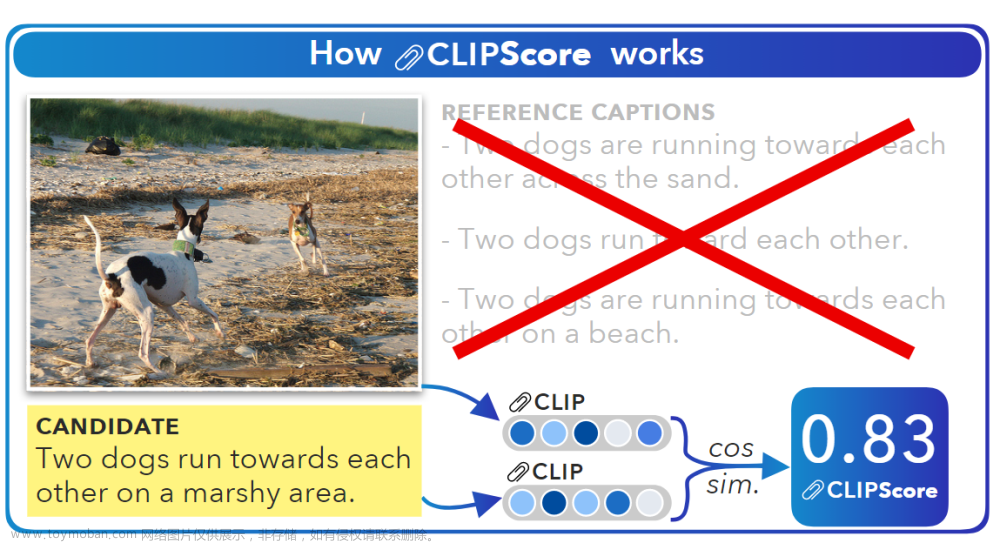

背景知识:CLIP简介文章来源:https://www.toymoban.com/news/detail-544802.html

方法概述文章来源地址https://www.toymoban.com/news/detail-544802.html

到了这里,关于Text-to-Image with Diffusion models的巅峰之作:深入解读 DALL·E 2的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[PMLR 2021] Zero-Shot Text-to-Image Generation:零样本文本到图像生成](https://imgs.yssmx.com/Uploads/2024/02/515786-1.png)