样本不平衡问题在机器学习中是一个常见的挑战,下面是一些样本不平衡问题的例子:

-

欺诈检测:在银行或电商领域的欺诈检测中,正常交易的数量通常远远多于欺诈交易的数量。这导致了一个类别(欺诈交易)的样本数量较少,而另一个类别(正常交易)的样本数量较多。这种样本不平衡会导致模型倾向于预测大多数样本属于正常交易,从而忽略了欺诈交易的识别。

-

疾病诊断:在医学领域的疾病诊断中,某些罕见病的发生率相对较低,而正常或常见病的样本数量更多。这导致了一个类别(罕见病)的样本数量较少,而另一个类别(正常或常见病)的样本数量较多。样本不平衡可能导致模型在罕见病的识别方面表现不佳。

-

文本分类:在文本分类任务中,某些类别的样本数量可能远远少于其他类别。例如,在垃圾邮件分类中,垃圾邮件的数量通常较少,而正常邮件的数量较多。这种样本不平衡可能导致模型对垃圾邮件的分类效果不佳。

解决样本不平衡问题的方法包括:

1、欠采样:从多数类别中删除一些样本,使其与少数类别的样本数量相近。这可能会导致信息丢失,并且忽略了多数类别的一部分样本。

下面是一个示例代码,展示如何使用欠采样方法(随机欠采样)来解决机器学习中的样本不平衡问题:

# 导入所需的库

import pandas as pd

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from imblearn.under_sampling import RandomUnderSampler

from collections import Counter

# 生成一个不平衡的示例数据集

X, y = make_classification(n_samples=1000, weights=[0.95, 0.05], random_state=42)

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 使用欠采样进行数据平衡

undersampler = RandomUnderSampler(random_state=42)

X_train_resampled, y_train_resampled = undersampler.fit_resample(X_train, y_train)

# 打印平衡后的样本数量

print('平衡后的样本数量:', Counter(y_train_resampled))

# 在平衡数据上训练和评估模型

# ...(在这里添加你的模型训练和评估代码)

上述代码使用了make_classification函数生成一个不平衡的示例数据集,其中正样本的比例为5%,负样本的比例为95%。然后,使用train_test_split函数将数据集划分为训练集和测试集。

接下来,使用RandomUnderSampler类进行随机欠采样。通过调用fit_resample方法,将训练集的特征X_train和标签y_train作为输入,得到欠采样后的平衡训练集X_train_resampled和y_train_resampled。

最后,通过Counter函数统计欠采样后训练集中每个类别的样本数量,并打印出来以验证数据的平衡性。

在实际应用中,你可以根据具体情况选择不同的欠采样方法和参数。除了随机欠采样外,还有其他的欠采样方法,如集中欠采样(Centroid Undersampling)、TomekLinks等。你可以根据数据集的特点和问题需求选择适合的欠采样方法来解决样本不平衡问题。

2、过采样:通过复制或生成新的少数类别样本,使其与多数类别的样本数量相近。这可能导致模型对少数类别样本过度拟合,并且增加了数据集的复杂性。

下面是一个示例代码,展示如何使用过采样方法(随机过采样)来解决机器学习中的样本不平衡问题:

# 导入所需的库

import pandas as pd

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from imblearn.over_sampling import RandomOverSampler

from collections import Counter

# 生成一个不平衡的示例数据集

X, y = make_classification(n_samples=1000, weights=[0.95, 0.05], random_state=42)

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 使用过采样进行数据平衡

oversampler = RandomOverSampler(random_state=42)

X_train_resampled, y_train_resampled = oversampler.fit_resample(X_train, y_train)

# 打印平衡后的样本数量

print('平衡后的样本数量:', Counter(y_train_resampled))

# 在平衡数据上训练和评估模型

# ...(在这里添加你的模型训练和评估代码)

上述代码使用了make_classification函数生成一个不平衡的示例数据集,其中正样本的比例为5%,负样本的比例为95%。然后,使用train_test_split函数将数据集划分为训练集和测试集。

接下来,使用RandomOverSampler类进行随机过采样。通过调用fit_resample方法,将训练集的特征X_train和标签y_train作为输入,得到过采样后的平衡训练集X_train_resampled和y_train_resampled。

最后,通过Counter函数统计过采样后训练集中每个类别的样本数量,并打印出来以验证数据的平衡性。

在实际应用中,你可以根据具体情况选择不同的过采样方法和参数。除了随机过采样外,还有其他的过采样方法,如SMOTE(Synthetic Minority Over-sampling Technique)、ADASYN(Adaptive Synthetic Sampling)等。你可以根据数据集的特点和问题需求选择适合的过采样方法来解决样本不平衡问题。

3、合成样本:使用生成模型(如SMOTE)生成合成的少数类别样本,以增加其数量。这可以在一定程度上解决样本不平衡问题,并减少过拟合风险。

下面是一个示例代码,展示如何使用合成样本方法(SMOTE)来解决机器学习中的样本不平衡问题:

# 导入所需的库

import pandas as pd

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from imblearn.over_sampling import SMOTE

from collections import Counter

# 生成一个不平衡的示例数据集

X, y = make_classification(n_samples=1000, weights=[0.95, 0.05], random_state=42)

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 使用合成样本进行数据平衡

smote = SMOTE(random_state=42)

X_train_resampled, y_train_resampled = smote.fit_resample(X_train, y_train)

# 打印平衡后的样本数量

print('平衡后的样本数量:', Counter(y_train_resampled))

# 在平衡数据上训练和评估模型

# ...(在这里添加你的模型训练和评估代码)

上述代码使用了make_classification函数生成一个不平衡的示例数据集,其中正样本的比例为5%,负样本的比例为95%。然后,使用train_test_split函数将数据集划分为训练集和测试集。

接下来,使用SMOTE类进行合成样本生成。通过调用fit_resample方法,将训练集的特征X_train和标签y_train作为输入,得到合成样本后的平衡训练集X_train_resampled和y_train_resampled。

最后,通过Counter函数统计合成样本后训练集中每个类别的样本数量,并打印出来以验证数据的平衡性。

在实际应用中,你可以根据具体情况选择不同的合成样本方法和参数。除了SMOTE外,还有其他的合成样本方法,如ADASYN(Adaptive Synthetic Sampling)等。你可以根据数据集的特点和问题需求选择适合的合成样本方法来解决样本不平衡问题。

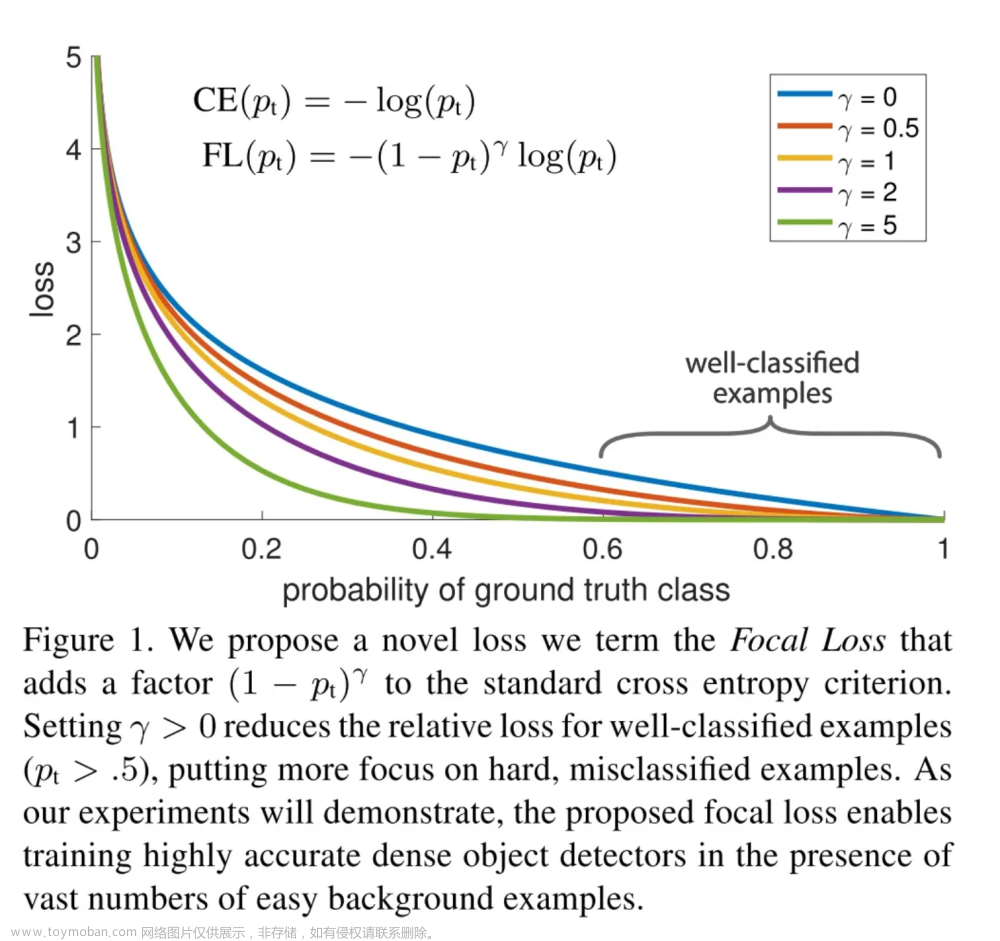

4、类别权重调整:调整损失函数中类别的权重,使得模型更加关注少数类别的正确分类。这可以平衡不同类别的重要性,但可能需要进行适当的权衡。

下面是一个示例代码,展示如何通过类别权重调整(class_weight)来解决机器学习中的样本不平衡问题:

# 导入所需的库

import pandas as pd

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

# 生成一个不平衡的示例数据集

X, y = make_classification(n_samples=1000, weights=[0.95, 0.05], random_state=42)

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定义类别权重字典

class_weights = {0: 1, 1: 10} # 调整类别0和类别1的权重

# 创建逻辑回归分类器,并设置类别权重

model = LogisticRegression(class_weight=class_weights)

# 在平衡数据上训练模型

model.fit(X_train, y_train)

# 在测试集上评估模型

accuracy = model.score(X_test, y_test)

print('模型在测试集上的准确率:', accuracy)

上述代码使用了make_classification函数生成一个不平衡的示例数据集,其中正样本的比例为5%,负样本的比例为95%。然后,使用train_test_split函数将数据集划分为训练集和测试集。

接下来,定义了一个类别权重字典class_weights,通过设置不同类别的权重来调整样本不平衡问题。在这个例子中,类别0的权重为1,类别1的权重为10。

然后,创建了一个逻辑回归分类器,并通过class_weight参数设置类别权重。

接下来,使用平衡后的训练集数据对模型进行训练,使用fit方法传入特征X_train和标签y_train。

最后,使用测试集数据评估模型的性能,使用score方法计算模型在测试集上的准确率,并打印出来。

通过调整类别权重,我们可以让模型更加关注少数类别,从而解决样本不平衡问题。根据实际情况,你可以根据问题需求设置不同的类别权重。文章来源:https://www.toymoban.com/news/detail-547691.html

这些方法可以根据具体问题和数据集的特点来选择和调整,以解决样本不平衡问题并提高模型性能。文章来源地址https://www.toymoban.com/news/detail-547691.html

到了这里,关于如何解决机器学习中样本不平衡问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!