一、科学上网要注意:

域名全代和全局代理(网卡),都要打开。这样conda install特别快。

二、安装langchain

1、

conda install langchain2、

conda install openai注意:

使用pip install和conda install 是不同的

二、简单运行一下文章来源:https://www.toymoban.com/news/detail-548428.html

from langchain.llms import OpenAI

from langchain.llms import OpenAI

from langchain.chat_models import ChatOpenAI

def main():

print("Hello, World!")

llm = OpenAI(openai_api_key="...")

print("Hello, World--OK!")

if __name__== "__main__" :

main() 文章来源地址https://www.toymoban.com/news/detail-548428.html

文章来源地址https://www.toymoban.com/news/detail-548428.html

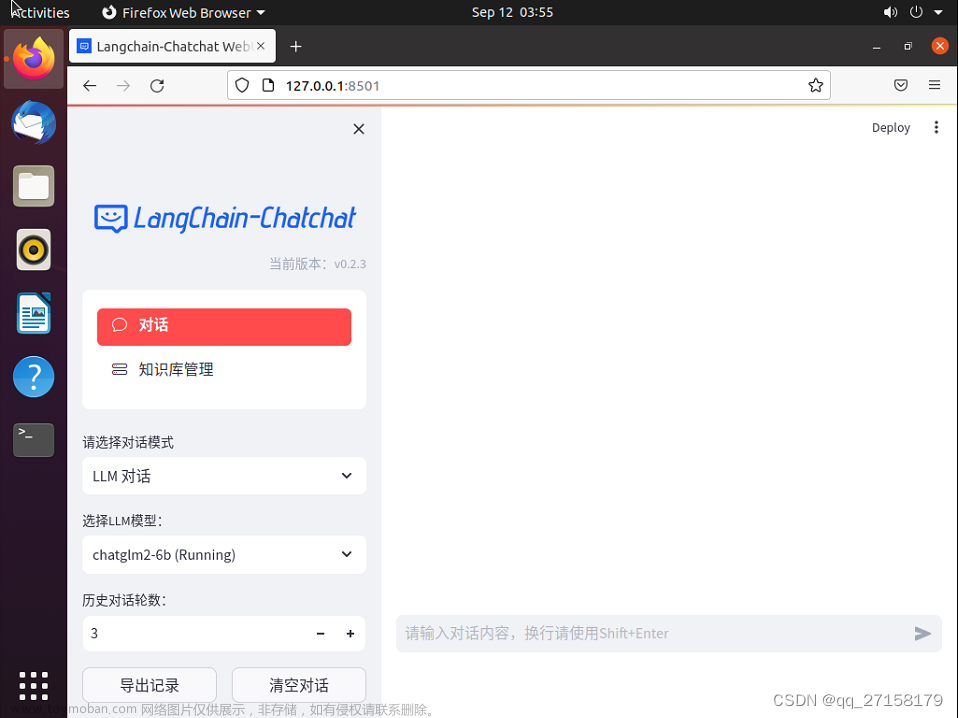

到了这里,关于langchain调用chatGLM2纪实的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!