Python爬虫步骤

Python爬虫主要用于从网页上获取数据,以下是一般的Python爬虫步骤:

1. 寻找目标网站:

确定你要爬取数据的目标网站。确保你有合法的权限和许可,不要违反网站的使用规定。

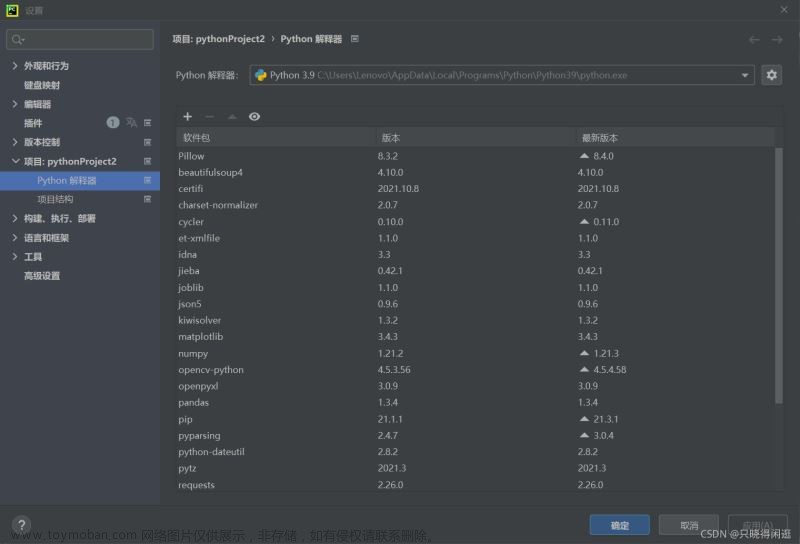

2. 安装所需库:

使用Python的pip工具,安装必要的库,如Requests、BeautifulSoup、Selenium等,这些库将帮助你发送网络请求、解析HTML内容等。

3. 发送网络请求:

使用Python的requests库,发送HTTP请求到目标网站,并获取网页的内容。你可以设置适当的请求头和参数以模拟浏览器行为。

4. 解析HTML内容:

使用解析库,如BeautifulSoup或lxml,解析获取到的网页内容,提取你所需要的数据。你可以通过标签、类名、ID等来定位和提取特定的元素。

5. 数据处理:

对爬取到的数据进行处理和清洗,如去除空格、过滤无用字符、转换数据格式等。

6. 存储数据:

将处理后的数据存储到合适的地方,如本地文件、数据库或云存储服务。

7. 循环和自动化:

如果需要爬取多个页面或定期更新数据,你可以编写循环和自动化的代码,自动进行爬取和处理。

8. 异常处理:

在爬取过程中,可能会遭遇网络异常、网页结构变化等问题。你需要编写适当的异常处理代码,以应对这些情况,例如设置重试机制、错误日志记录等。

请注意,爬取网页数据时,需要遵守网站的使用规定和法律要求。在进行爬虫项目时,建议事先阅读并确保你的爬取行为合法合规。

示例代码说明

下面提供每个步骤的示例代码作为参考:

1. 寻找目标网站:

在这一步骤,你需要确定你要爬取的目标网站。例如,我们选择爬取豆瓣电影页面的数据。

2. 安装所需库:

使用pip工具安装所需的库。

pip install requests

pip install beautifulsoup43. 发送网络请求:

使用Requests库发送HTTP请求并获取网页内容。

import requests

url = "https://movie.douban.com/top250"

response = requests.get(url)

html = response.text4. 解析HTML内容:

使用BeautifulSoup库解析HTML内容,提取所需的数据。

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html.parser")

titles = soup.find_all("span", class_="title")

for title in titles:

print(title.text)5. 数据处理:

对爬取到的数据进行处理和清洗。

cleaned_titles = [title.text.strip() for title in titles if title.text.strip()]

for title in cleaned_titles:

print(title)6. 存储数据:

将处理后的数据存储到合适的地方,如本地文件。

with open("movies.txt", "w", encoding="utf-8") as file:

for title in cleaned_titles:

file.write(title + "\n")7. 循环和自动化:

如果需要爬取多个页面,可以使用循环和自动化的代码。

for page in range(1, 6):

url = f"https://movie.douban.com/top250?start={ (page-1) * 25 }"

response = requests.get(url)

html = response.text

soup = BeautifulSoup(html, "html.parser")

titles = soup.find_all("span", class_="title")

cleaned_titles = [title.text.strip() for title in titles if title.text.strip()]

for title in cleaned_titles:

print(title)8. 异常处理:

添加适当的异常处理代码,以应对网络异常等情况。

try:

response = requests.get(url)

response.raise_for_status()

except requests.exceptions.RequestException as e:

print("An error occurred:", e)请注意,以上代码示例仅作为参考,并可能需要根据具体情况进行调整和修改。此外,在实际的爬虫项目中,还需要考虑到网站的反爬机制、登录认证、并发处理等问题。文章来源:https://www.toymoban.com/news/detail-553700.html

总结

在实际操作中,你需要根据具体的爬取需求和目标网站的结构,使用适当的库和技术来完成每个步骤。请记得合法合规地进行爬取,遵守网站的使用规定和法律要求。此外,爬虫的实现可能会涉及更复杂的问题,如反爬机制、动态页面、分布式爬取等,可能需要进一步学习和研究相应的技术来解决这些挑战。文章来源地址https://www.toymoban.com/news/detail-553700.html

到了这里,关于Python爬虫需要那些步骤 ?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!