ChatGLM2-6B

- 项目基本情况

GitHub:https://github.com/THUDM/ChatGLM2-6B/tree/main

参考:https://mp.weixin.qq.com/s/11jCCeOpg1YbABIRLlnyvg - 主要贡献

- 更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。

-

- 更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,我们会在后续迭代升级中着重进行优化。

-

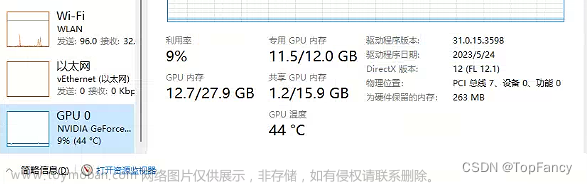

- 更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

-

- 更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用

核心:More data 、 Flash-Attention 、 Multi-Query Attention

- 更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用

- 记录

- 环境安装

git clone https://github.com/THUDM/ChatGLM2-6B

conda create -n chatglm12-offical-py310 python=3.10 # 创建新环境

source activate chatglm12-offical-py310 # 激活环境

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

下载模型

git lfs install

git clone https://huggingface.co/THUDM/chatglm2-6b

2. 微调方式

3. 模型推理

1. 命令行调用

python cli_demo.py

2. 网页端调用

streamlit run web_demo2.py --server.address “0.0.0.0” – server.port 1892

1892为docker向外映射的端口

3. 接口部署

使用的是FastAPI进行接口的调用

python api.py文章来源:https://www.toymoban.com/news/detail-554293.html

待续文章来源地址https://www.toymoban.com/news/detail-554293.html

到了这里,关于ChatGLM2-6B的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!