在使用nvcc -V和nvidia-smi查看cuda版本时不一致:

nvcc -V版本是10.1

nvidia-smi的版本是12.2

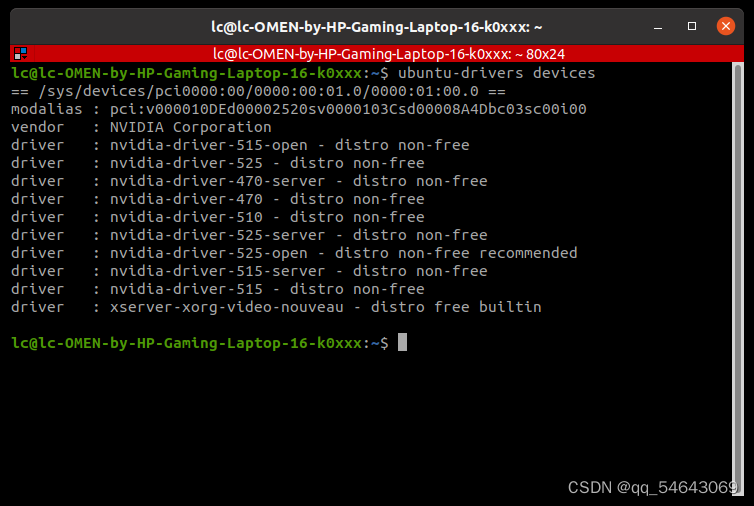

上面如果能显示版本,所以是已经有驱动,首先要删除之前的驱动:

1、执行以下命令,删除旧版本的驱动

sudo apt-get purge nvidia*

此时执行nvidia-smi,会提示Command 'nvidia-smi' not found,按照提示安装即可:

sudo apt install nvidia-utils-535-server

安装成功后,再次执行nvidia-smi,成功,显示cuda版本为12.2

2、下载对应版本的cuda

CUDA Toolkit 12.2 Downloads | NVIDIA Developer

依次选择对应选项即可:

获取下载链接:

wget https://developer.download.nvidia.com/compute/cuda/12.2.0/local_installers/cuda_12.2.0_535.54.03_linux.run

sudo sh cuda_12.2.0_535.54.03_linux.run

cuda成功下载界面如下:

3、安装

执行原始命令安装会报错,改为以下命令成功:

sudo sh ./cuda_12.2.0_535.54.03_linux.run --toolkit --silent --override

上述命令安装成功

此时再次执行,nvcc -V提示,Command 'nvcc' not found,……,不要按照提示安装nvidia-cuda-toolkit,否则,前面的白费了,此时只需要配置环境变量:

4、添加环境变量

执行:vim ~/.bashrc,打开文件:

增加(此处要根据自己的目录对应修改):

export LD_LIBRARY_PATH=/usr/local/cuda-12.2/lib64

export PATH=$PATH:/usr/local/cuda-12.2/bin

执行:source ~/.bashrc,立即生效

再次执行:nvcc -V,成功

至此,结束。

本文参考:

在linux上安装cuda的时候报错:Existing package manager installation of the driver found._点亮~黑夜的博客-CSDN博客

CUDA已经安装但nvcc -V显示command not found(Ubuntu20.04LTS系统)文章来源:https://www.toymoban.com/news/detail-555237.html

https://www.cnblogs.com/ksky-2023/p/17389977.html文章来源地址https://www.toymoban.com/news/detail-555237.html

到了这里,关于解决ubuntu cuda版本nvcc -V和nvidia-smi不一致问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!