前言:

生产环境下的kubernetes集群安装部署仅仅是前期的一点点工作,主要的工作其实是集中在集群正式运行后的维护,管理工作。

而kubernetes集群的巡视检查工作是一个比较重要的工作,可以通过定时,定期的巡检能够提前发现kubernetes集群的一些潜在问题,从而在发生大的影响运行的问题前发现问题并解决问题。

那么,通常的做法是安装部署监控软件,例如,prometheus,grafana,zabbix这些,但,毫无疑问的,这些监控系统或多或少的会对kubernetes集群有所侵入,并且监控系统也是需要维护的,这些无形中增加了我们的维护工作量。

OK,那么使用shell脚本来对集群做一个最为简单的监控,无疑是一个可行的方案。

对于kubernetes集群来说,我们关注的点应该是以下几点:

1,

kubernetes集群的关键服务,例如,kubelet,kube-scheduel,这些服务是否正常

2,

kubernetes集群的整体资源使用率,例如,所有节点的内存,CPU,这样的关键资源使用了多少,剩余多少

如果某个节点的内存使用率过高,会提示我们是哪个节点,并生成清单文件,按照清单来进行详细的分析,从而保证集群的稳定。

3,

pod的分布,例如,A节点有哪些pod在运行,这些pod运行是否正常

4,

pod的重启次数,该指标是一个关键的指标,在实际的生产中,很多pod可能实时观察的时候是running状态的,但其实这些pod在不停的反复部署,例如,因为某个存活探针的状态不稳定,某些pod需要的内存不足(pod有指定资源配额策略),造成了oom,等等各种原因都会造成pod反复重启(pod重启也就是等于pod重新部署)

因此,我们需要抓取所有pod的重启次数,并提供一个清单,后续手动的按照清单文件内所列的pod,挨个查询重启原因,以此来保证pod的健康,进而保证kubernetes集群的稳定。

基于这些需求,编写了以下的kubernetes巡检脚本

一,

巡检脚本的内容

#!/bin/bash

#!author zsk

#k8s集群日常巡检

if [ -d /opt/xunjian/$(date +'%Y-%m-%d') ];

then

echo "巡检目录已创建,今日巡检内容都存放到此目录/opt/xunjian/下"

else

mkdir -p /opt/xunjian/$(date +'%Y-%m-%d')

echo "/opt/xunjian/ 这个目录刚创建好"

fi

unhealthy=$(kubectl get cs | awk 'NR == 1 {next}{if($2 != "Healthy") print $1}' | wc -l) #组件状态异常数

kubeletError=$(systemctl status kubelet.service | grep ^"$(date | awk '{print$2,$3}')" | grep -i error | wc -l) #kubelet日志报错数

errorPod=$(kubectl get po -A | grep -v NAMESPACE| awk '{if($4 != "Running") print}' | wc -l ) #非runing状态pod数

restartPod=`kubectl get po -A |awk '{if($4>0)print$1,$4}'|grep -v NAME`

#查看controller-manager、scheduler、etcd状态

server_stat=/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-server.txt

>$server_stat

echo -e "----------Controller-manager、Scheduler、Etcd-0检测中--------------------------------------"

if (( ${unhealthy} >=1 ));then

echo -e "\033[31m$(kubectl get cs | awk 'NR == 1 {next}{if($2 != "Healthy") print $1}') Unhealthy\033[0m" >$server_stat

else

echo -e "controller-manager、scheduler、etcd-0无异常">$server_stat

fi

#查看kubelet状态

echo -e "\n \n---------- Kubelet状态检测中 ----------"

if (( ${kubeletError} >=1 ));then

echo -e "\033[31mkubelet错误日志:\033[0m" ; systemctl status kubelet.service | grep ^"$(date | awk '{print$2,$3}')" |awk '{for (i=10;i<=NF;i++)printf("%s ", $i);print ""}' | grep -i error | sort -n | uniq >> node.txt 2>&1

else

echo -e "\033[32mkubelet无日志报错\033[0m"

fi

#查看Pods状态

echo -e "\n \n---------- Pods运行状态检测中 ----------"

>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

if [ ${errorPod} -gt 1 ];then

echo -e "异常的pod信息将写入下面的文件内"

echo -e "\033[31mErrorPod:\033[0m" && kubectl get po -A | grep -v NAMESPACE | awk '{if($4 != "Running") print}' > /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

else

echo -e "所有pod运行状态都是running" > /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

fi

if [ -n "$restartPod" ];

then

echo -e "以下是有重启的pod,请根据此清单排查pod的重启原因 \n">>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

echo -e "$restartPod" >>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

else

echo "所有pod没有重启的情况">>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-pod.txt

fi

#查看Node资源使用率

check_node(){

echo -e "\n \n---------- Nodes资源使用状态检测中 ----------"

>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-node.txt

memWarn=0

for i in $(kubectl get nodes | awk 'NR == 1 {next}{print $1}');do

memRq=$(kubectl describe node $i | grep memory | grep % | awk '{print $3}' | sed "s/[^0-9]//g") #memory_request

memLim=$(kubectl describe node $i | grep memory | grep % | awk '{print $5}' | sed "s/[^0-9]//g") #memory_limit

cpuUsed=$(kubectl top nodes $i | awk 'NR == 1 {next}{print $3}'| sed "s/[^0-9]//g") #cpu使用率

memUsed=$(kubectl top nodes $i | awk 'NR == 1 {next}{print $5}'| sed "s/[^0-9]//g") #内存使用率

if (( $cpuUsed > 0)) || (( $memUsed > 0 ));then

let memWarn+=1

echo -e "$i\tCPU使用率:$cpuUsed%\t内存使用率:$memUsed" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-node.txt

fi

if [ $memUsed -gt 95 ];then

let memWarn+=1

echo "|||+++++++++++++++++++++++++++++++++++++++++++|||" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

echo -e "$i\t内存使用率超出预期,请检查内存占用率过高的原因!!!" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

echo "|||++++++++++++++++++++++++++++++++++++++++++|||" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

echo -e "\n \n \n" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

else

echo -e "$i 该节点的内存在正常范围内" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

fi

done

#if (( $memWarn ==0 ));then

# echo -e "无节点CPU、内存使用异常" >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-memory.txt

#fi

}

check_node

##获取node的详情,记录每个节点内的运行了哪些pod,以及pod的资源使用情况

>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-describenode.txt

for e in $(kubectl get node |grep -v NAME|awk '{print $1}')

do

kubectl describe node $e >> /opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-describenode.txt 2>&1

echo -e "\n \n" >>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-describenode.txt

echo "||++++++++++++++++++++++++++++++++++++++这是分隔这是分隔这是分隔这是分隔+++++++++++++||" >>/opt/xunjian/$(date +'%Y-%m-%d')/$(date +'%Y-%m-%d')-describenode.txt

done

jilu_tar(){

cd /opt/xunjian

tar cvjf /opt/xunjian.tar.gz /opt/xunjian

echo "打包成功"

}

jilu_tar

二,

巡检脚本的使用的前置条件

1,

需要kubernetes集群内部署有metric-server 插件即可,因为脚本内很多关键数据是通过此插件来查询的

metric-server的部署见我的博客:

云原生|kubernetes|centos7下离线化部署kubesphere-3.3.2---基于kubernetes-1.22.16(从网络插件开始记录)_kubesphere离线部署_晚风_END的博客-CSDN博客

2,

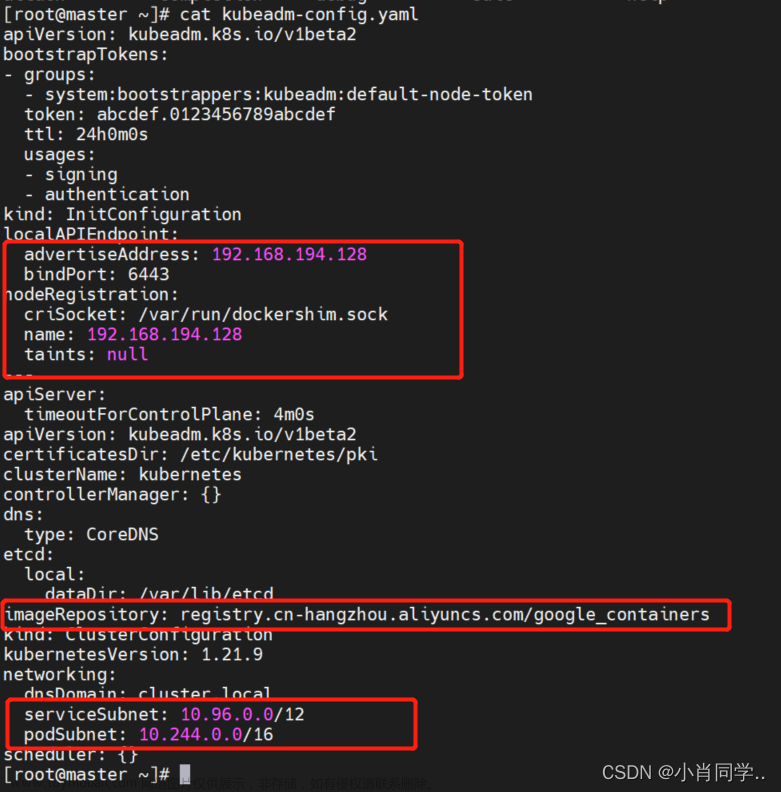

kubernetes集群是以kubeadm方式部署的,etcd集群是内部堆叠形式部署的,因为脚本内的服务检查是通过kubectl get cs命令来检查的

三,

脚本说明

该脚本将会生成5个文件,文件存放路径是/opt/xunjian/当前日期 日期格式为2023-07-12

describe文件保存了所有节点的详细信息

memory文件保存了所有节点内存使用率,如果超出脚本内设定的95,将会提示

node文件保存了当前的节点的资源使用情况,第一列是节点IP,第二列是cpu使用率,第三列是内存使用率

pod文件保存了有过重启的pod的名称和重启次数,如果pod都正常,打印无异常pod文章来源:https://www.toymoban.com/news/detail-556466.html

server文件保存了集群的主要服务是否正常,如有异常,将会提示。文章来源地址https://www.toymoban.com/news/detail-556466.html

到了这里,关于云原生|kubernetes|kubernetes集群巡检脚本的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!