朴素贝叶斯(Naive Bayes)是一种基于贝叶斯定理和特征独立性假设的简单但有效的分类算法。它常用于文本分类、垃圾邮件过滤和情感分析等任务。下面我将详细解释朴素贝叶斯的原理和步骤。

首先,我们需要了解几个重要的概念:

-

贝叶斯定理(Bayes' theorem):贝叶斯定理是概率论中的一个基本定理,用于计算在已知一些先验条件的情况下,某个事件的后验概率。在朴素贝叶斯中,我们使用贝叶斯定理来计算给定特征条件下的类别的后验概率。

-

后验概率(Posterior probability):后验概率是指在已知某个特征条件下,某个类别发生的概率。在朴素贝叶斯中,我们希望计算每个类别的后验概率,以确定最有可能的类别。

-

特征独立性假设(Independence assumption):朴素贝叶斯算法的核心假设是所有特征之间相互独立。这意味着每个特征对于分类结果的贡献是相互独立的,不考虑特征之间的相关性。

现在,我们来看看朴素贝叶斯算法的步骤:

-

数据准备:首先,我们需要准备一个带有已知类别的训练数据集。数据集由多个样本组成,每个样本都有一组特征和对应的类别标签。

-

特征提取:对于每个样本,我们从中提取相关的特征。这可以是文本分类中的单词频率、词袋模型或TF-IDF权重等。特征提取的目的是将样本转换为可计算概率的形式。

-

计算先验概率:在朴素贝叶斯中,先验概率是指在不考虑任何特征条件下,每个类别发生的概率。我们通过计算训练数据集中每个类别的频率来估计先验概率。

-

计算条件概率:在朴素贝叶斯中,条件概率是指在已知某个类别的情况下,每个特征发生的概率。我们根据训练数据集中每个类别下各个特征的频率来计算条件概率。

-

计算后验概率:根据贝叶斯定理,我们可以计算给定某个特征条件下,每个类别的后验概率。后验概率可以通过先验概率和条件概率相乘得到。

-

进行分类:在测试阶段,我们使用计算得到的后验概率来进行分类。选择具有最高后验概率的类别作为最终的分类结果。

需要注意的是,由于朴素贝叶斯算法假设特征之间相互独立,因此在处理实际问题时,如果特征之间存在相关性,可能会影响算法的性能。此外,如果某个特征在训练数据中未出现,会导致条件概率为零,这可能会对分类结果产生不良影响。为了解决这个问题,可以使用平滑技术,如拉普拉斯平滑(Laplace smoothing)。

朴素贝叶斯算法通过贝叶斯定理和特征独立性假设,计算给定特征条件下每个类别的后验概率,并选择具有最高后验概率的类别作为分类结果。尽管它有一些限制,但朴素贝叶斯算法简单、高效,并在许多实际应用中表现良好。

朴素贝叶斯(Naive Bayes)算法具有以下优点:

-

简单高效:朴素贝叶斯算法是一种简单而高效的分类算法,它在处理大规模数据集时具有较快的训练和预测速度。

-

对小样本数据有效:朴素贝叶斯算法对于小样本数据集的分类效果通常很好,即使数据集的特征维度较高,也能够给出较好的结果。

-

处理多分类问题:朴素贝叶斯算法可以很容易地扩展到多分类问题,并且在多类别分类任务中表现良好。

-

处理高维数据:朴素贝叶斯算法在处理高维数据时具有较好的表现,因为它假设特征之间相互独立,可以有效地处理高维特征。

然而,朴素贝叶斯算法也存在一些缺点:

-

特征独立性假设:朴素贝叶斯算法假设所有特征之间相互独立,这在实际问题中并不总是成立。如果特征之间存在相关性,朴素贝叶斯算法的性能可能会受到影响。

-

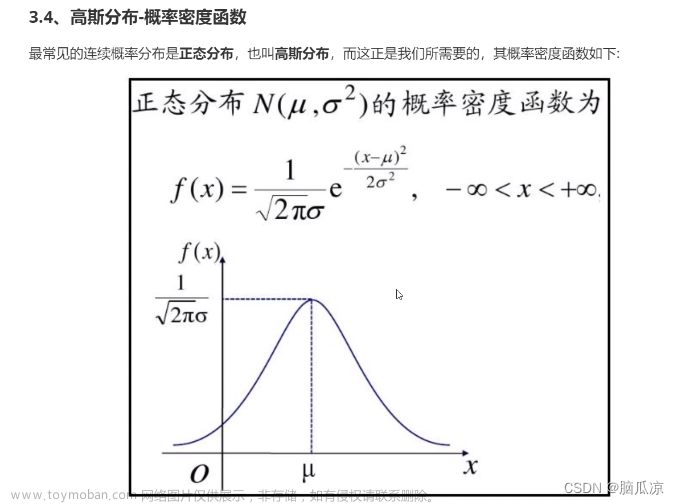

对输入数据的分布假设:朴素贝叶斯算法假设输入数据的分布满足特定的条件概率分布,如高斯分布或多项式分布。如果数据的分布与这些假设不符,算法的性能可能会下降。

-

零概率问题:当某个特征在训练数据中未出现时,朴素贝叶斯算法会将其条件概率估计为零,这可能导致分类错误。为了解决这个问题,可以使用平滑技术来避免零概率问题。

使用朴素贝叶斯算法时,可以考虑以下一些技巧:

-

特征选择:选择具有较高信息量和较低冗余的特征对于朴素贝叶斯算法的性能很重要。可以使用特征选择方法(如信息增益、卡方检验等)来选择最相关的特征。

-

数据平滑:为了避免零概率问题,可以使用平滑技术,如拉普拉斯平滑(Laplace smoothing)或Lidstone平滑,来调整概率估计。

-

处理连续特征:对于连续特征,可以将其离散化为不同的取值区间,然后将其视为离散特征进行处理。可以使用直方图或分位数等方法进行离散化。

-

处理缺失数据:当输入数据中存在缺失值时,可以使用合适的方法进行处理,如填充缺失值或使用缺失值指示符等。

-

考虑特征相关性:尽管朴素贝叶斯算法假设特征之间相互独立,但在实际问题中,特征之间可能存在一定的相关性。可以使用特征工程技术,如主成分分析(PCA)或因子分析等,来减少特征之间的相关性。

朴素贝叶斯算法具有简单高效、适用于小样本和高维数据的优点,但也受到特征独立性假设和对数据分布的假设的限制。在实际使用中,可以根据具体问题选择适当的技巧来提高算法的性能。

下面是一个简单的朴素贝叶斯分类器的示例代码,用于文本分类任务:

import numpy as np

class NaiveBayesClassifier:

def __init__(self):

self.classes = None

self.class_prior_probs = None

self.feature_probs = None

def fit(self, X, y):

self.classes = np.unique(y)

self.class_prior_probs = self.calculate_class_prior_probs(y)

self.feature_probs = self.calculate_feature_probs(X, y)

def calculate_class_prior_probs(self, y):

class_prior_probs = {}

total_samples = len(y)

for class_label in self.classes:

class_samples = np.sum(y == class_label)

class_prior_probs[class_label] = class_samples / total_samples

return class_prior_probs

def calculate_feature_probs(self, X, y):

feature_probs = {}

for class_label in self.classes:

class_samples = X[y == class_label]

feature_probs[class_label] = np.mean(class_samples, axis=0)

return feature_probs

def predict(self, X):

predictions = []

for sample in X:

posteriors = []

for class_label in self.classes:

class_prior_prob = self.class_prior_probs[class_label]

feature_prob = self.feature_probs[class_label]

posterior = np.prod(self.calculate_likelihood(sample, feature_prob)) * class_prior_prob

posteriors.append(posterior)

predicted_class = self.classes[np.argmax(posteriors)]

predictions.append(predicted_class)

return predictions

def calculate_likelihood(self, sample, feature_prob):

likelihood = []

for feature, prob in zip(sample, feature_prob):

likelihood.append(prob ** feature)

return likelihood

使用示例:

# 准备训练数据

X_train = np.array([[1, 0, 1, 0],

[1, 1, 0, 1],

[0, 1, 0, 1],

[0, 0, 1, 0]])

y_train = np.array(['A', 'B', 'B', 'A'])

# 创建并训练朴素贝叶斯分类器

classifier = NaiveBayesClassifier()

classifier.fit(X_train, y_train)

# 准备测试数据

X_test = np.array([[1, 0, 0, 1],

[0, 1, 1, 0]])

# 进行预测

predictions = classifier.predict(X_test)

print(predictions) # 输出预测结果

这个示例代码实现了一个简单的朴素贝叶斯分类器,用于根据输入的特征进行文本分类。首先,通过fit方法对分类器进行训练,然后使用predict方法对新的样本进行分类预测。在示例中,训练数据X_train包含四个样本,每个样本有四个特征,对应的类别标签存储在y_train中。通过训练数据来训练分类器后,使用测试数据X_test进行预测,并输出预测结果。

请注意,这只是一个简单的示例代码,用于说明朴素贝叶斯算法的基本原理。在实际应用中,可能需要对特征进行预处理、处理更复杂的数据类型,以及应用平滑技术等来提高算法的性能。

文章来源地址https://www.toymoban.com/news/detail-558571.html文章来源:https://www.toymoban.com/news/detail-558571.html

到了这里,关于机器学习朴素贝叶斯笔记的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[学习笔记] [机器学习] 9. 朴素贝叶斯(概率基础、联合概率、条件概率、贝叶斯公式、情感分析)](https://imgs.yssmx.com/Uploads/2024/02/489438-1.png)