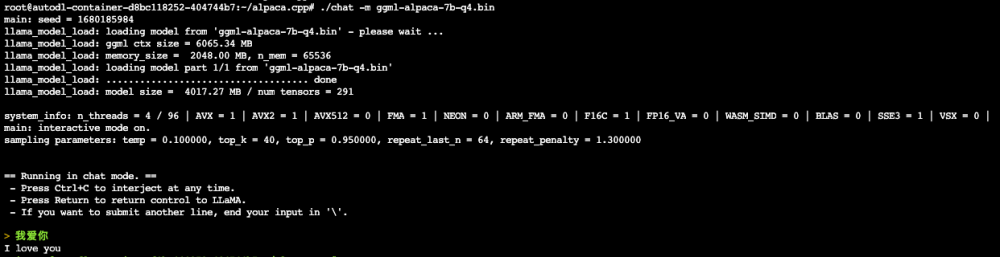

斯坦福的 Alpaca 模型基于 LLaMA-7B 和指令微调,仅使用约 5 万条训练数据,就能达到类似 GPT-3.5 的效果。

斯坦福70亿参数开源模型媲美GPT-3.5,100美元即可复现

Alpaca 的训练流程很简单,只有两个步骤:文章来源:https://www.toymoban.com/news/detail-560086.html

- 将 175 个人工设计的指令任务作为种子,使用 text-davinci-003 随机生成指令,最终生成了 52,000 条指令数据。例如:

{

"instruction": "Rewrite the following sentence in the third person",

"input": "I am anxious",

"output": "She is anxious."

}, {

"instruction": "What are the three primary colors?",

"input": "",

"output": "The three primary colors are red, blue, and yellow."

},2. 用指令数据基于 Hugging Face 的训练框架微调 LLaMA 模型。文章来源地址https://www.toymoban.com/news/detail-560086.html

到了这里,关于LLM-2023:Alpaca(羊驼)【Stanford】【性能与GPT3.5相当比GPT4逊色,训练成本不到100美元,基于LLaMA和指令微调,仅使用约5万条训练数据就能达到类似GPT-3.5】的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![大语言模型的预训练[2]:GPT、GPT2、GPT3、GPT3.5、GPT4相关理论知识和模型实现、模型应用以及各个版本之间的区别详解](https://imgs.yssmx.com/Uploads/2024/02/587446-1.png)

![[最新搭建教程]0基础Linux CentOS7系统服务器本地安装部署ChatGPT模型服务搭建/免费域名绑定网页Https访问/调用open AI的API/GPT3/GPT3.5/GPT4模型接口](https://imgs.yssmx.com/Uploads/2024/02/499065-1.png)