接上文安装与部署ELK详解

1. 部署Filebeat节点

###关闭和禁止防火墙开机自启功能

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

1.1 部署Apache服务

(1)在Filebeat节点上,安装Apache服务

yum install -y httpd

(2)修改Apache服务的配置文件

vim /etc/httpd/conf/httpd.conf

ServerName www.clr.com:80

(3)开启Apache服务

systemctl start httpd

systemctl enable httpd

netstat -lntp | grep httpd

(4)浏览器访问,验证Apache服务

http://192.168.80.40/

1.2 部署Filebeat服务

(1) 安装Filebeat

cd /opt

rz -E

#filebeat-6.7.2-linux-x86_64.tar.gz

tar xf filebeat-6.7.2-linux-x86_64.tar.gz

(2)设置filebeat的主配置文件

cd /opt/filebeat-6.7.2-linux-x86_64/

cp filebeat.yml{

,.bak}

vim filebeat.yml

###15行-------------

filebeat.inputs:

- type: log #指定log类型,从日志文件中读取消息

enabled: true

paths:

- /var/log/httpd/access_log #指定监控的日志文件

- tags: ["filebaeat"]

#设置索引标签

###46行--------------------

fields: #可以使用fields配置选项,设置一些参数字段添加到output中

service_name: httpd #重点强调,service_name:与httpd中间存在一个空格

log_type: access

from: 192.168.80.40

--------------Elasticsearch output-------------------

###152行

(全部注释掉)

----------------Logstash output---------------------

###165行

output.logstash:

hosts: ["192.168.80.30:5044"] #指定logstash的IP和端口

(3)启动filebeat

nohup ./filebeat -e -c filebeat.yml > filebeat.out &

#-e:输出到标准输出,禁用syslog/文件输出

#-c:指定配置文件

#nohup:在系统后台不挂断地运行命令,退出终端不会影响程序的运行

(4)在Logstash组件所在节点上,新建一个Logstash配置文件(CentOS 7-3)

vim /etc/logstash/conf.d/filebeat.conf

input {

beats {

port => "5044"

}

}

output {

elasticsearch {

hosts => ["192.168.80.10:9200","192.168.80.20:9200"]

index => "%{[fields][service_name]}-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

(5)启动logstash,加载配置文件

cd /etc/logstash/conf.d

logstash -f /etc/logstash/conf.d/filebeat.conf #切记logstash服务一定要在/etc/logstash/conf.d配置文件的绝对路径下启动

###在filebeat节点上启动filebeat服务,并检查配置我文件filebeat.yml

./filebeat -e -c filebeat.yml #在加载logstash -f /etc/logstash/conf.d/*.conf配置文件时,要保证filebeat服务一直是开启的状态

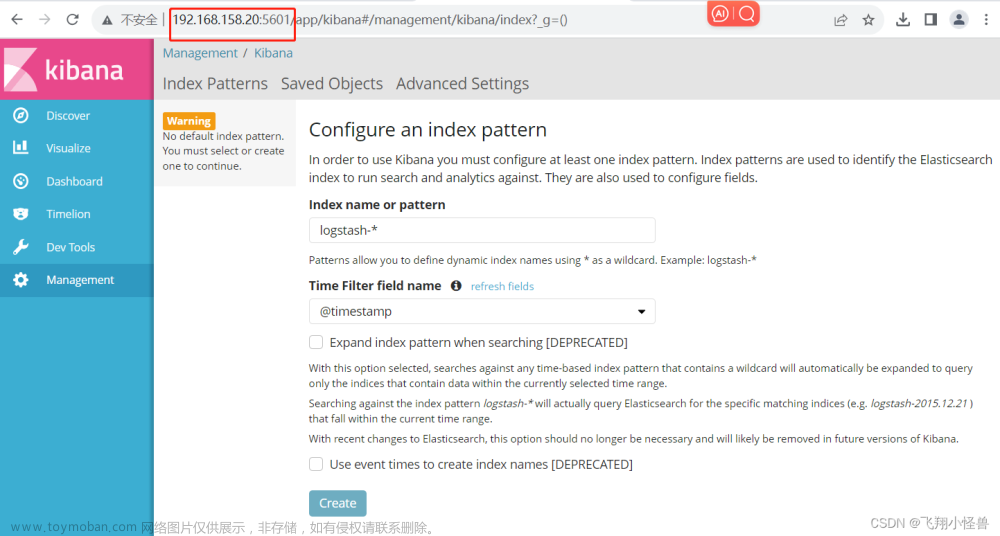

(6)浏览器访问

http://192.168.80.10:5601

登录Kibana,单击“Create Index Pattern”按钮添加索引“filebeat-*”,单击 “create” 按钮创建,单击 “Discover” 按钮可查看图表信息及日志信息。

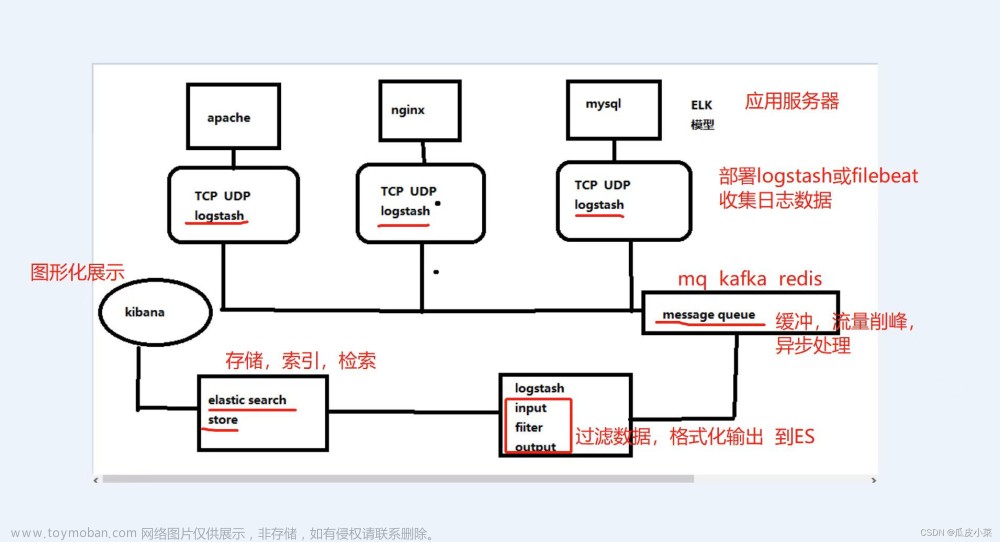

2. filter插件

对于Logstash的Filter,这个才是Logstash最强大的地方。Filter插件也非常多,我们常用到的grok、date、mutate、mutiline四个插件。

对于filter的各个插件执行流程,可以看下面这张图:

2.1 grok正则捕获插件

grok使用文本片段切分的方式,来切分日志事件.

2.1.1 内置正则表达式调用

语法:%{SYNTAX:SEMANTIC}

-

SYNTAX代表匹配值的类型,例如,0.11可以NUMBER类型所匹配,10.222.22.25可以使用IP匹配。

-

SEMANTIC表示存储该值的一个变量声明,它会存储在elasticsearch当中,方便kibana做字段搜索和统计,你可以将一个IP定义为客户端IP地址client_ip_address,如%{IP:client_ip_address},所匹配到的值就会存储到client_ip_address这个字段里边,类似数据库的列名,也可以把event log中的数字,当成数字类型存储在一个指定的变量当中,比如响应时间http_response_time,假设event log record如下:文章来源:https://www.toymoban.com/news/detail-570651.html

message: 192.168.80.10 GET /index.html 15824 0.043

#可以使用如下grok pattern来匹配这种记录

%{

IP:client_id_address} %{

WORD:method} %{

URIPATHPARAM:request} %{

NUMBER:bytes} %{

NUMBER:http_response_time}

文章来源地址https://www.toymoban.com/news/detail-570651.html

文章来源地址https://www.toymoban.com/news/detail-570651.html

到了这里,关于【ELK企业级日志分析系统】部署Filebeat+ELK详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!