关键字:LLM大语言模型,fine-tuning微调

预训练语言模型的两种范式

1 特征提取器

提取语言的特征和表示,作为下游模型的输入。例如有名的word2vec模型。

use the output of PLMs as the input of downstream model

2 fine-tuning(微调)

既能提取语言的特征,同时又是下游模型,参数随着训练被更新。例如有名的gpt和bert。

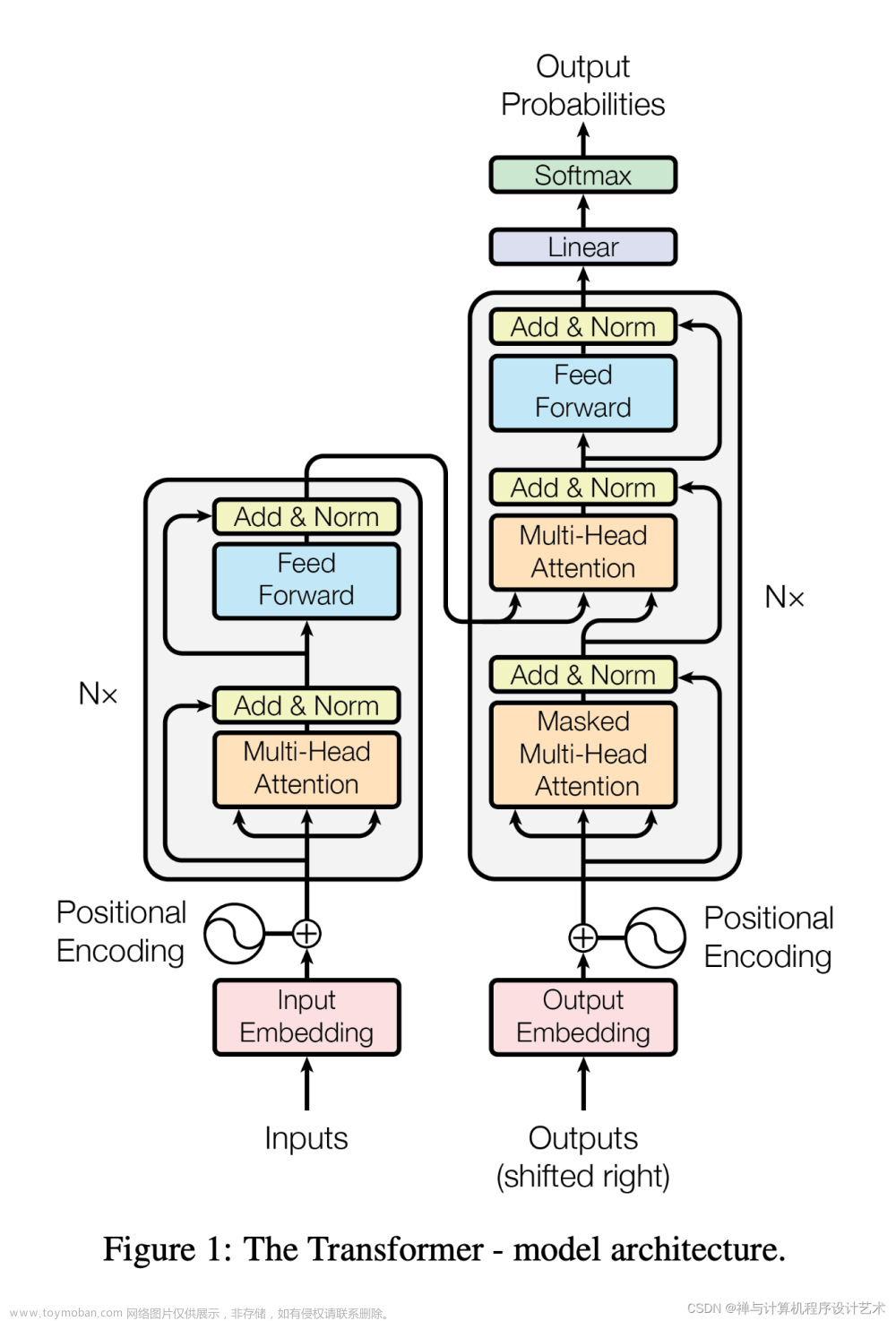

GPT

一个强大的生成模型

从左到右自回归学习地去做预训练。

BERT

双向理解文本,加入mask去遮盖一些词,可以理解成完形填空。随机mask一些词,比例是15%,然后在模型最后一层去预测这些被遮盖的词。

BERT高效的预训练任务:Masked的词预测;下一个句子预测。

BERT存在的问题

预训练和微调间存在鸿沟,[mask] token在预训练中很重要,但是在下游任务中不会出现,也就是不会出现在微调阶段。

预训练效率低,只能预测15%的词。

预训练大语言模型的进展(2023)

参考论文:Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond文章来源:https://www.toymoban.com/news/detail-570803.html

论文链接:https://arxiv.org/pdf/2304.13712.pdf文章来源地址https://www.toymoban.com/news/detail-570803.html

到了这里,关于大模型基础之大语言模型的进展的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!