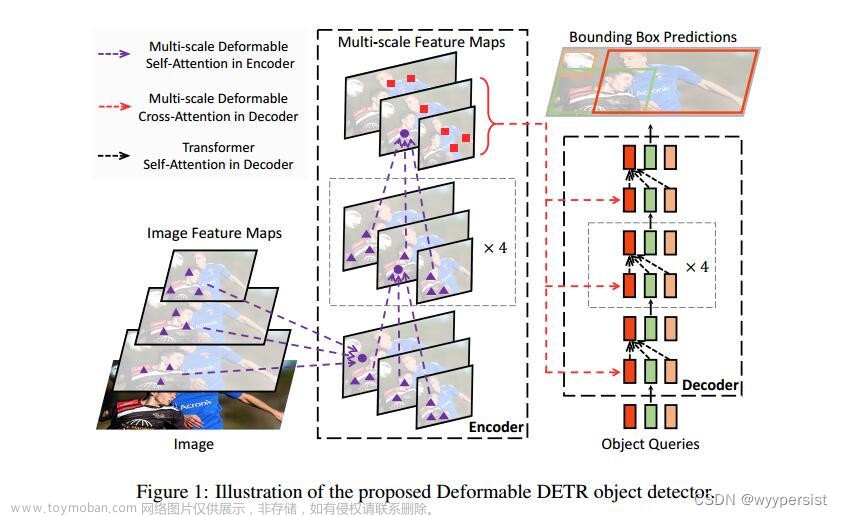

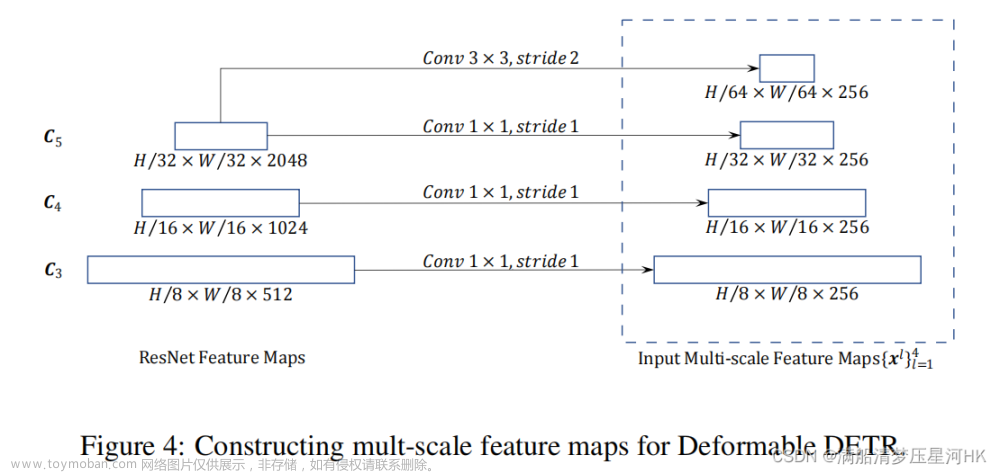

目标检测系列的算法模型可以说是五花八门,不同的系列有不同的理论依据,DETR的亮点在于它是完全端到端的第一个目标检测模型,DETR(Detection Transformer)是一种基于Transformer的目标检测模型,由Facebook AI Research开发。它采用了端到端的方法,在目标检测任务中同时完成目标定位和分类。DETR模型结合了Transformer的自注意力机制和编码器-解码器结构。通过将图像作为输入,并使用Transformer解码器来生成预测框和对应的类别。与传统的目标检测方法不同,DETR不需要使用锚框或候选区域,而是直接从全局观察中生成预测。

DETR模型的训练过程包括两个阶段:首先,使用交叉熵损失函数对预测框和类别进行监督学习;然后,使用匈牙利算法将预测框与真实框进行匹配,计算IoU损失以进一步优化预测结果。DETR模型在目标检测任务上取得了很好的性能,并且具有较高的效率和灵活性。它可以应用于多种场景,如物体检测、实例分割等任务。

DETR官方项目地址在这里,如下所示:

文章来源:https://www.toymoban.com/news/detail-581715.html

文章来源:https://www.toymoban.com/news/detail-581715.html

目前已经有超过11.4k的star量,足以见得这是一款很出色的检测模型了。文章来源地址https://www.toymoban.com/news/detail-581715.html

到了这里,关于DETR (DEtection TRansformer)基于自建数据集开发构建目标检测模型超详细教程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!