1. 介绍

中文分词是将连续的中文文本切分成一个个独立的词语的过程,是中文文本处理的基础。IK分词器是一个高效准确的中文分词工具,采用了"正向最大匹配"算法,并提供了丰富的功能和可定制选项。

2. IK分词器的特点

- 细粒度和颗粒度的分词模式选择。

- 可自定义词典,提高分词准确性。

- 支持中文人名、地名等专有名词的识别。

- 适用于中文搜索、信息检索、文本挖掘等应用领域。

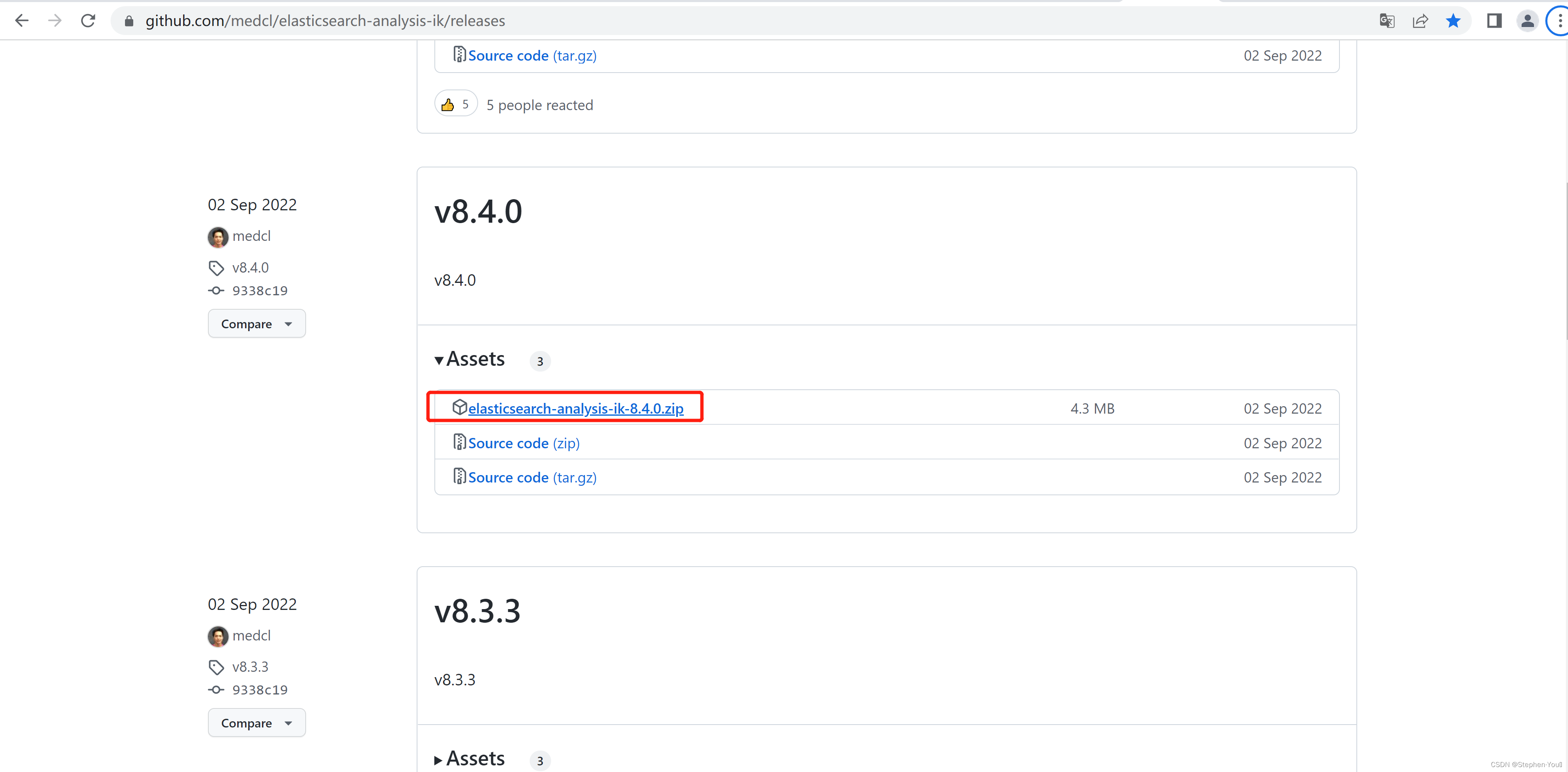

3. 引入IK分词器的依赖

IK分词器的实现是基于Java语言的,所以你需要下载IK分词器的jar包,并将其添加到你的Java项目的构建路径中。你可以从IK分词器的官方网站或GitHub仓库上获取最新的jar包。

<dependency>

<groupId>org.wltea</groupId>

<artifactId>ik-analyzer</artifactId>

<version>6.6.6</version>

</dependency>

4. 示例代码

我们提供了一个简单的Java示例代码,展示了如何使用IK分词器进行中文文本分词。示例代码包括初始化分词器、输入待分词文本、获取分词结果等步骤。读者可以根据该示例快速上手使用IK分词器。

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme;

import java.io.IOException;

import java.io.StringReader;

public class IKDemo {

public static void main(String[] args) {

String text = "我喜欢使用IK分词器进行中文分词。";

try (StringReader reader = new StringReader(text)) {

IKSegmenter segmenter = new IKSegmenter(reader, true);

Lexeme lexeme;

while ((lexeme = segmenter.next()) != null) {

System.out.println(lexeme.getLexemeText());

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

在上述示例中,我们首先定义了一个待分词的文本字符串。然后,我们创建一个StringReader对象,将待分词的文本作为输入。接下来,我们创建一个IKSegmenter对象,并传入StringReader对象和true参数,表示启用智能分词模式。

在使用IKSegmenter对象进行分词时,我们使用next()方法获取下一个分词结果,返回一个Lexeme对象。我们通过调用getLexemeText()方法获取分词结果的文本内容,并将其打印输出

我

喜欢

使用

IK

分词器

进行

中文

分词

这个示例演示了如何使用IK分词器对中文文本进行基本的分词处理。你可以根据需要扩展和定制分词器的功能,例如添加自定义词典、设置分词模式等,以满足特定的分词需求。

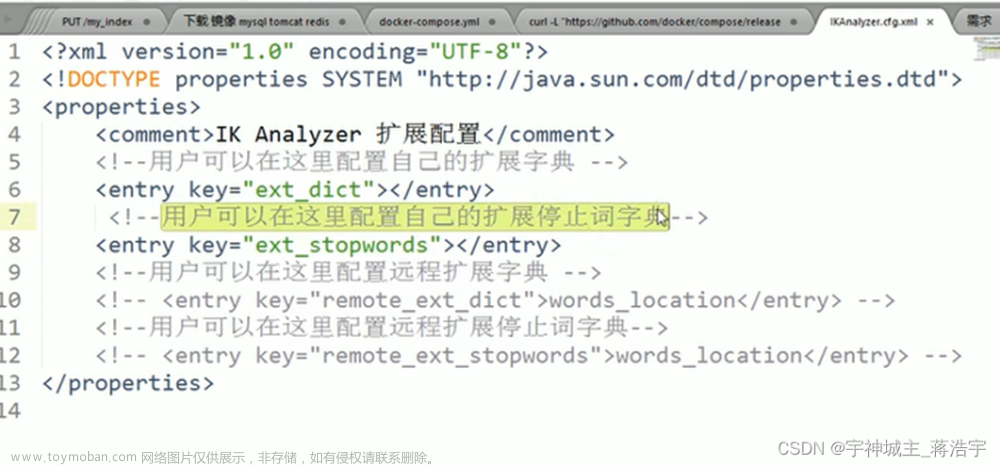

5.扩展用法:自定义词片

IK分词器允许自定义词典,以便更好地适应特定的分词需求。通过添加自定义词典,你可以确保IK分词器能够识别和切分你所需的特定词汇。

IK分词器提供两种方式来添加自定义词典:

- 扩展词典:你可以创建一个文本文件,每行添加一个词汇,用于扩展分词器的默认词典。每个词汇可以包含一个或多个中文词语,并使用空格或其他分隔符进行分隔。然后,通过

Configuration类的setMainDictionary方法将自定义词典文件加载到IK分词器中。 - 补充词典:在某些情况下,你可能需要临时添加一些词汇,而不想修改默认的词典。在这种情况下,你可以使用

IKSegmenter的addSupplementDictionary方法,动态地添加补充词典。补充词典中的词汇将会在分词过程中生效,但并不会被永久保存。

通过自定义词典,你可以增加或修改IK分词器的词汇库,从而使其更准确地切分特定的词汇。这对于领域特定的文本处理任务尤为重要,例如特定行业的术语、品牌名称等。

示例代码:

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme;

import org.wltea.analyzer.core.Lexeme;

import java.io.IOException;

import java.io.StringReader;

public class IKDemo {

public static void main(String[] args) {

String text = "我喜欢使用IK分词器进行中文分词。";

// 添加自定义词典

String customDictionary = "自定义词\n喜欢使用\n中文分词";

IKSegmenter segmenter = new IKSegmenter(new StringReader(text), true);

segmenter.setMainDictionary(customDictionary);

try {

Lexeme lexeme;

while ((lexeme = segmenter.next()) != null) {

System.out.println(lexeme.getLexemeText());

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

在上述示例中,我们首先定义了一个待分词的文本字符串。然后,我们创建了一个自定义词典字符串,包含了我们希望添加到分词器中的自定义词汇。在这个例子中,我们添加了词汇"自定义词"、“喜欢使用"和"中文分词”。

接下来,我们创建了一个IKSegmenter对象,将待分词的文本和一个布尔值参数传递给构造函数。该布尔值参数表示是否使用智能分词模式。

然后,我们使用setMainDictionary方法将自定义词典字符串设置为主词典。这样,自定义词典中的词汇将会被加载到IK分词器中,并在分词过程中起作用。

最后,我们使用next方法获取下一个分词结果,并通过getLexemeText方法获取分词结果的文本内容,并将其打印输出。

运行以上代码,你将看到以下输出结果:

我

喜欢使用

IK

分词器

进行

中文分词

6. 结论

IK分词器是一个功能强大的中文分词工具,可广泛应用于各种中文文本处理任务。本文通过介绍IK分词器的特点和使用方法,帮助读者了解和掌握中文分词的基本概念和操作。读者可以根据自己的需求扩展和定制IK分词器,以实现更精确和高效的中文分词效果。文章来源:https://www.toymoban.com/news/detail-581983.html

在实际应用中,中文分词对于提高文本处理和信息检索的准确性和效率至关重要。通过使用IK分词器,我们可以更好地处理中文文本,从而提供更好的用户体验和结果。希望本文能为读者提供有价值的指导和启示,促进中文分词技术的应用和发展。文章来源地址https://www.toymoban.com/news/detail-581983.html

到了这里,关于中文分词入门:使用IK分词器进行文本分词(附Java代码示例)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!