在日常爬虫工作中我们会遇到这样需要先进行登录才能获取数据的网站,那在遇到这样的情况时我们需要怎么处理呢?今天我们就来简单的分享学习下爬虫对需要登录情况下得处理方式。

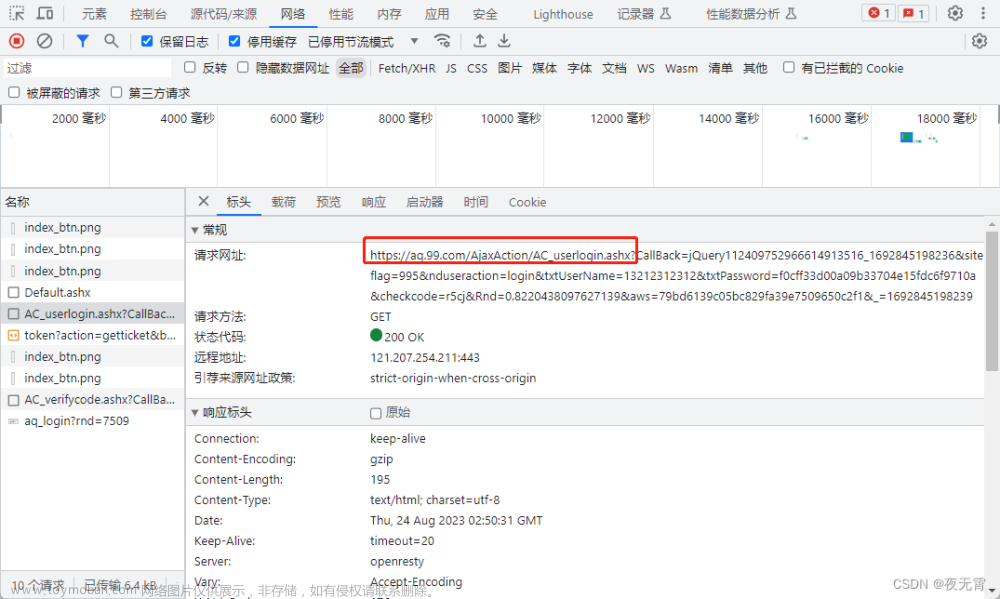

通常情况下,用户通过浏览器登录网站时,在特定的登录界面,输入个人登录信息,提交之后便能返回一个包含数据的网页。在浏览器层面的机制是,浏览器提交包含必要信息的http Request,服务器返回http Response。在运行爬虫过程中我们可以通过2种方式进行登录。

1、使用表单登陆

这种情况属于post请求,即先向服务器发送表单数据,服务器再将返回的cookie存入本地。

import requests

data = {'data1':'XXXXX', 'data2':'XXXXX'}

response = requests.post(url=url, data=data)

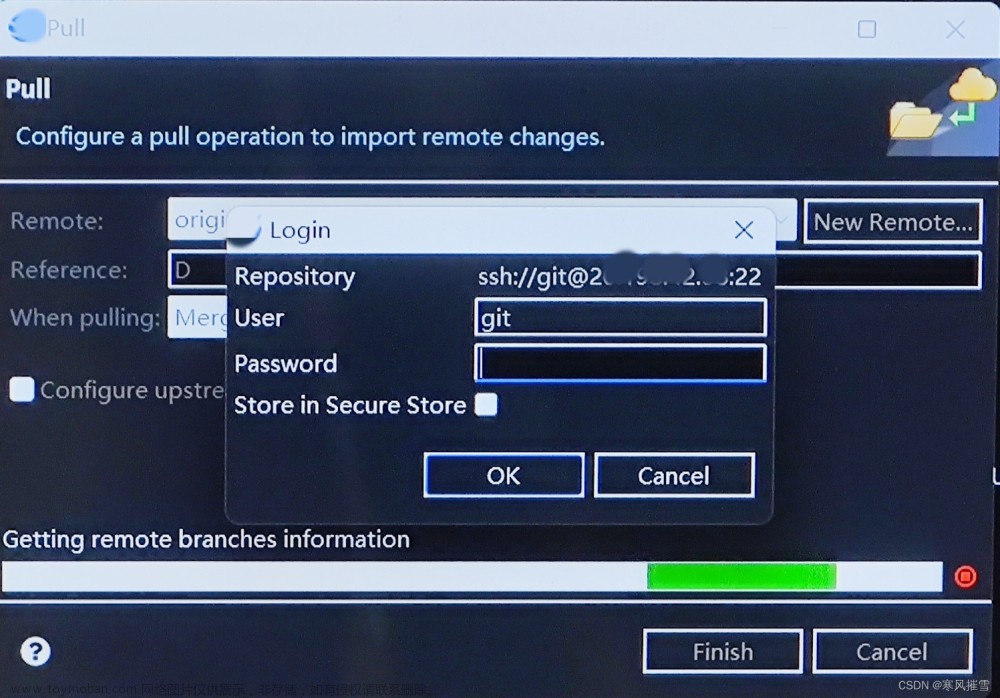

2、使用cookie进行登录

使用cookie登陆,服务器会认为你是一个已登陆的用户,所以就会返回给你一个已登陆的内容。因此,需要验证码的情况可以使用带验证码登陆的cookie解决。

Plain Text

复制代码

#! -*- encoding:utf-8 -*-

import requests

import random

import requests.adapters

# 要访问的目标页面

targetUrlList = [

"https://httpbin.org/ip",

"https://httpbin.org/headers",

"https://httpbin.org/user-agent",

]

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = "t.16yun.cn"

proxyPort = "31111"

# 代理隧道验证信息

proxyUser = "username"

proxyPass = "password"

proxyMeta = "http://%(user)s:%(pass)s@%(host)s:%(port)s" % {

"host": proxyHost,

"port": proxyPort,

"user": proxyUser,

"pass": proxyPass,

}

# 设置 http和https访问都是用HTTP代理

proxies = {

"http": proxyMeta,

"https": proxyMeta,

}

# 访问三次网站,使用相同的Session(keep-alive),均能够保持相同的外网IP

s = requests.session()

# 设置cookie

cookie_dict = {"JSESSION":"123456789"}

cookies = requests.utils.cookiejar_from_dict(cookie_dict, cookiejar=None, overwrite=True)

s.cookies = cookies

for i in range(3):

for url in targetUrlList:

r = s.get(url, proxies=proxies)

print r.text

若存在验证码,此时采用response = requests_session.post(url=url_login, data=data)是不行的,做法应该如下:

Plain Text

复制代码文章来源:https://www.toymoban.com/news/detail-585729.html

response_captcha = requests_session.get(url=url_login, cookies=cookies)

response1 = requests.get(url_login) # 未登陆

response2 = requests_session.get(url_login) # 已登陆,因为之前拿到了Response Cookie!

response3 = requests_session.get(url_results) # 已登陆,因为之前拿到了Response Cookie!

这只是其中的两种登录方式,有其他解决爬虫登录问题方法的可以留言大家交流学习下。文章来源地址https://www.toymoban.com/news/detail-585729.html

到了这里,关于爬虫遇到需要登录的网站怎么解决的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!