前言

大家早好、午好、晚好吖 ❤ ~欢迎光临本文章

猫途鹰(TripAdvisor)是一个旅游点评网站,如果您想要爬取该网站的数据,需要了解该网站的访问规则和爬取限制。

环境使用:

-

Python 3.8

-

Pycharm

代码实现

针对猫途鹰网站,可以使用Python的第三方库Selenium模拟浏览器行为,模拟用户在网站上进行的操作,从而获取数据。

以下是一个简单的实现过程:

-

安装必要的库:Selenium和BeautifulSoup

win + R 输入cmd 输入安装命令 pip install 模块名

(如果你觉得安装速度比较慢, 你可以切换国内镜像源)

pip install selenium beautifulsoup4

- 下载对应浏览器的webdriver,安装到系统中

# 以Chrome浏览器调用为例

# 下载对应管理器

from selenium import webdriver

driver_path = "/path/to/chromedriver"

options=webdriver.ChromeOptions()

options.add_argument('--no-sandbox') # 以root模式下不是必须的,非root模式下才有必要

源码、解答、教程等加V:qian97378免费领取

browser = webdriver.Chrome(executable_path=driver_path, options=options)

- 发送HTTP请求,获取目标页面数据

url = "https://www.tripadvisor.cn/Attractions-g186338-Activities-London_England.html#FILTERED_LIST"

browser.get(url)

html = browser.page_source

soup = BeautifulSoup(html, "html.parser")

- 解析HTML页面,获取所需数据

results = []

for element in soup.find_all("div", class_="listItem"):

name = element.find("div", class_="listing_title").text

rating = element.find("span", class_="ui_bubble_rating")['class'][1][1]

review_count = element.find("a", class_="review_count").text.split(" ")[0]

results.append((name, rating, review_count))

- 采集数据并保存,便于之后的处理和分析

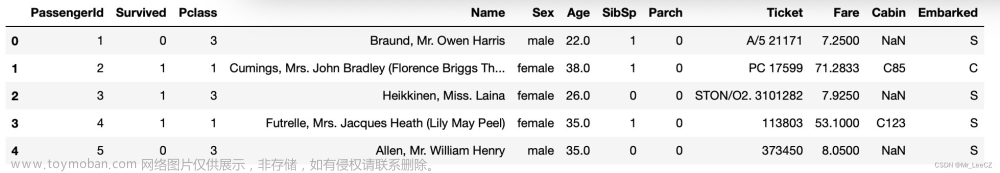

df = pd.DataFrame(results, columns=["name", "rating", "review_count"])

df.to_csv("tripadvisor_data.csv", index=False)

请注意,具体的爬取过程可能随着网站的改变而变化,请您自己进行具体的分析和处理。本人只是提供一个简单的实现过程供参考。

尾语 💝

好了,今天的分享就差不多到这里了!

完整代码、更多资源、疑惑解答直接点击下方名片自取即可。

对下一篇大家想看什么,可在评论区留言哦!看到我会更新哒(ง •_•)ง

喜欢就关注一下博主,或点赞收藏评论一下我的文章叭!!!

文章来源:https://www.toymoban.com/news/detail-588390.html

文章来源:https://www.toymoban.com/news/detail-588390.html

最后,宣传一下呀~👇👇👇更多源码、资料、素材、解答、交流皆点击下方名片获取呀👇👇👇文章来源地址https://www.toymoban.com/news/detail-588390.html

到了这里,关于使用Python提取TripAdvisor数据:探索旅游的新途径的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!