一、前提

1、在命令行使用nvidia-smi查看gpu设备情况,当存在空闲设备时才能用,否则会出现运行内存不够出错的情况(具体参考文章GPU之nvidia-smi命令详解);

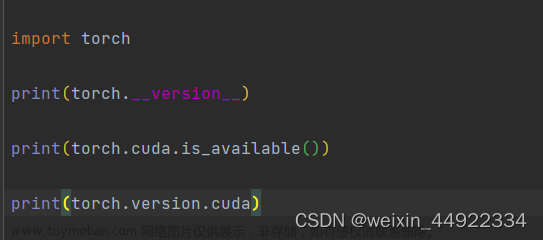

2、安装好cuda和cudcnn(具体步骤请参考:①windows:CUDA安装教程(超详细)),②linux:linux安装CUDA+cuDNN)

在命令行输入nvcc -V或者nvcc --version检查是否安装成功:

文章来源:https://www.toymoban.com/news/detail-589370.html

文章来源:https://www.toymoban.com/news/detail-589370.html

二、命令行直接指定

运行python文件时,在前面加上 CUDA_VISIBLE_DEVICES=xxx,xxx是你要指定的gpu序号。如CUDA_VISIBLE_DEVICES=0,2 python extract_masks.py表示指定了0、2号两个gpu。注意,序号是从0开始排的,所以如果你只有一个gpu,那么就是CUDA_VISIBLE_DEVICES=0 python extract_masks.py。

三、在python文件中指定

在需要运行的python文件最开始加上两行如下,等号后面的数字同上所述。

import os

os.environ["CUDA_VISIBLE_DEVICES"] = "0,2,3"

# 注意:这两行代码必须在文件的最开头,在加载各种包之前

四、如何使用

在python文件中,定义需要加速的模型之后,加上:

model = ......

model.train(True) or model.train(False) # 看你是要训练还是测试

model.to('cuda') # 或者model.cuda()

# 后面需要输入model的变量也是需要.to('cuda')或者.cuda()的,不然会报错既用了cpu又用gpu,不兼容

参考自python指定gpu运行文章来源地址https://www.toymoban.com/news/detail-589370.html

到了这里,关于深度学习之python使用指定gpu运行代码的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!