感谢清华大学开源的ChatGLM2-6B软件,让我们国人有属于自己的AI聊天机器人,期待新版本的推出。

前期准备:

1.电脑配置 (低于以下配置无法安装)

python版本要求:3.8以上

没有安装python的没有关系,我们在下面安装anaconda中会自动生成python,有了python的建议删除,通过anaconda安装python以便于后面创建虚拟环境。

windows系统:Windows 10 以上,推荐N卡(NVIDIA显卡20系列以上)

注意:处理器为AMD容易报错,intel的不容易报错,配置越高最后的响应速度越快。

查看:按住win+e,点此电脑,右键点属性即可查看自己电脑系统和配置

显卡:6G以上GPU

如何看电脑的显卡内存(操作如下):

按住Ctrl + Shift + ESC跳出界面,选择性能,选择GPU0/GPU1

查看专属GPU内存:因为ChatGLM2内存要求6GB以上才可以发挥出性能要求。

下表为ChatGLM2-2B的根据显存大小决定的问答性能。

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

2.安装anaconda

从anaconda官网,推荐最新版anaconda,下载链接: anaconda,进去之后点Download。细节具体教程详见: anaconda安装教程

自动配置环境变量是一定要打勾的,对自己不会配置环境变量的人!

安装完成之后:win + R 输入cmd调出命令框。

输入命令1:

conda -V

出现conda的版本如下:

输入命令2:

python

出现python版本如下:

这里anaconda就安装完毕了,关闭命令框即可。

3.安装对应版本的CUDA

按住win + R 调出命令终端,输出cmd

查看你NVIDIA版本,命令如下:

nvidia-smi

查看到本机可装CUDA版本最高为12.0,版本向下兼容,意思就是CUDA 12.0及以下版本的都可以安装,但一般不建议使用最新版本的。

CUDA安装链接如下: CUDA.

选择CUDA Toolkit11.8.0

根据自己的win系统选择对应的下载即可。

具体教程见:链接: CUDA安装教程.

安装完后,注意需要看下系统环境变量中地址有没有相应版本的cuda,比如我的电脑就是配置了下面几个环境变量 (我之前安装11.7,现在推荐11.8)

除上面两个之外 ,还可以加入以下环境变量,以保证不会出错。我没配置下面两个,也没出错,所以大家根据实际情况选择是否加入下面两个环境配置。

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.7\extras\CUPTI\lib64

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.7\include

不配置可能会报错,Could not load dynamic library ‘cudart64_110.dll’; dlerror: cudart64_110.dll not found

同理,如上:win+R输出cmd 调出命令行

输入命令1:

nvcc -V

出现NVIDIA版本号为你下载的版本号一致即可,关闭命令框。

4.配置ChatGLM2-6B Conda环境

按照上面步骤安装完了anaconda之后,按住win + R输入cmd。输入以下命令,新建一个名字为ChatGLM2B的环境。

conda create --name ChatGLM2B python==3.8.10

新建环境过程中选择y,进入下一步

安装成功之后如下:

激活ChatGLM的环境

conda activate ChatGLM2B

此时你的前面就出现了一个如下图(ChatGLM2B的虚拟环境):

6.现在在虚拟环境下安装pytorch(版本一致)

接上述(ChatGLM2B虚拟环境)命令框:安装GPU版本的pytorch,(上面我们的CUDA安装的11.8版本),pytorch也要选择11.8版本,否则后面开始报错),链接如下: pytorch.

在命令行输入下面命令即可:torch11.8版本

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

运行结果如下:

输入y:

出现done,下载即完成:

如何在下面命令行输入下面命令:

python

出现python版本:

依次在输入:

import torch

print(torch.cuda.is_available())

出现True即为安装成功

输入:

exit()

重新回到ChatGLM2的虚拟环境。

ChatGLM2-6B最新版模型环境部署及安装

1.源码下载

方法1:ChatGLM2-6B 链接:ChatGLM2-6B.

有时候没有魔法上网进不去

点Code,点Dowmload ZIP,即可下载。

方法2:直接使用git命令clone (这个需要Git软件)

想采用这种方式下的小伙伴先下一个Git,具体教程: Git下载安装.

下载之后以后就可以git clone了

git clone https://github.com/THUDM/ChatGLM-6B.git

下载不了的小伙伴们也没有关系,我已经将所有ChatGLM2-6B所需的所有插件都打开放入百度网盘,如果需要请关注抖音号:cqupt_xr_1213。

下载完成之后,将下载好的文件放在除C盘之外的磁盘里面,推荐E/F盘

我的如下:

在该路径下新建一个model文件 (为了后面的12G的模型下载):

2.ChatGLM2-6B的模型下载

从: hugging face.下载所有文件,放在model文件下。 (全部下就对了)

其中模型文件(大于 1G 的)如果下载速度慢,可以在国内清华云源中单独下载这几个模型文件(其他这个源没有的文件还是需要在 huggingface 上下载)

国内清华云源链接: 镜像文件.

下载之后,放到model文件下,显示如图:

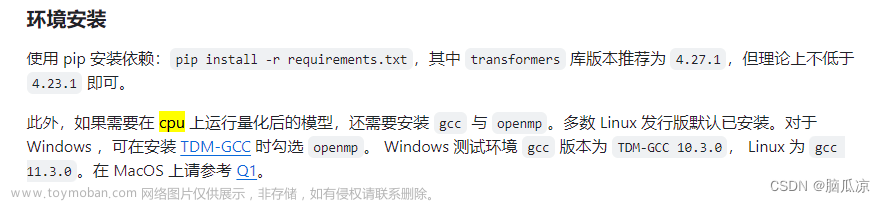

3.相关库安装:

接上面的虚拟环境命令框,最先是C盘,我们切换在自己下的盘,输入E:。

不会切盘的去搜网上教程

在虚拟环境下进入ChatGLM-6B安装的目录

输入命令:

pip3 install -r requirements.txt

直到出现successfully built ffmpy即可:

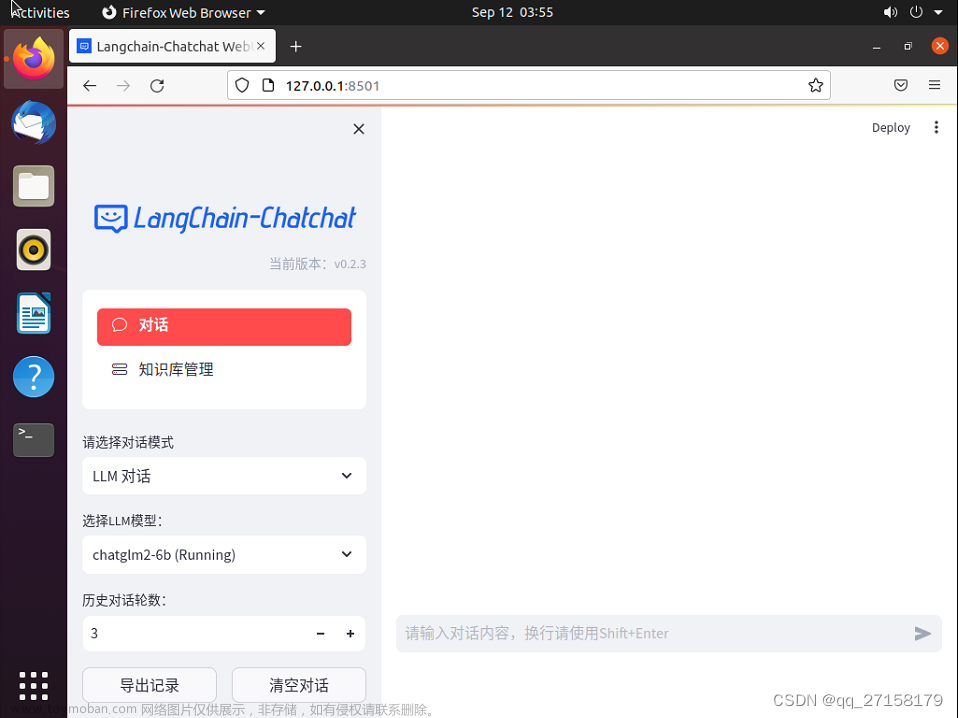

4.修改web_demo.py的数据

在运行之前,需要先修改web_demo.py文件中的模型地址,具体为第5行与第6行,具体如下:没有pycharm的我们用记事本打开

修改为:我的显存为6G,所以我改为4 bit量化

温馨提示,根据实际显卡显存 (如何看自己的显存,前面我已经讲过了,自己的显存要和下面代码对应,不对应就会报错并且烧坏显卡,注意注意!!),可以更改第6行关于model运行方式:

# 6G 显存可以 4 bit 量化

model = AutoModel.from_pretrained("model", trust_remote_code=True).half().quantize(4).cuda()

# 10G 显存可以 8 bit 量化

model = AutoModel.from_pretrained("model", trust_remote_code=True).half().quantize(8).cuda()

# 14G 以上显存可以直接不量化,博主显存为16G选择的就是这个

model = AutoModel.from_pretrained("model", trust_remote_code=True).half().cuda()

在终端输入命令,注意不要用python3,因为可能会使用到其它环境下的python。

python web_demo.py

接着浏览器会自动打开:

视频如下:

搭建就完成了,如果要调用API的详情请参考Github的API部署。文章来源:https://www.toymoban.com/news/detail-590945.html

参考资料

ChatGLM-6B博客.

GitHub的ChatGLM2-6B链接.文章来源地址https://www.toymoban.com/news/detail-590945.html

到了这里,关于清华大学开源ChatGLM2-6B开源模型在anaconda下的虚拟环境详细部署及安装教程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!