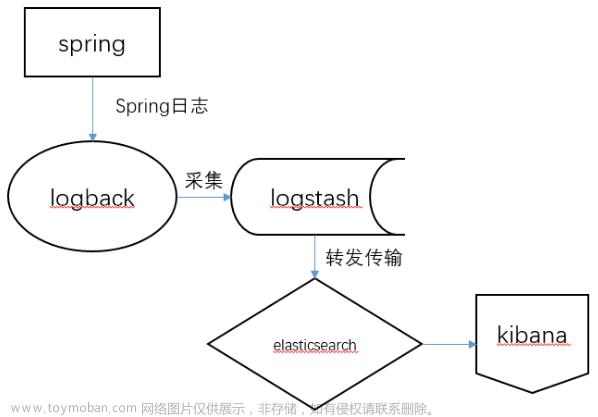

Springboot 使用logback直接将日志写入Elasticsearch,再通过kibana查看

正常情况下,一般组合为elk 即日志会通过logstash写入es,但本文主要为轻量级项目直接利用appender写入Elasticsearch

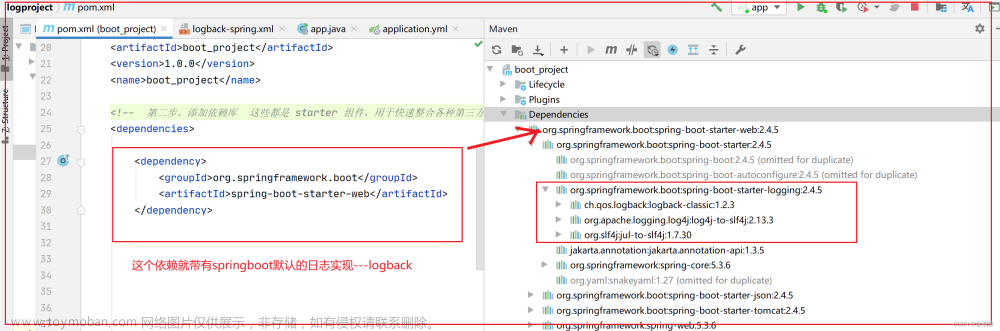

1. 导入依赖

<!--日志elasticsearch-->

<dependency>

<groupId>com.internetitem</groupId>

<artifactId>logback-elasticsearch-appender</artifactId>

<version>1.6</version>

</dependency>

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>4.11</version>

</dependency>

2. 配置logback-spring.xml

如果没有则添加logback-spring.xml到resource目录的根目录下

<?xml version="1.0" encoding="UTF-8"?>

<configuration debug="false">

<!--定义日志文件的存储地址 -->

<property name="LOG_HOME" value="./logs"/>

<!--读取项目启动的环境是哪一个 -->

<springProperty scope="context" name="active" source="spring.profiles.active" defaultValue="dev"/>

<!-- 控制台输出 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符 -->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %highlight(%-5level) %cyan(%logger{50}:%L) - %msg%n</pattern>

</encoder>

</appender>

<!-- 按照每天生成日志文件 -->

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<!--日志文件输出的文件名 -->

<FileNamePattern>${LOG_HOME}/jeecgboot-%d{yyyy-MM-dd}.%i.log</FileNamePattern>

<!--日志文件保留天数 -->

<MaxHistory>30</MaxHistory>

<maxFileSize>10MB</maxFileSize>

</rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符 -->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50}:%L - %msg%n</pattern>

</encoder>

</appender>

<appender name="ELASTIC" class="com.internetitem.logback.elasticsearch.ElasticsearchAppender">

<url>http://es账号:es密码@esip:9200/_bulk</url>

<index>xxx-log-${active}</index> <!-- 根据启动环境为索引命名,区分各个环境日志 -->

<type>${active}</type>

<connectTimeout>30000</connectTimeout> <!-- optional (in ms, default 30000) -->

<errorsToStderr>false</errorsToStderr> <!-- optional (default false) -->

<includeCallerData>false</includeCallerData> <!-- optional (default false) -->

<logsToStderr>false</logsToStderr> <!-- optional (default false) -->

<maxQueueSize>104857600</maxQueueSize> <!-- optional (default 104857600) -->

<maxRetries>3</maxRetries> <!-- optional (default 3) -->

<readTimeout>30000</readTimeout> <!-- optional (in ms, default 30000) -->

<sleepTime>250</sleepTime> <!-- optional (in ms, default 250) -->

<rawJsonMessage>false</rawJsonMessage> <!-- optional (default false) -->

<includeMdc>false</includeMdc> <!-- optional (default false) -->

<maxMessageSize>-1</maxMessageSize> <!-- optional (default -1 -->

<authentication class="com.internetitem.logback.elasticsearch.config.BasicAuthentication"/> <!-- optional -->

<properties>

<property>

<name>host</name>

<value>${HOSTNAME}</value>

<allowEmpty>false</allowEmpty>

</property>

<property>

<name>level</name>

<value>%level</value>

</property>

<property>

<name>thread</name>

<value>%thread</value>

</property>

<property>

<name>stacktrace</name>

<value>%ex</value>

</property>

<property>

<name>logger</name>

<value>%logger</value>

</property>

<property>

<name>env</name>

<value>${active}</value>

</property>

</properties>

<headers>

<header>

<name>Content-Type</name>

<value>application/json</value>

</header>

</headers>

</appender>

<!--myibatis log configure -->

<logger name="com.apache.ibatis" level="DEBUG"/>

<logger name="java.sql.Connection" level="DEBUG"/>

<logger name="java.sql.Statement" level="DEBUG"/>

<logger name="java.sql.PreparedStatement" level="DEBUG"/>

<springProfile name="dev">

<root level="INFO">

<appender-ref ref="STDOUT"/>

</root>

</springProfile>

<springProfile name="test">

<root level="INFO">

<appender-ref ref="FILE"/>

<appender-ref ref="ELASTIC"/>

</root>

</springProfile>

<springProfile name="uat,prod">

<root level="INFO">

<appender-ref ref="ELASTIC"/>

</root>

</springProfile>

</configuration>

3. 定义日志等级

logging:

level:

root: info

另外我们也可以在root部分不适用es记录日志而在需要的代码中用如下方式记录日志

@RestController @RequestMapping("log") public class EsLoggerController { private Logger logger = LoggerFactory.getLogger("es-logger"); @GetMapping("log") public ApiResult<String> log() { logger.warn ("eslogger"); return ApiResult.success ("done!"); } }

4. 启动程序测试

可以自动创建索引,不用手动创建

5. kibana创建索引模式

以上步骤完成后即可在kibana的discover菜单查找到我们的日志索引,在这里进行可视化的查找日志文章来源:https://www.toymoban.com/news/detail-592100.html

文章来源地址https://www.toymoban.com/news/detail-592100.html

文章来源地址https://www.toymoban.com/news/detail-592100.html

到了这里,关于Springboot 使用logback直接将日志写入Elasticsearch,再通过kibana查看的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!