前排提醒,目前我们能 “用 ppo 四分钟训练 ant 到 6000 分”,比本文的 3 小时快了很多很多,有空会更新代码

https://blog.csdn.net/sinat_39620217/article/details/131724602

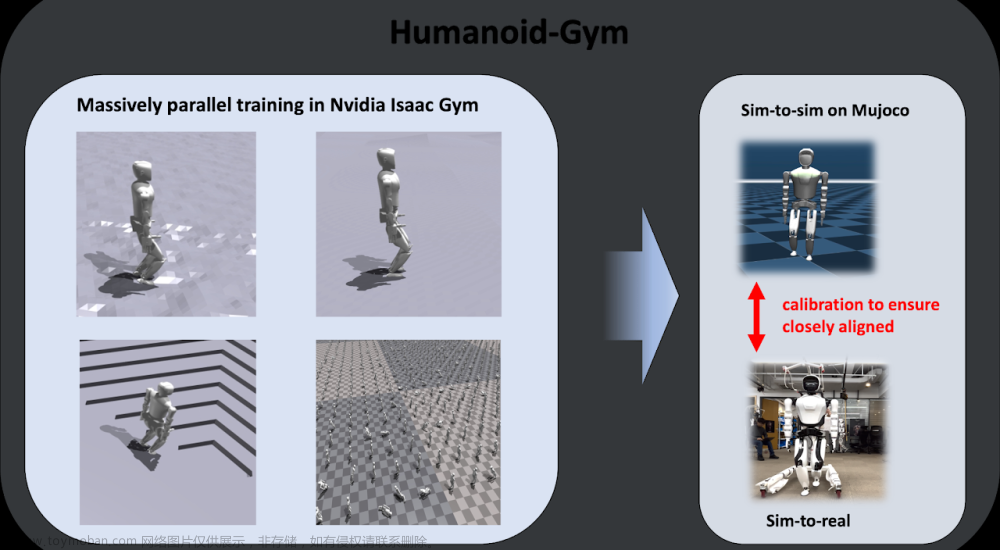

介绍了 Isaac Gym 库 如何使用 GPU 做大规模并行仿真,对环境模块提速。这篇帖子,我们使用 1 张 A100GPU 在 3 个小时之内,把 Ant 机器人训练到 6000 分以上,并开源了代码。希望对社区成员提供帮助。

文章来源:https://www.toymoban.com/news/detail-594619.html

文章来源:https://www.toymoban.com/news/detail-594619.html

而这一篇帖子,我们开源了 GPU 并行仿真环境 Isaac Gym 的强化学习库小雅 ElegantRL 的训练代码。并在文章结尾贴上了我们的多个训练结果。想要在 GPU 并行环境上训练强化学习算法,并发挥出 GPU 仿真环境的全部潜力,需要对强化学习的代码做一些较大的改动,所以我们将代码发布在了 ElegantRL 这个强化学习库的 develop 分支里,收集使用反馈后,我们会将它整合到 master 分支里,如果大家想贡献代码,也可以直接 pull request 提自己的分支。我们社区的核心成员会对代码进行审核,提出调整意见。(运行下方代码的 demo_Isaac_Gym.py 就可以训练了)文章来源地址https://www.toymoban.com/news/detail-594619.html

1.用 GPU 并行环境 Isaac Gym + 强化学习库 ElegantRL

到了这里,关于用 GPU 并行环境 Isaac Gym + 强化学习库 ElegantRL:训练机器人Ant,3小时6000分,最高12000分的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!